服务器配置:双卡 Nvidia A100 GPU

以下是我们测试中使用的双 Nvidia A100 GPU 服务器的主要规格:

服务器配置:

- 价格:¥9,958.99/月

- CPU: 双 18 核 E5-2697v4 处理器(共 36 核 / 72 线程)

- 内存: 256GB RAM

- 存储: 240GB SSD + 2TB NVMe + 8TB SATA

- 网络: 1Gbps

- 操作系统: Windows 10 Pro

GPU 详情:

- GPU: 双卡Nvidia A100

- 微架构: Ampere

- 计算能力:8.0

- CUDA 核数:每张显卡 6912 个

- 张量核心(Tensor Cores):432 个

- 显存: 每张显卡 40GB HBM2

- 单精度浮点性能(FP32 Performance):每张显卡 19.5 TFLOPS

双 A100 GPU 提供总计 80GB 的显存,非常适合高效运行大型语言模型。该配置使我们能够以合理的速度和效率处理参数量高达 110B 的模型。

👉使用双 A100 GPU 对 LLM 进行基准测试

我们使用 Ollama 0.5.7 测试了多种模型,包括 DeepSeek-R1(14B~70B)、LLaMA 72B、Gemma3(12~27B)以及 Qwen(32B~110B)。以下是 A100×2 配置的性能结果明细:

| 模型 | deepseek-r1 | deepseek-r1 | deepseek-r1 | qwen | qwen | qwen | qwen2 | llama3 | llama3.1 | llama3.3 | gemma3 | gemma3 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 14b | 32b | 70b | 32b | 72b | 110b | 72b | 70b | 70b | 70b | 12b | 27b |

| 大小(GB) | 9 | 20 | 43 | 18 | 41 | 63 | 41 | 40 | 43 | 43 | 8.1 | 17 |

| 量化 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 运行于 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.6.5 | Ollama0.6.5 |

| 下载速度(mb/s) | 117 | 117 | 117 | 117 | 117 | 117 | 117 | 117 | 117 | 117 | 117 | 117 |

| CPU 使用率 | 0% | 2% | 3% | 2% | 1% | 1% | 1% | 2% | 1% | 1% | 1% | 1% |

| 内存性能利用率 | 4% | 4% | 4% | 4% | 4% | 4% | 4% | 3% | 4% | 3% | 4% | 4% |

| GPU 利用率(2 张显卡) | 0%, 80% | 0%, 88% | 44%, 44% | 36%, 39% | 42%, 45% | 50%, 50% | 38%, 37% | 92%, 0% | 44%, 43% | 44%, 43% | 71%, 0% | 87%, 0% |

| 评估速率(每秒处理的 token 数) | 66.79 | 36.36 | 19.34 | 32.07 | 20.13 | 16.06 | 19.88 | 24.41 | 19.01 | 18.91 | 61.56 | 37.95 |

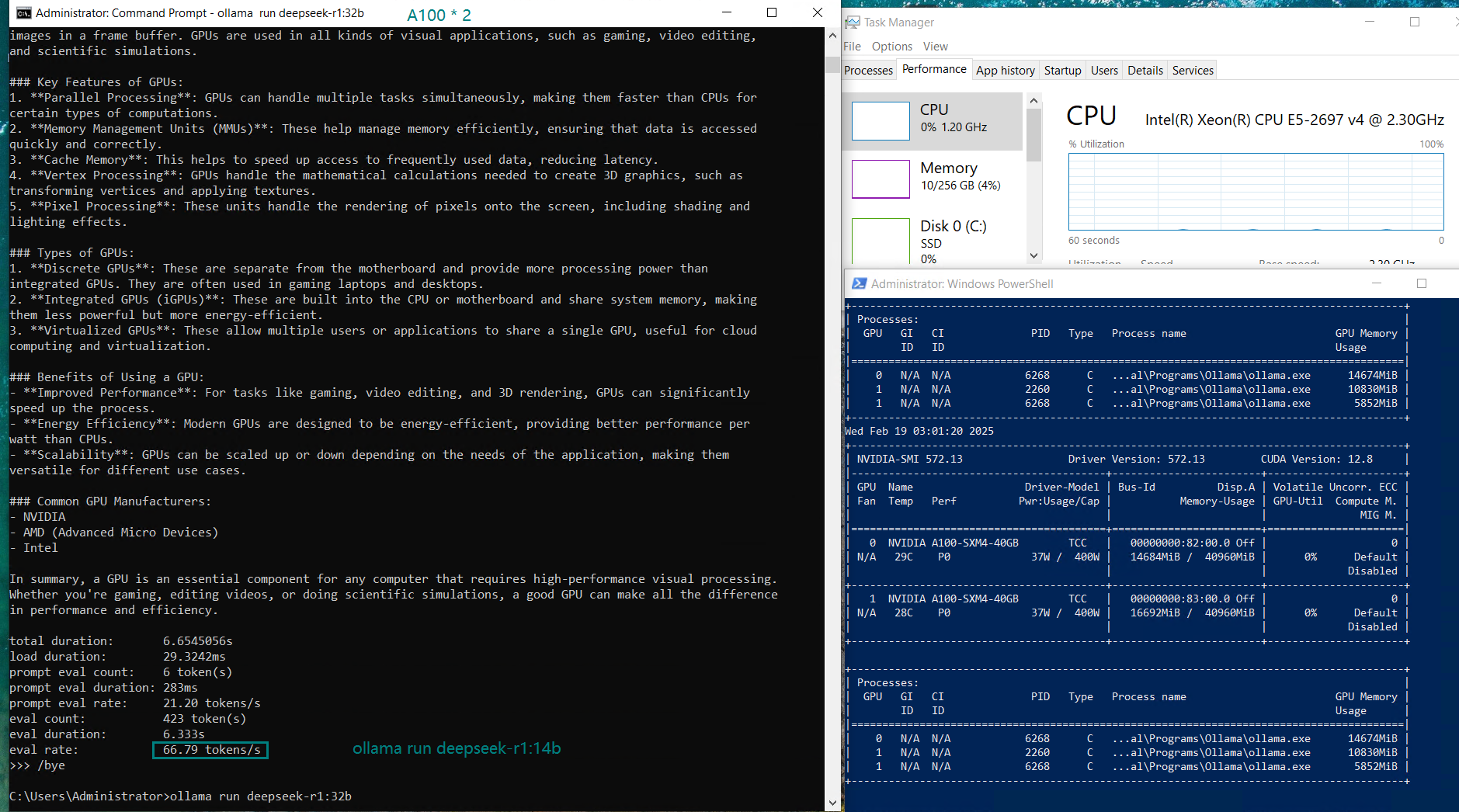

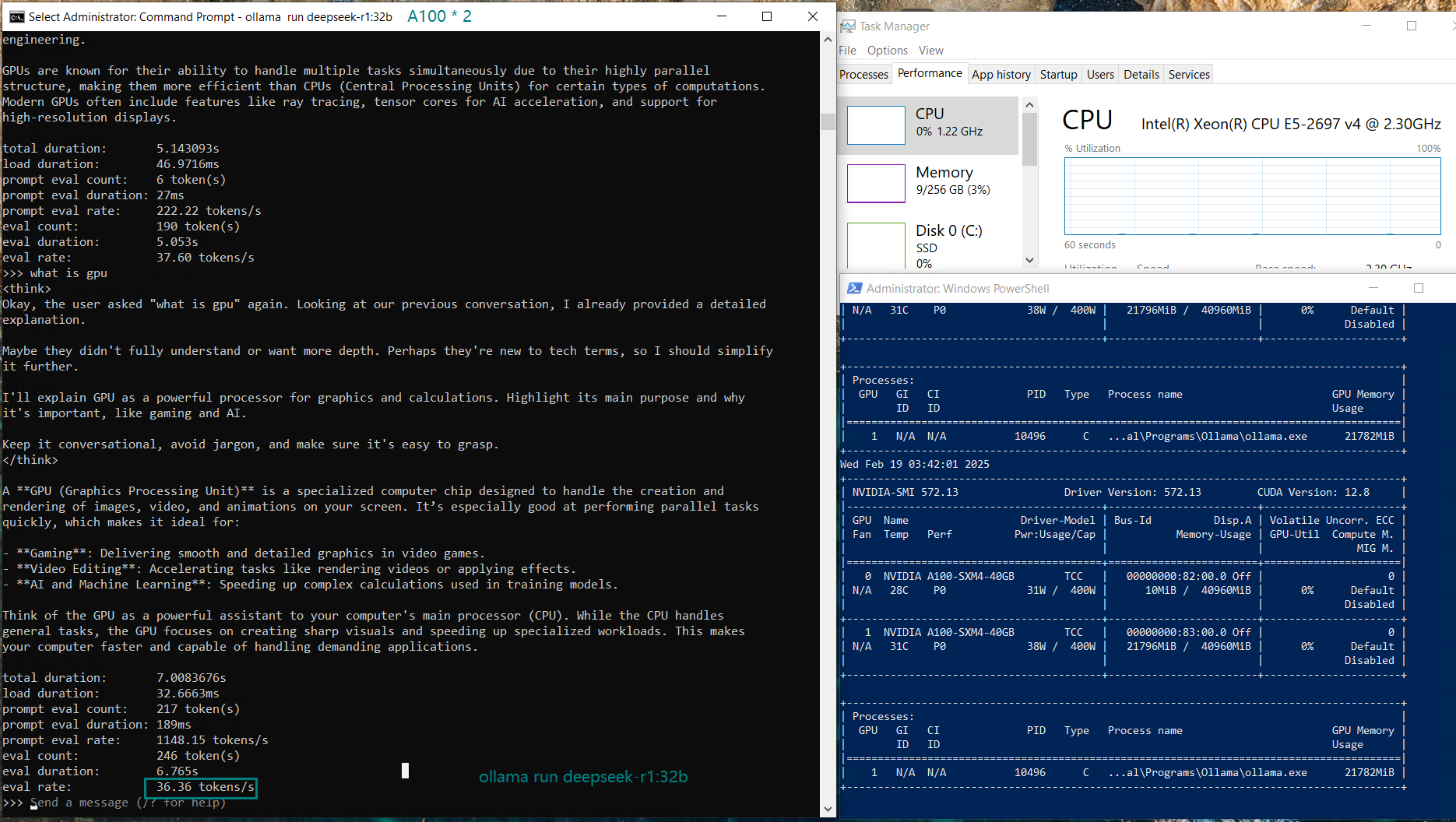

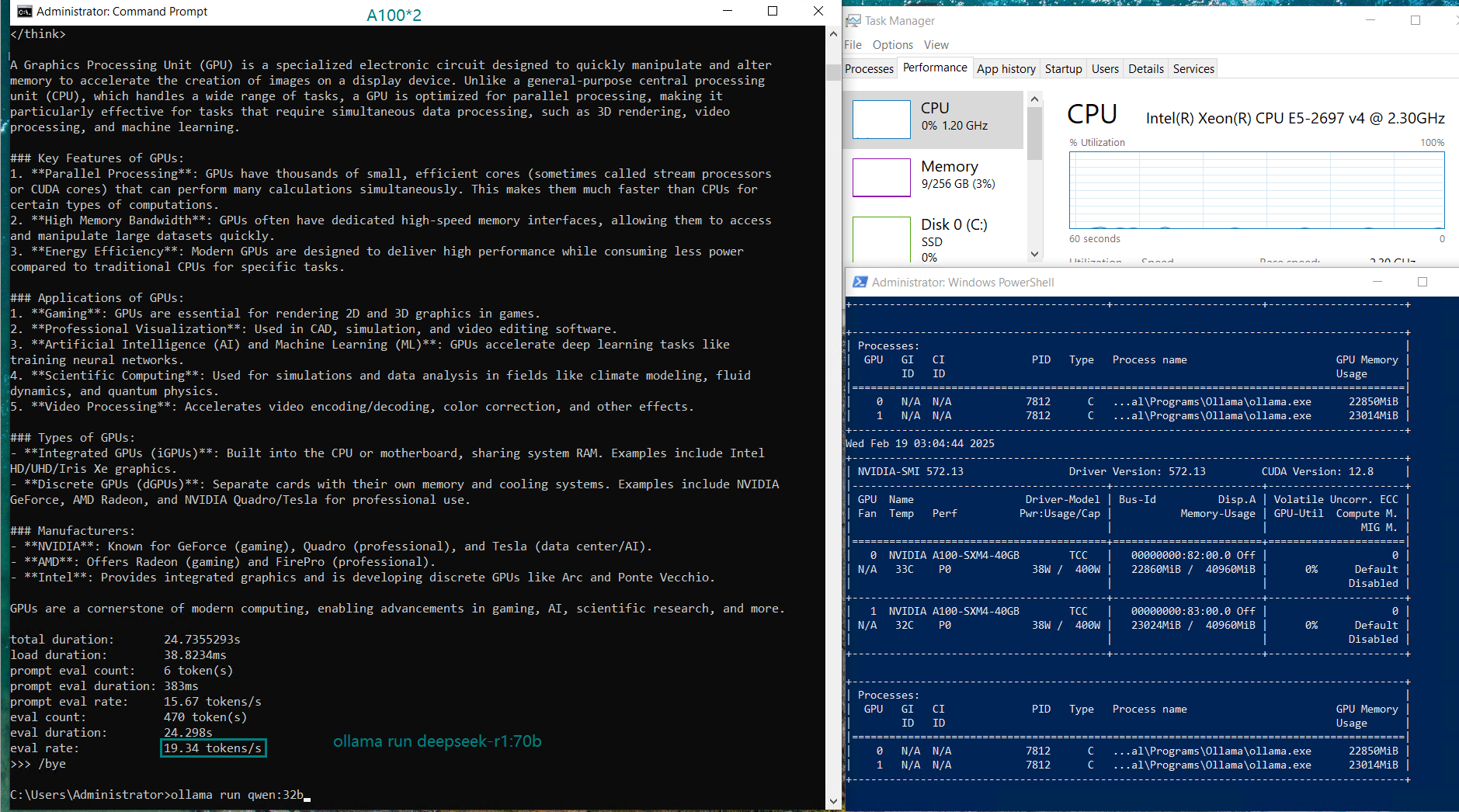

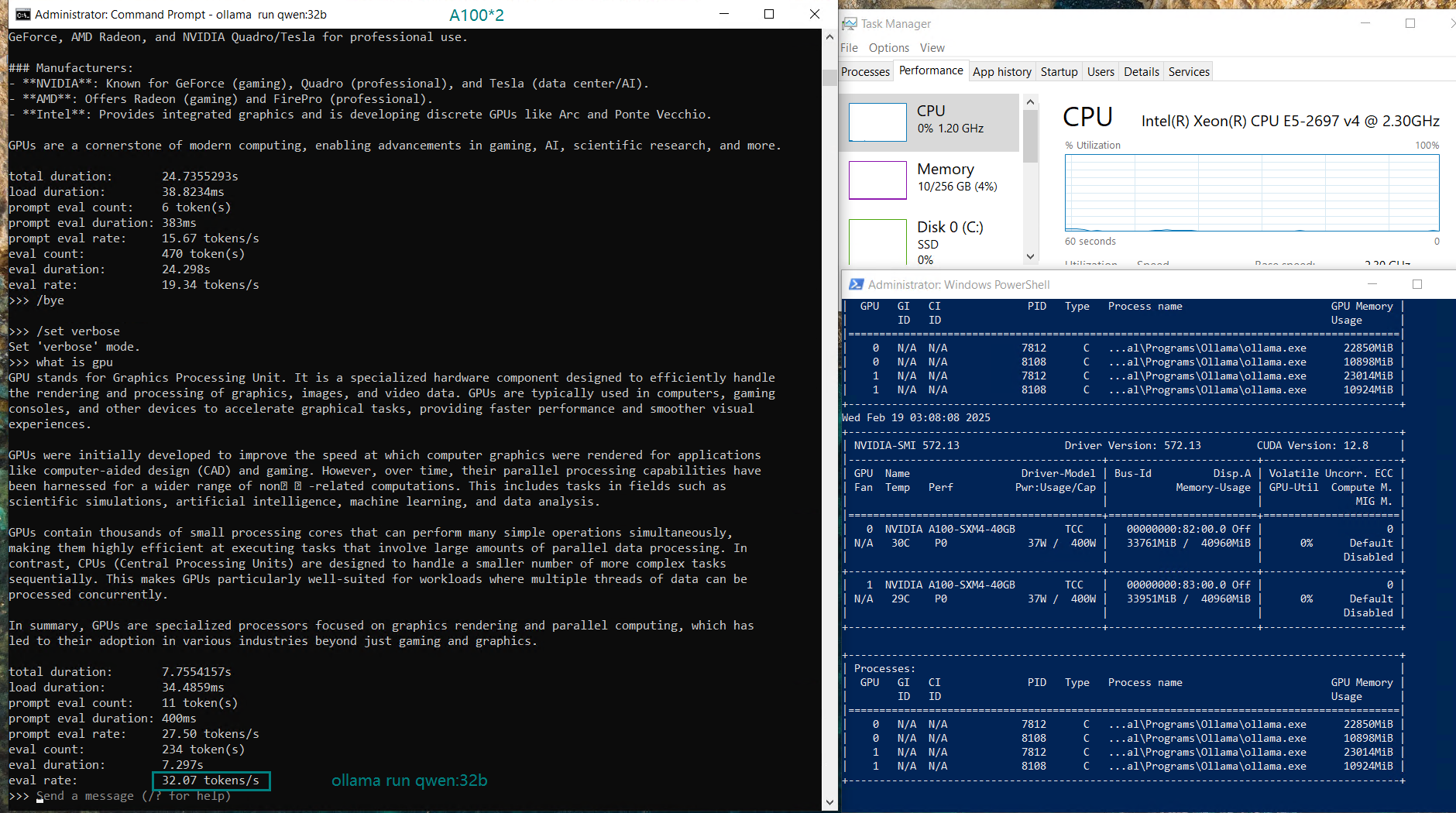

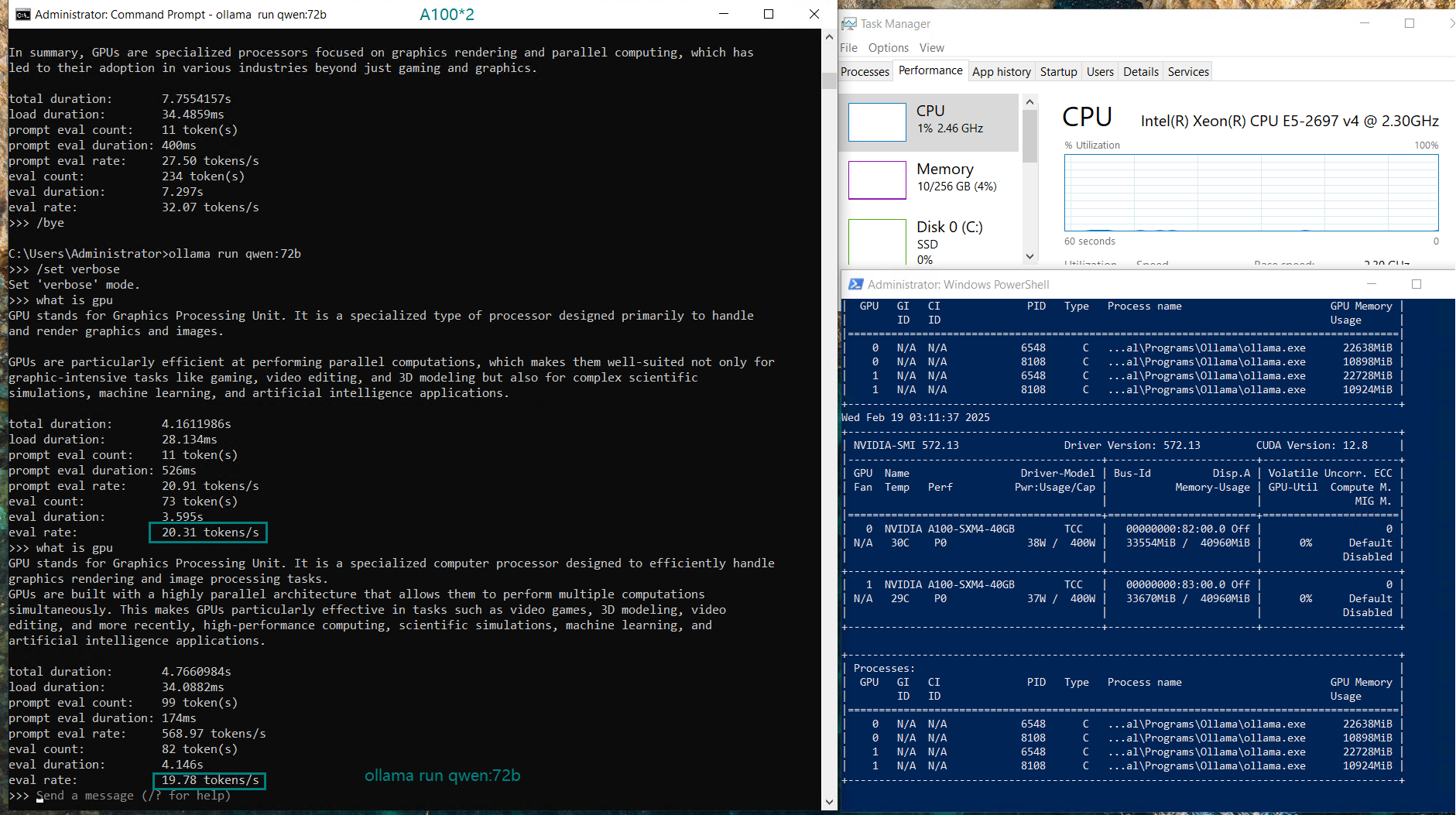

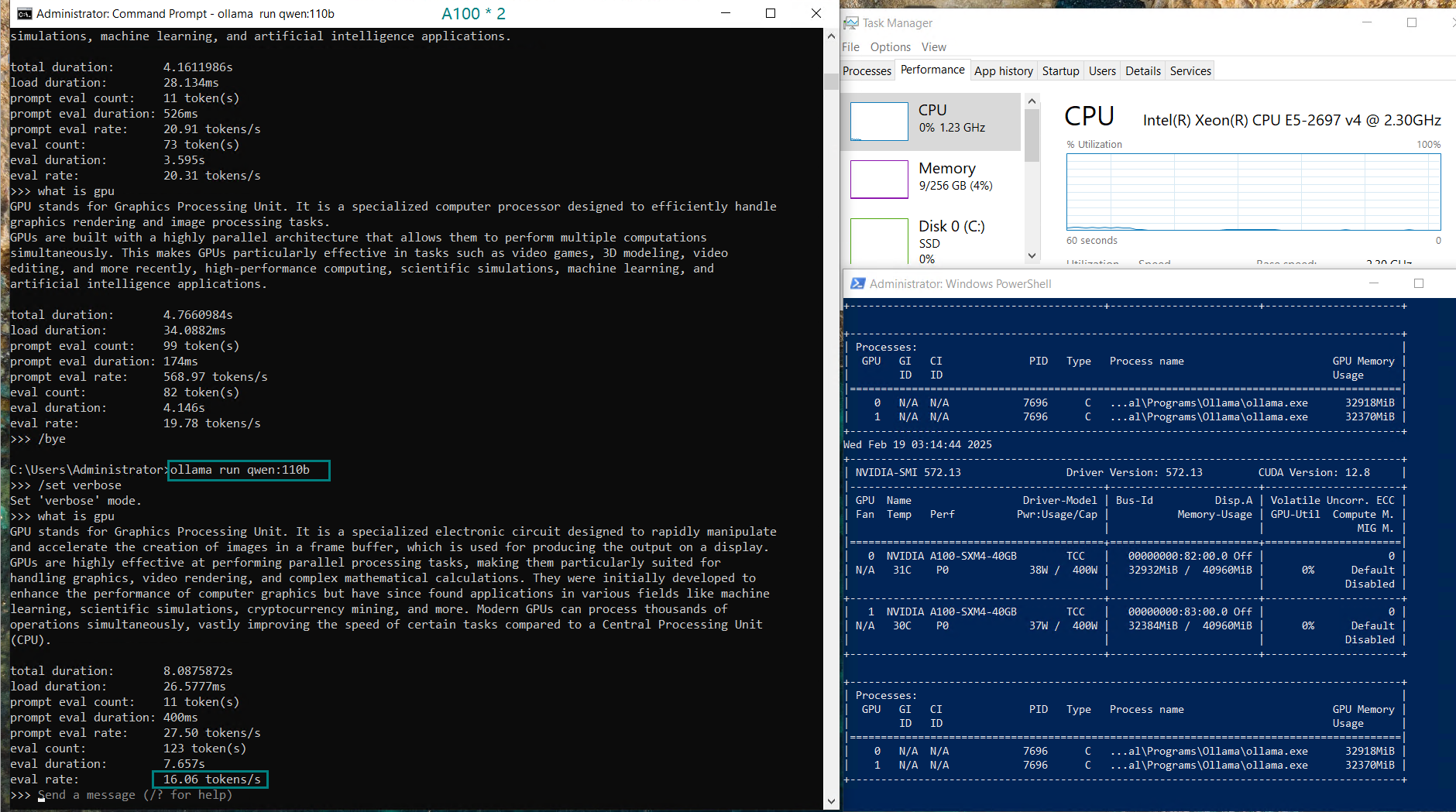

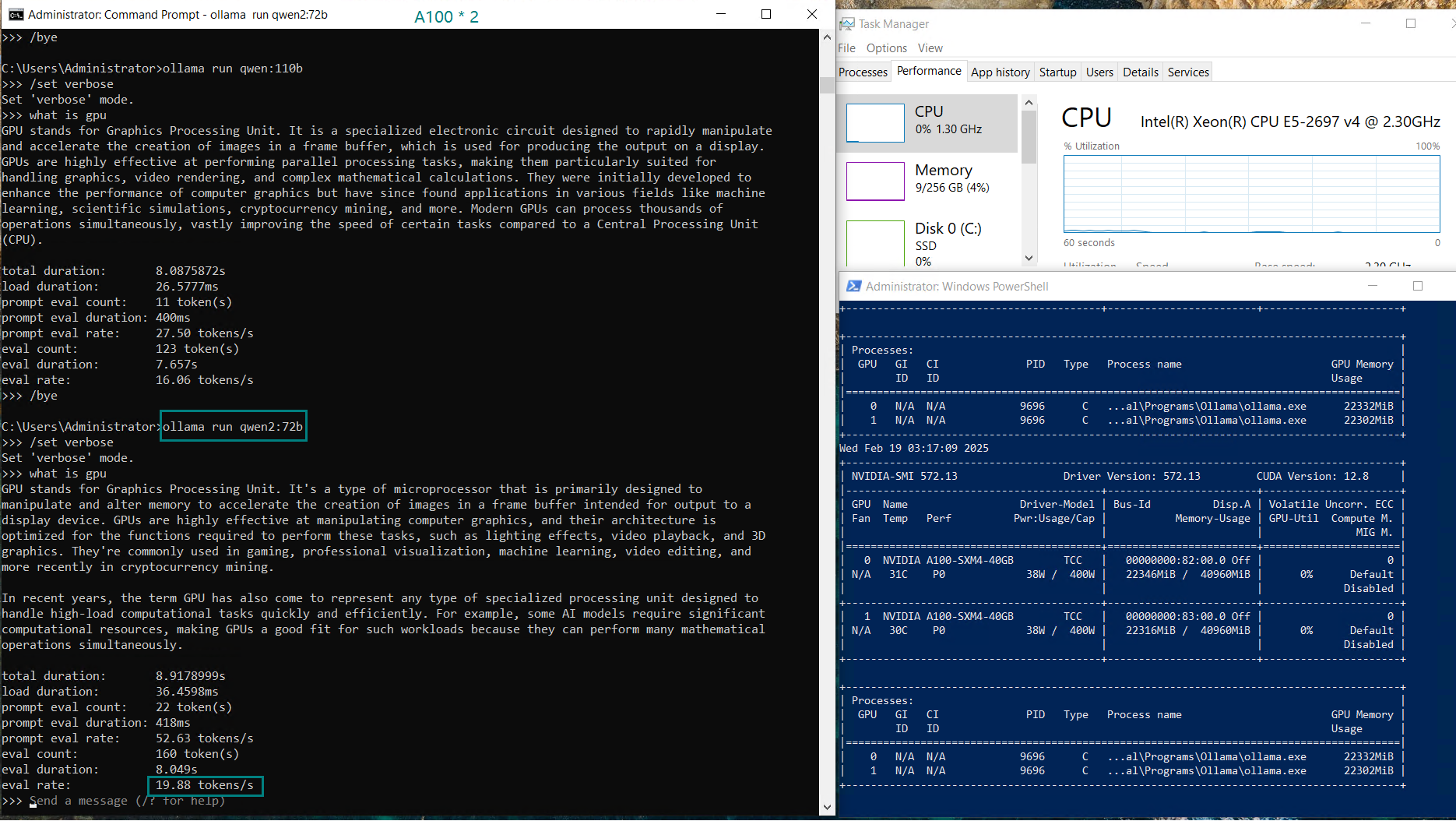

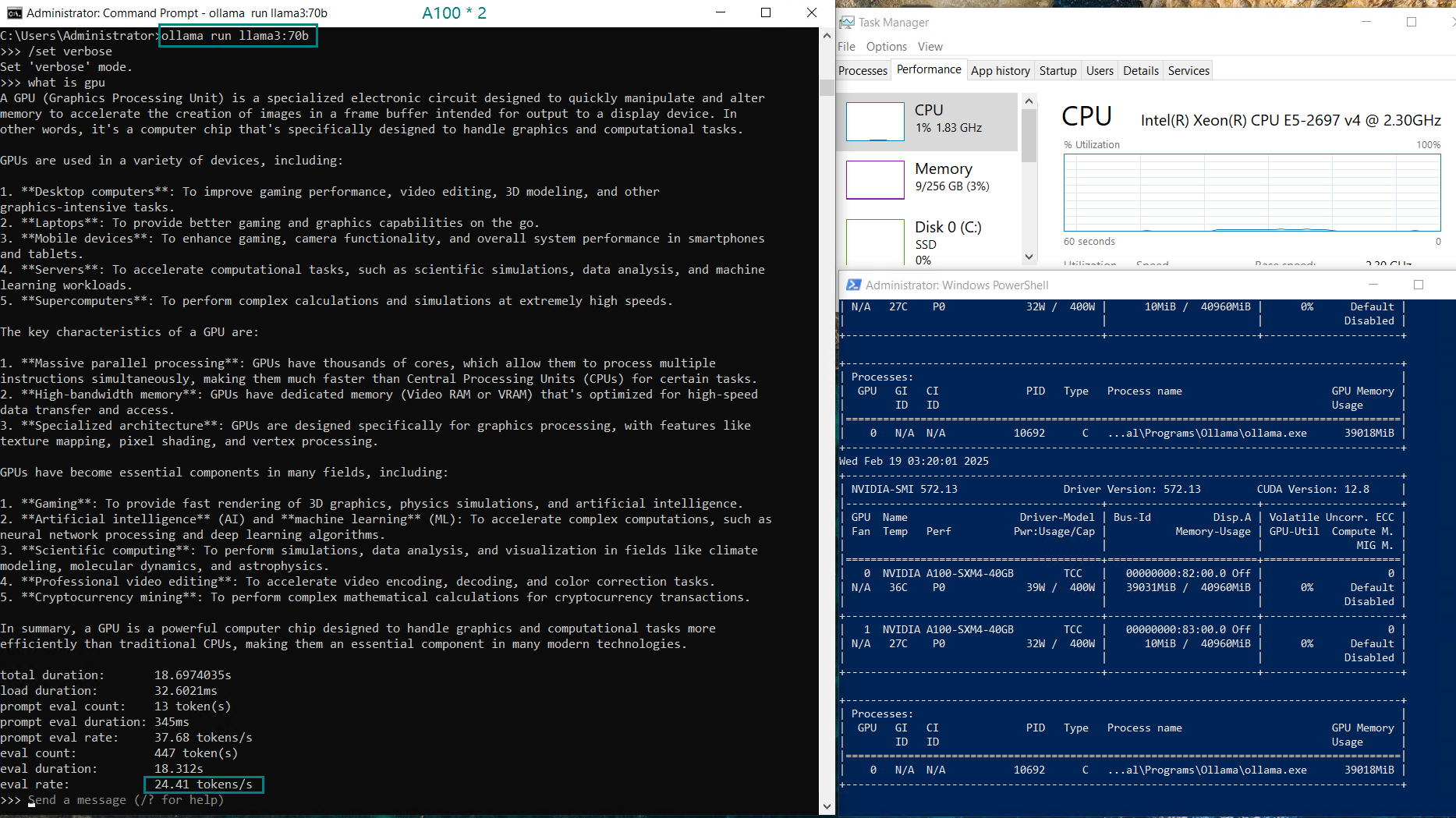

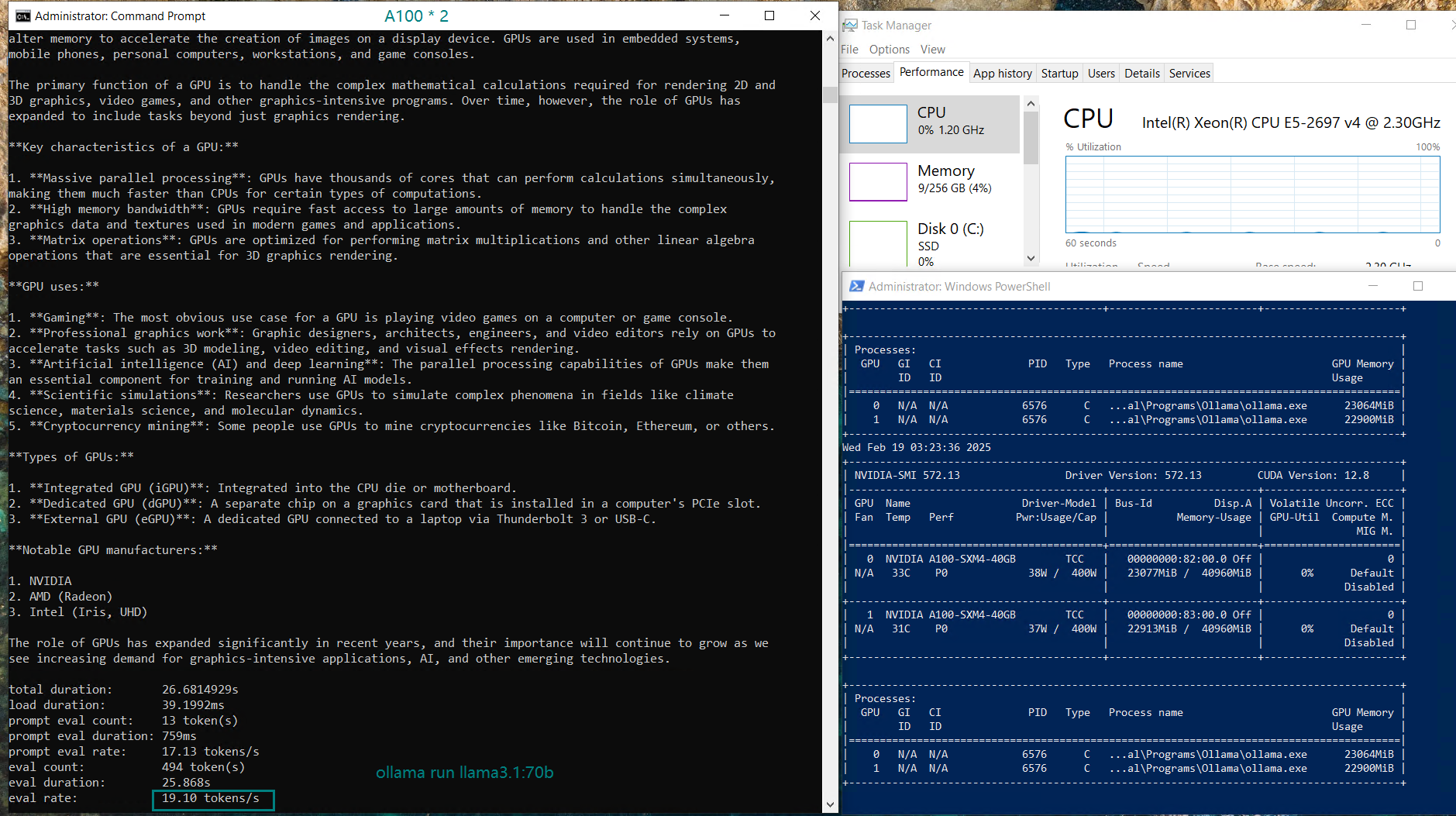

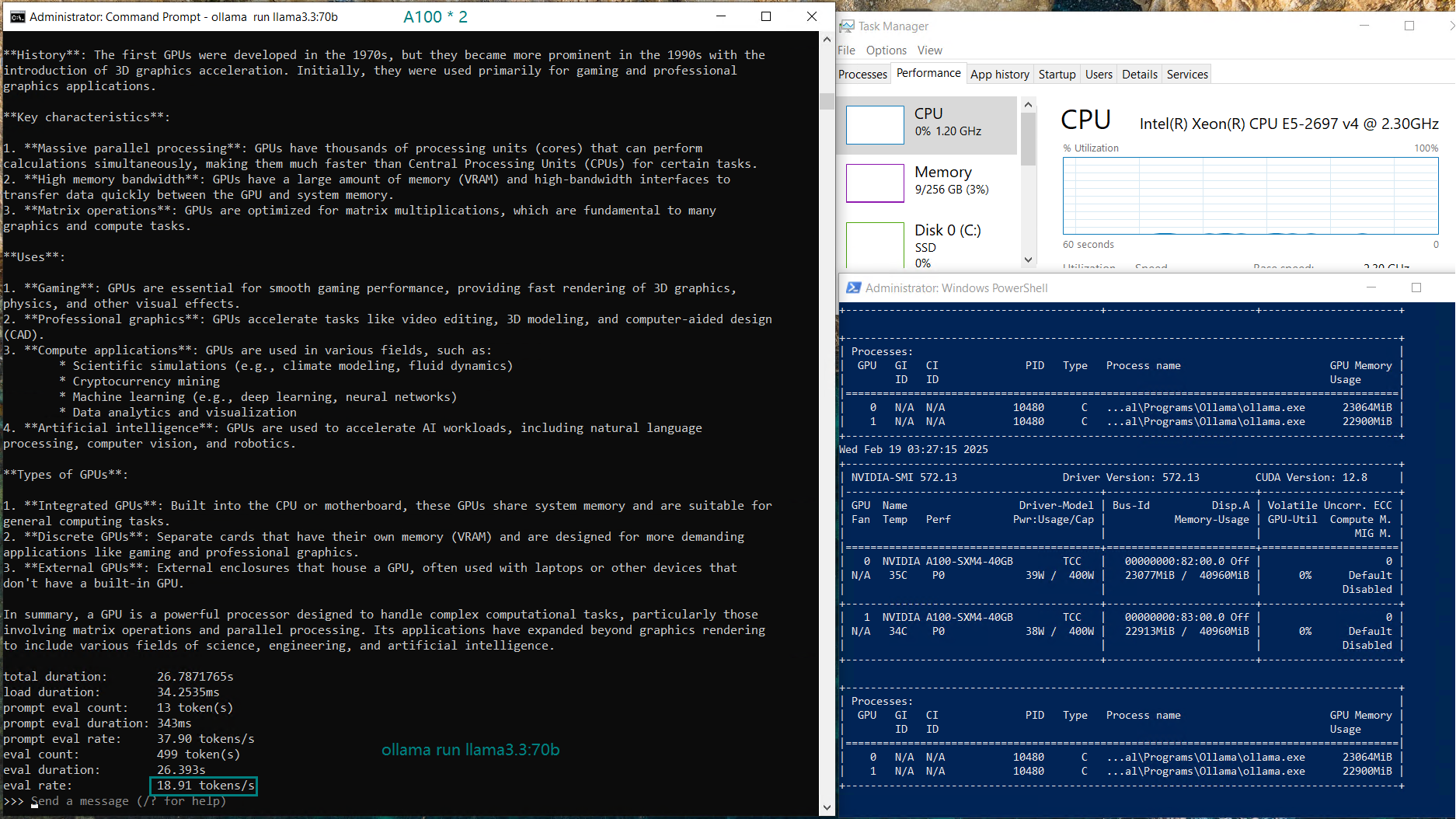

记录双 A100 GPU 服务器的实时资源消耗数据:

在 Ollama 上运行 LLM 时使用双 Nvidia A100 GPU 的截图

分析与洞察:双 A100 GPU 的性能

1️⃣. 70B-110B 的高性能选择

在运行不同规模的 LLM 时,双 Nvidia A100 GPU 展现了令人印象深刻的性能,尤其是在处理高达 70B 参数的模型时表现出色。两张 GPU 提供的 80GB 显存保证了模型能够高效加载和运行,GPU 利用率保持在 40%~50% 之间。

- DeepSeek-R1 在 14B 参数下高效运行,达到 66.79 tokens/s;在 32B 参数下为 36.36 tokens/s。

- Qwen 和 Llama:72B 表现稳定,约 20 tokens/s。

- 在处理 110B 模型(如 Qwen)时,双 A100 GPU 的评估速度会略有下降(16.06 tokens/s)。尽管性能有所降低,但双 A100 的方案相比 H100 仍然具备较高的性价比,特别适合预算有限的 AI 工作负载用户。

2️⃣️. 双 GPU 配置下的 GPU 利用率

在使用双 A100 GPU 运行大模型时,GPU 利用率相比单卡显著下降。在 DeepSeek-R1:32B 和 Qwen:32B 的测试中,我们观察到每张 GPU 的利用率在 40%~45% 之间波动,表明负载被分摊到两张 GPU 上,从而降低了整体性能效率。

相比之下,单 GPU 配置(单张 A100)可以实现更高的利用率和更快的推理速度,因为模型会完整加载到一张 GPU 的显存中。而将模型分割到两张 GPU 上则意味着更高的显存开销和更频繁的 PCI 总线通信,这会引入额外的延迟。

相比之下,单 GPU 配置(单张 A100)可以实现更高的利用率和更快的推理速度,因为模型会完整加载到一张 GPU 的显存中。而将模型分割到两张 GPU 上则意味着更高的显存开销和更频繁的 PCI 总线通信,这会引入额外的延迟。

3️⃣. 多 GPU 配置下的显存分配

多 GPU 配置中的显存分配既有优势也有挑战。虽然双 40GB A100 显卡带来总计 80GB 的显存,可以支持运行更大的模型(如 70B 和 110B),但模型必须分割到多张显卡上,这会带来一定的效率损失。因此,像 DeepSeek-R1:32B 这样的中等规模模型在该配置下表现良好,而 Qwen:110B 等更大规模的模型则因显存分割带来的额外开销而出现性能下降。

4️⃣. A100 与 H100 的对比

每月 ¥9,958.99 的双 A100 GPU 配置在性能与成本比上有很强的优势。A100 能够支持高达 110B 的模型,表现令人惊艳。但如果你的目标是极大规模模型(如 110B+)的顶级性能,那么 H100 会更适合,尽管其价格几乎是 A100 的两倍。

📢 使用双 A100 GPU 托管开启 LLM 之旅

如果你正在寻找 70B~110B 模型推理的优化方案,立即来探索我们的专用服务器托管选项吧!

新年特惠

GPU物理服务器 - A6000

¥ 1924.50/月

立省50% (原价¥3849.00)

月付季付年付两年付

立即订购- CPU: 36核E5-2697v4*2

- 内存: 256GB DDR4

- 系统盘: 240GB SSD

- 数据盘: 2TB NVMe + 8TB SATA

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia RTX A6000

- 显存: 48GB GDDR6

- CUDA核心: 10752

- 单精度浮点: 38.71 TFLOPS

结论

双 Nvidia A100 GPU 服务器是运行参数规模高达 110B 的 LLM 的强大且高性价比的解决方案。它在 Qwen:32B、DeepSeek-R1:70B 和 Qwen:72B 等中大型模型上表现出色,同时相较于 H100 等高端 GPU 具有显著的价格优势。

对于需要处理大规模模型、但又不想承担昂贵高端 GPU 成本的用户来说,A100*2 托管提供了一个在性能与成本之间达到平衡的有力选择。

标签:

Nvidia A100, LLM 托管, AI 服务器, Ollama, 性能分析, GPU 服务器托管, DeepSeek-R1, Qwen 模型, AI 性能, A100 服务器, Nvidia GPU