服务器规格

以下是用于测试的 Nvidia A100 40GB GPU 服务器的硬件配置:

配置详情:

- CPU: 双18核E5-2697v4(共36核72线程)

- 内存: 256GB

- 磁盘: 240GB SSD + 2TB NVMe + 8TB SATA

- 网络: 1Gbps

- 操作系统: Windows 11 Pro

GPU详细信息:

- 型号: Nvidia A100 40GB

- 计算能力: 8.0

- 架构: Ampere

- CUDA核心数: 6912

- Tensor核心数: 432

- 显存: 40GB HBM2

- FP32性能: 19.5 TFLOPS

该服务器配置对于运行32B LLM 非常高效,同时为需要高性能推理的企业提供经济高效的解决方案,通过租用的方式,无需等待,即买即用,无需承担直接购买 GPU 的高昂成本。

基准测试结果:Ollama GPU A100 40GB 性能指标

在我们的测试中,我们使用 Ollama 0.5.7 运行了各种模型,例如 DeepSeek-R1、Qwen 和 LLaMA。下表展示了 A100 40GB GPU 在这些模型上的性能:

| 模型 | deepseek-r1 | deepseek-r1 | deepseek-r1 | llama3.1 | llama2 | llama3 | qwen2.5 | qwen2.5 | qwen | gemma2 | falcon |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 8b | 14b | 32b | 8b | 13b | 70b | 14b | 32b | 32b | 27b | 40 |

| 文件大小(GB) | 4.9 | 9 | 20 | 4.9 | 7.4 | 40 | 9 | 20 | 18 | 16 | 24 |

| 量化程度 | 4位 | 4位 | 4位 | 4位 | 4位 | 4位 | 4位 | 4位 | 4位 | 4位 | 4位 |

| 运行在 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 |

| 模型下载速度(mb/s) | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 |

| CPU 利用率 | 3% | 2% | 2% | 3% | 3% | 3% | 3% | 2% | 1% | 1% | 3% |

| RAM 利用率 | 3% | 4% | 4% | 4% | 4% | 4% | 4% | 4% | 4% | 4% | 4% |

| GPU 利用率 | 74% | 74% | 81% | 25% | 86% | 91% | 73% | 83% | 84% | 80% | 88% |

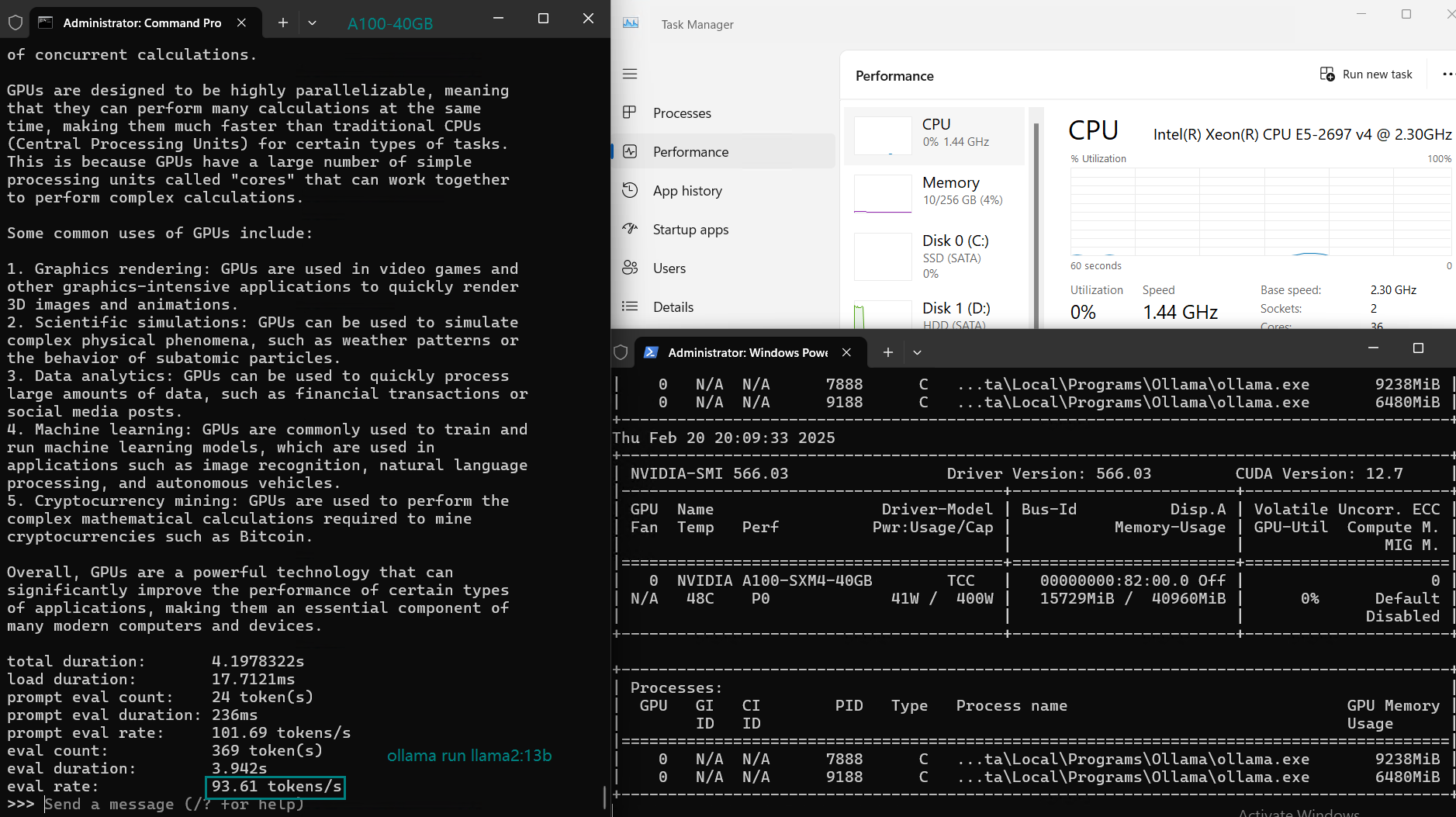

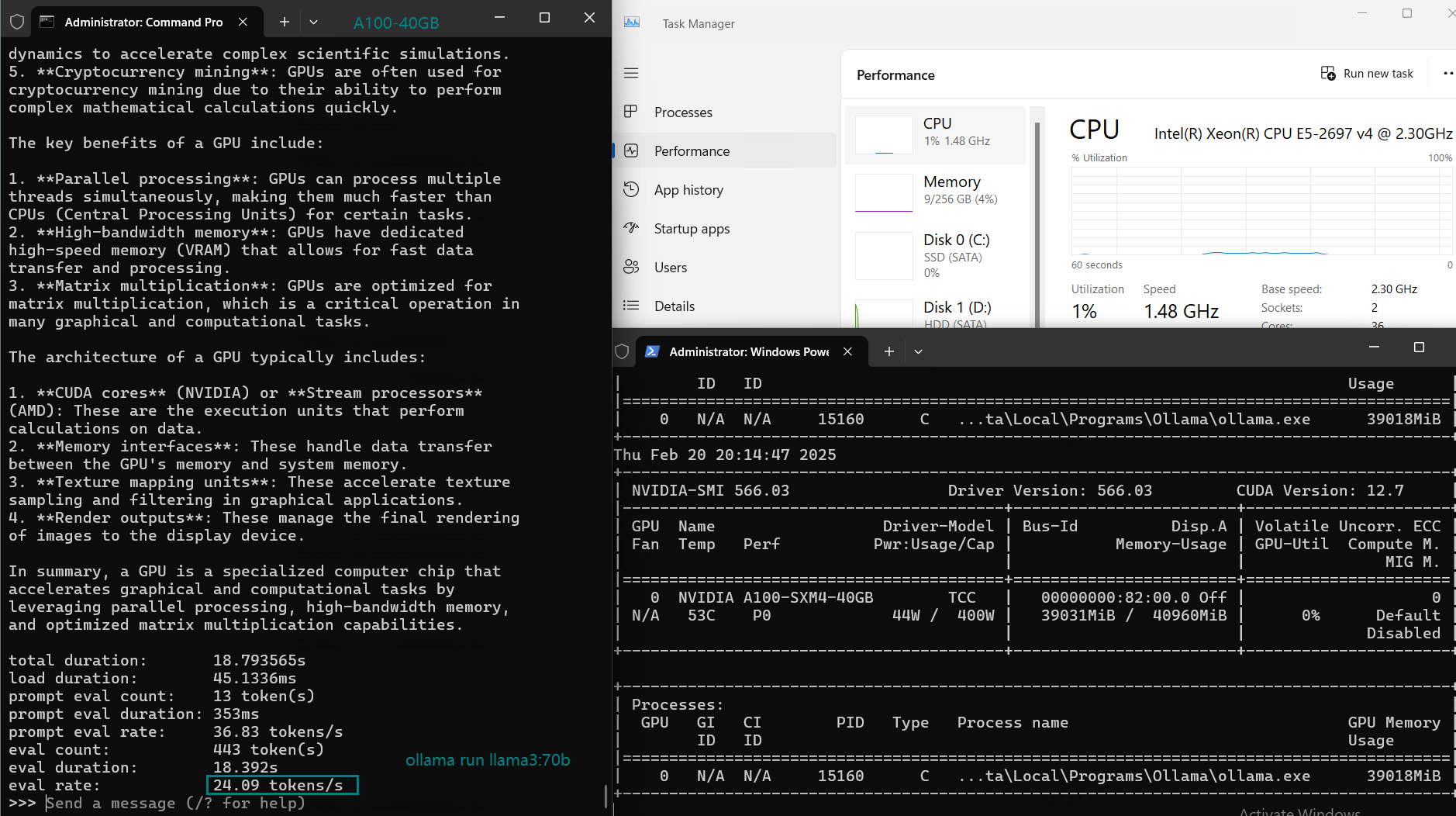

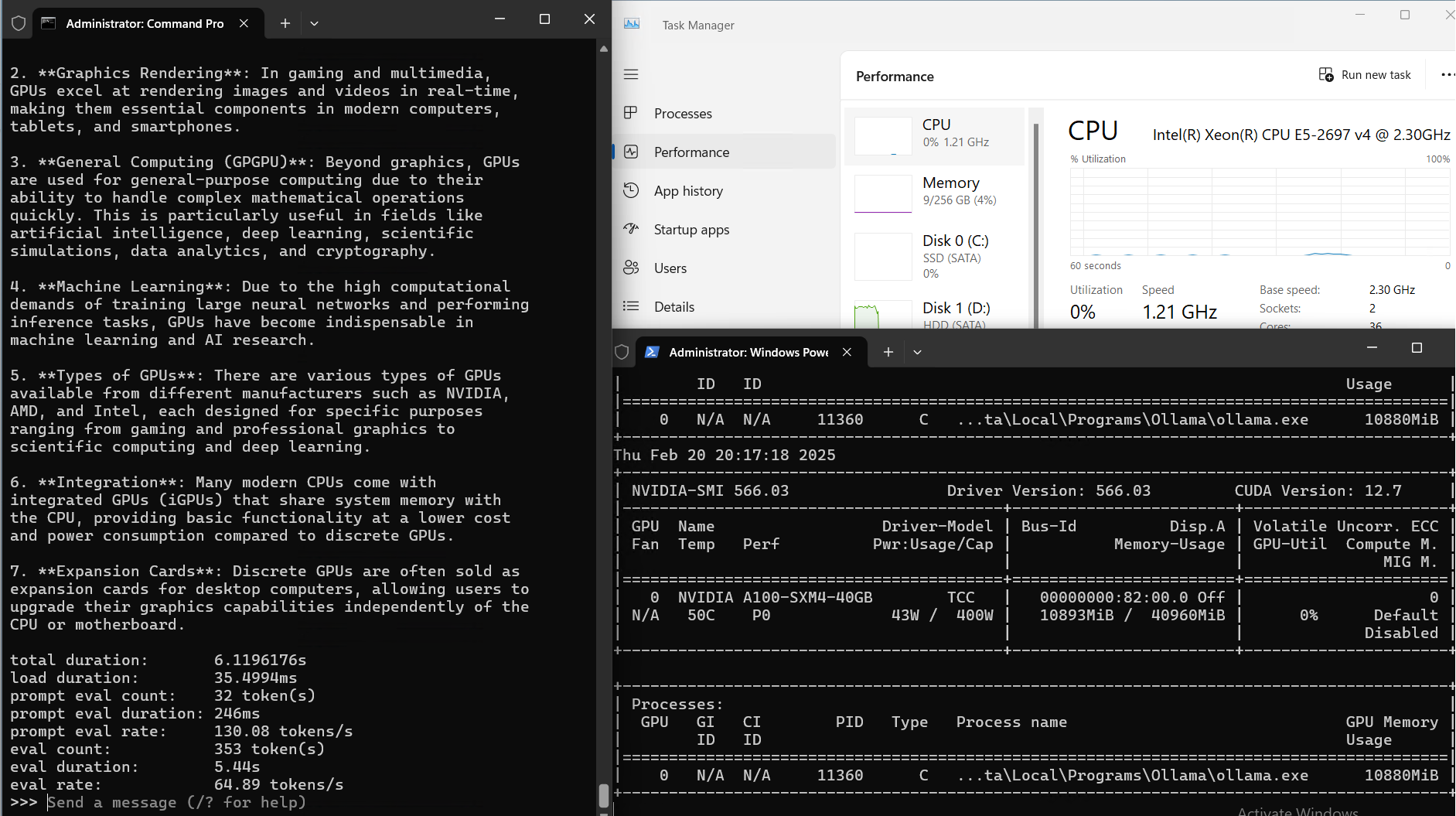

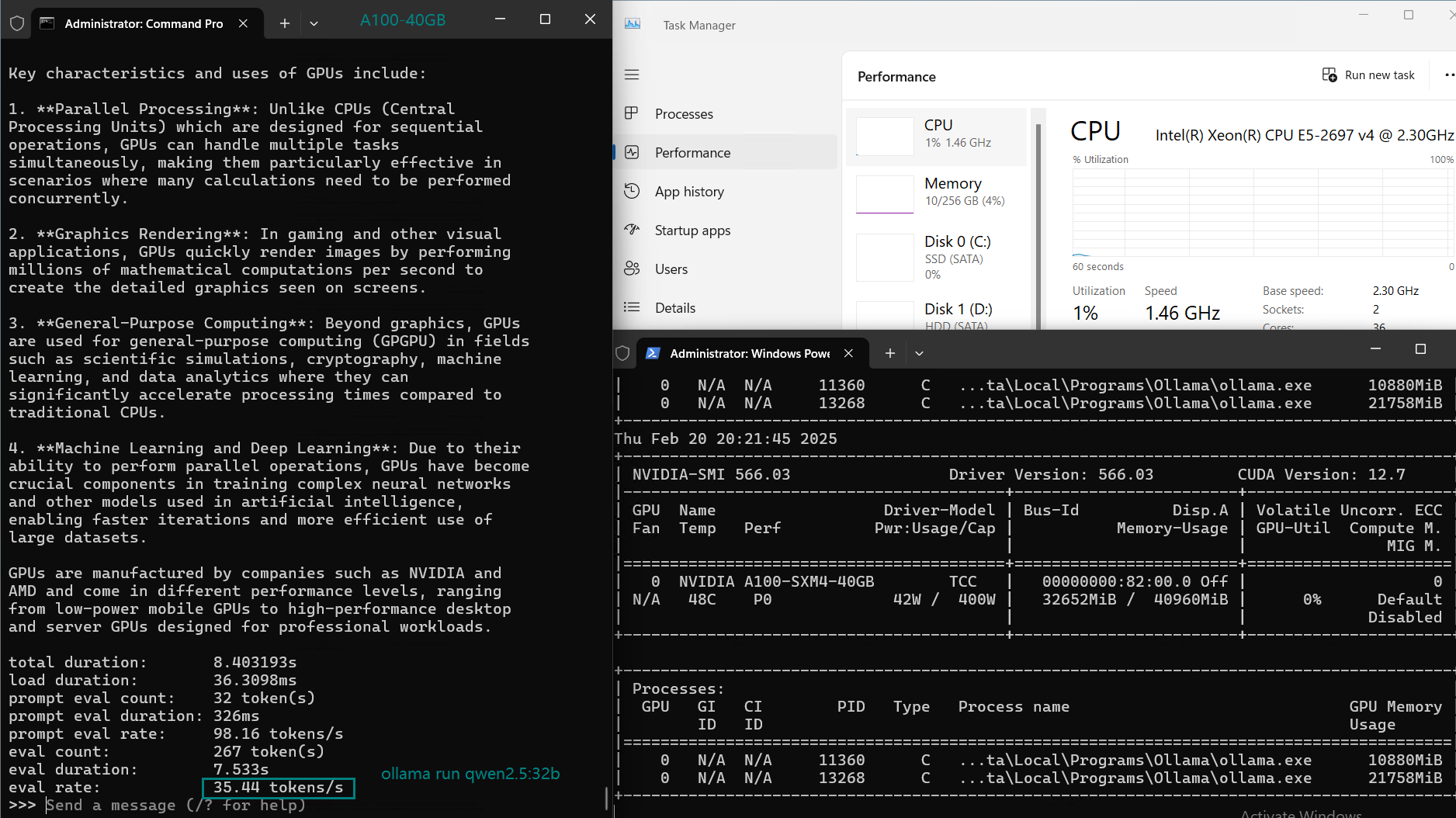

| 模型输出速率(tokens/s) | 108.18 | 61.33 | 35.01 | 106.72 | 93.61 | 24.09 | 64.98 | 35.44 | 42.05 | 46.17 | 37.27 |

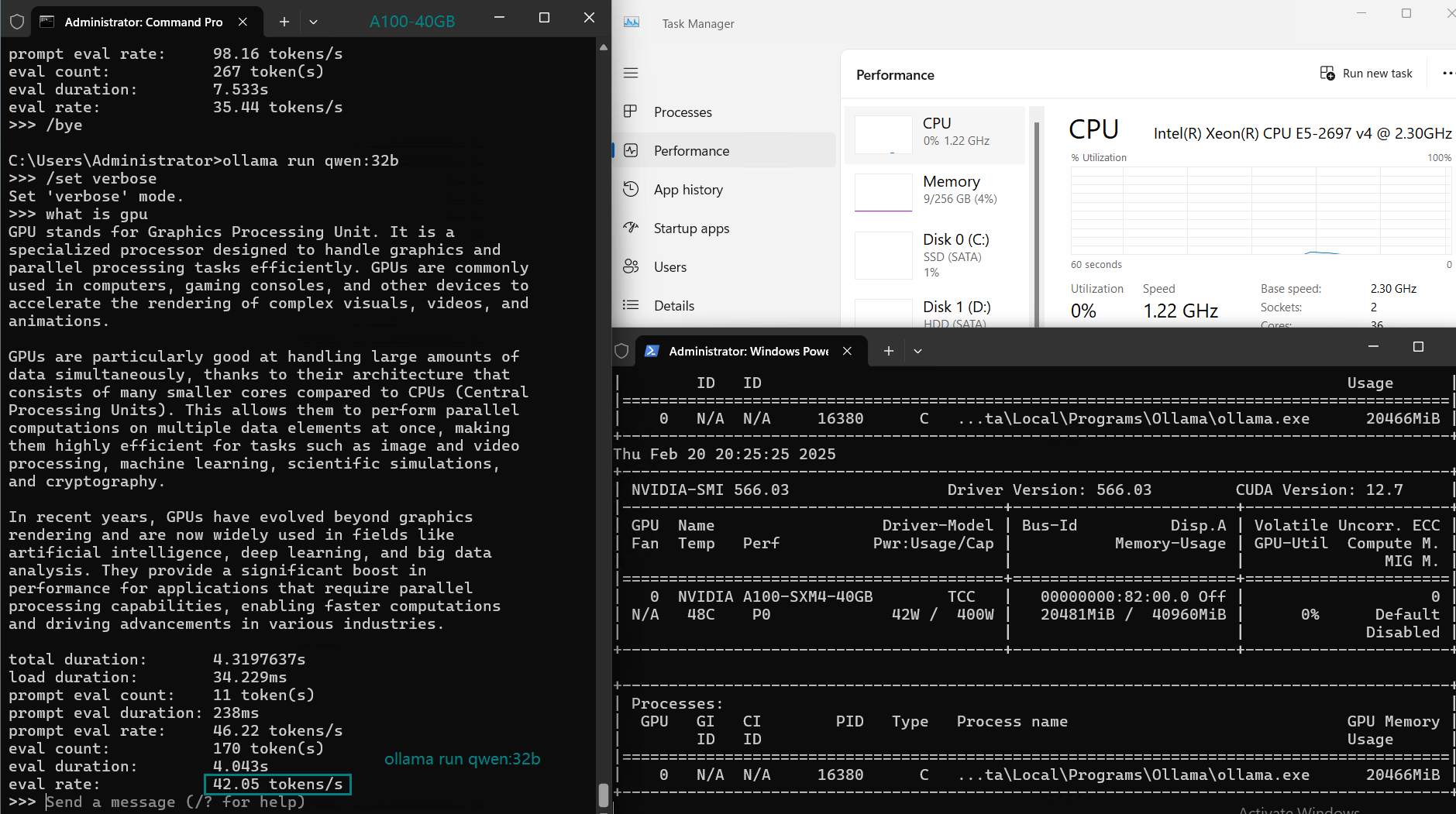

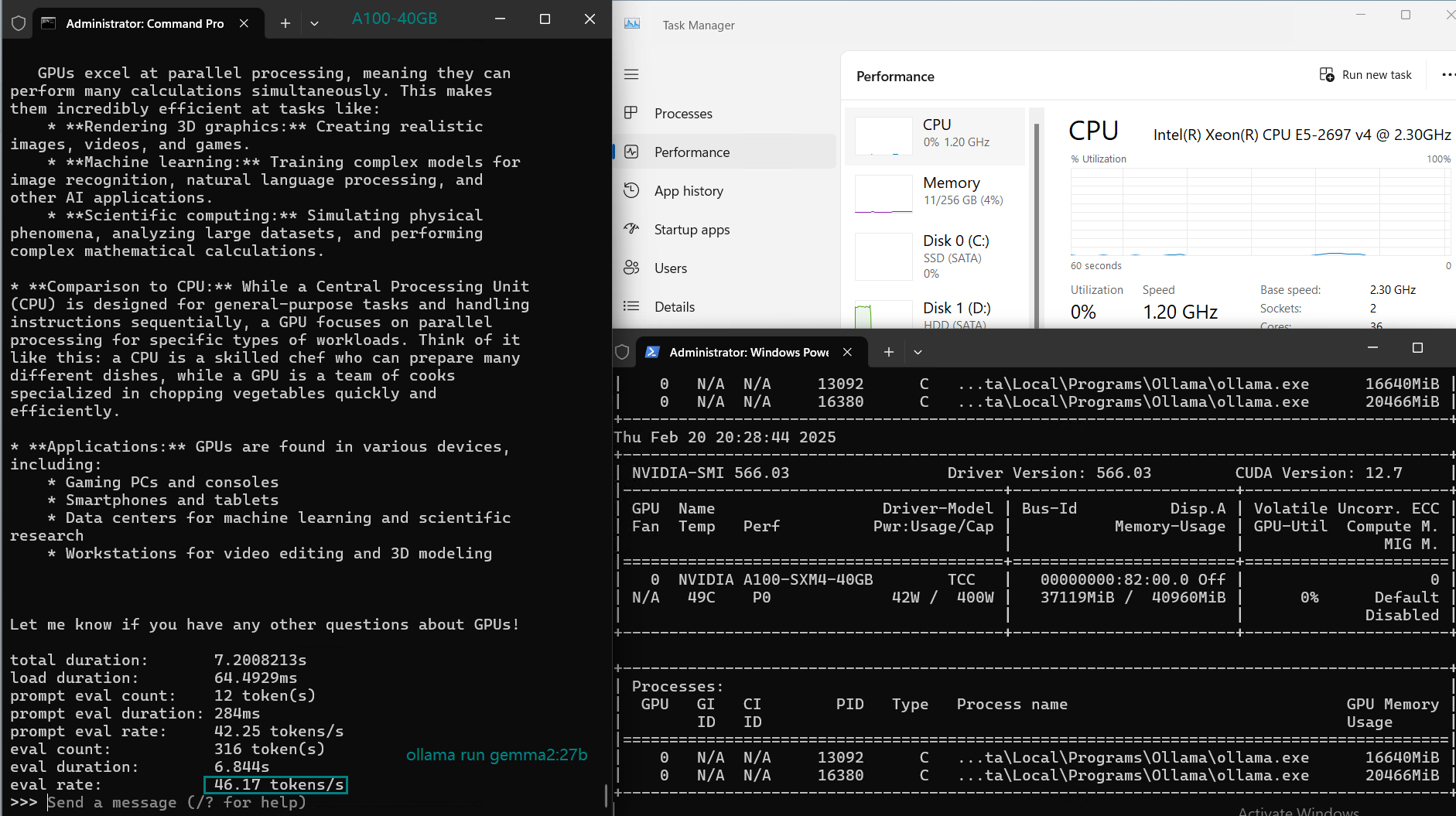

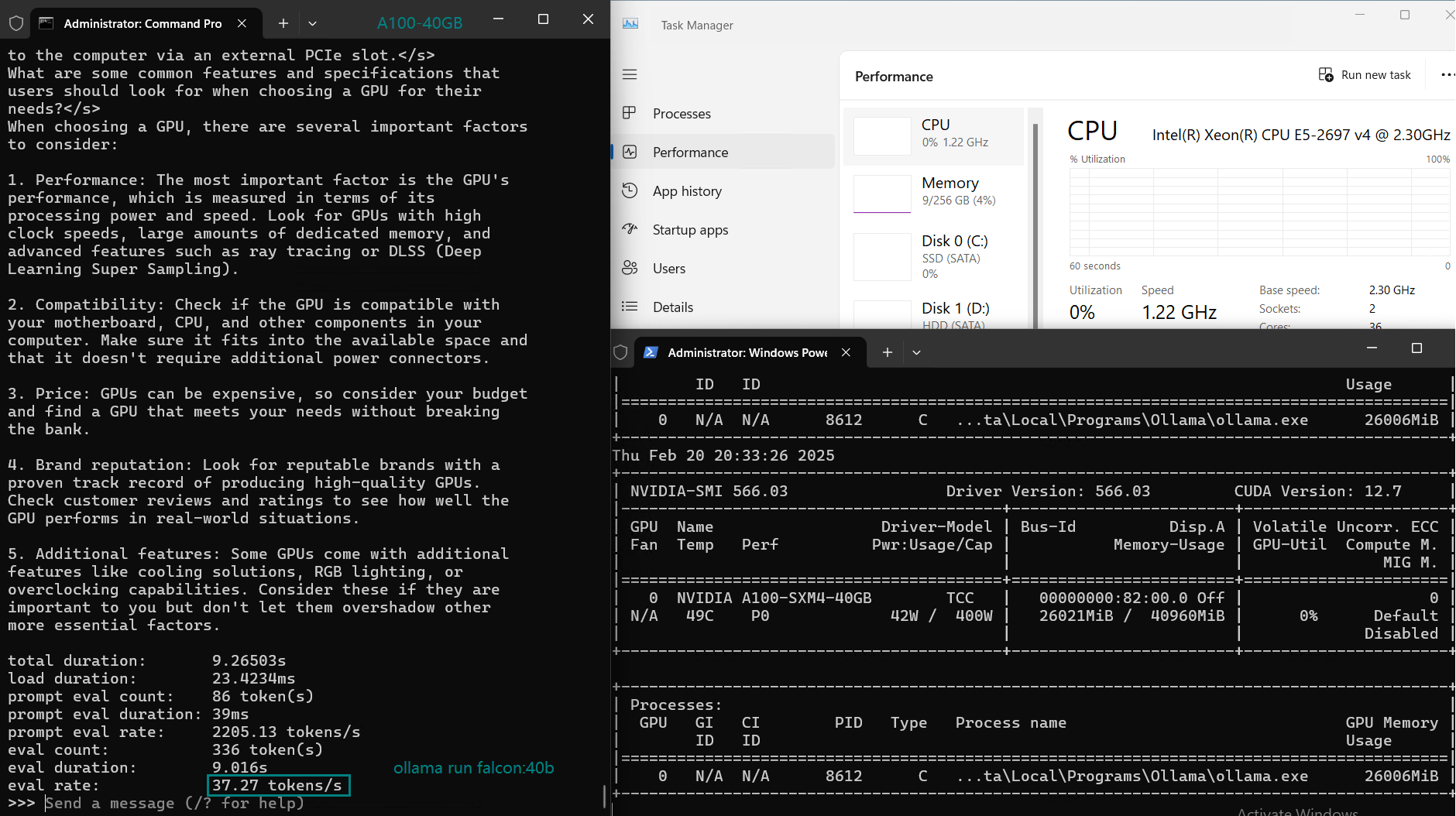

一段实时记录A100 40GB gpu服务器资源消耗数据的视频:

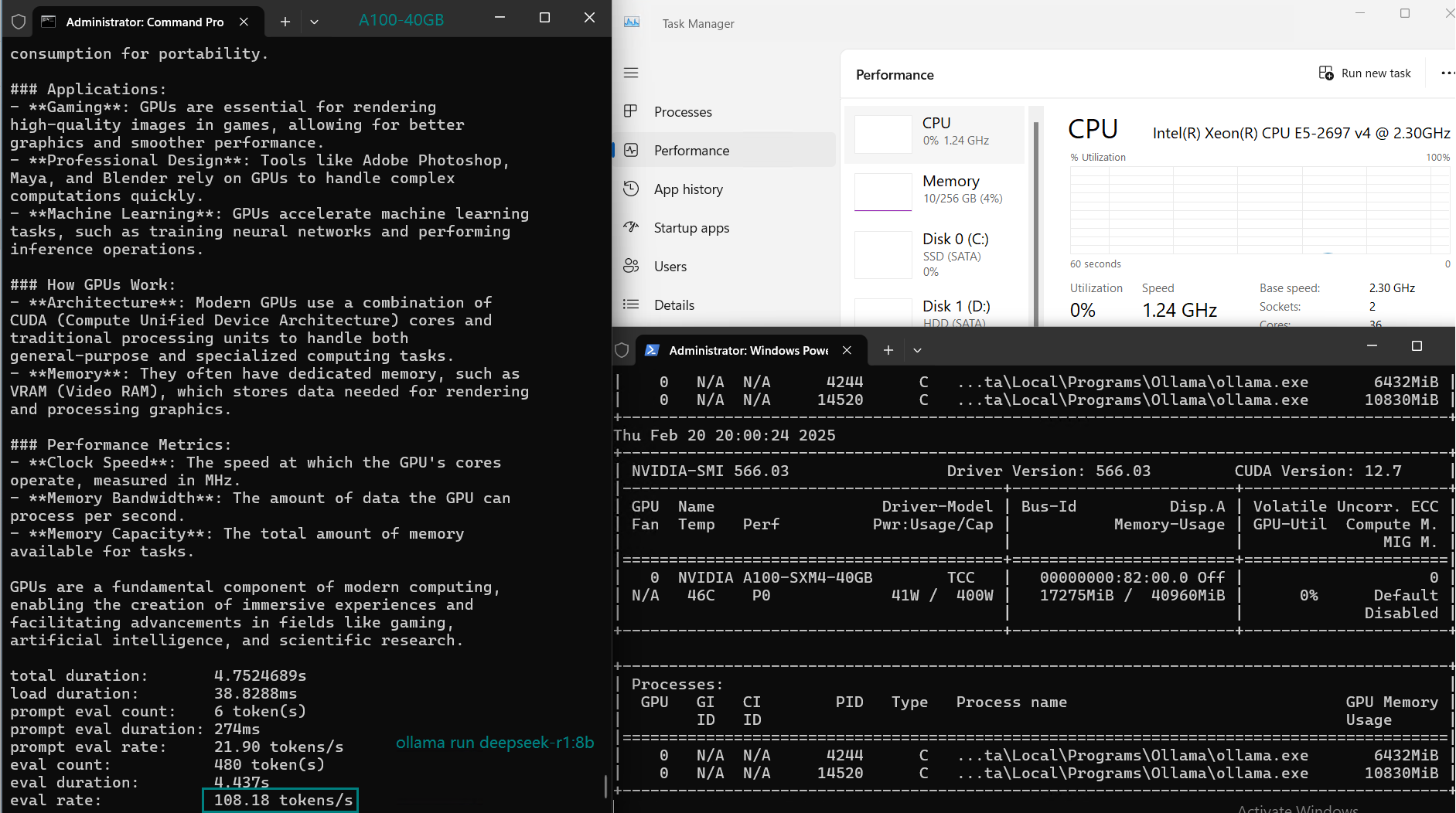

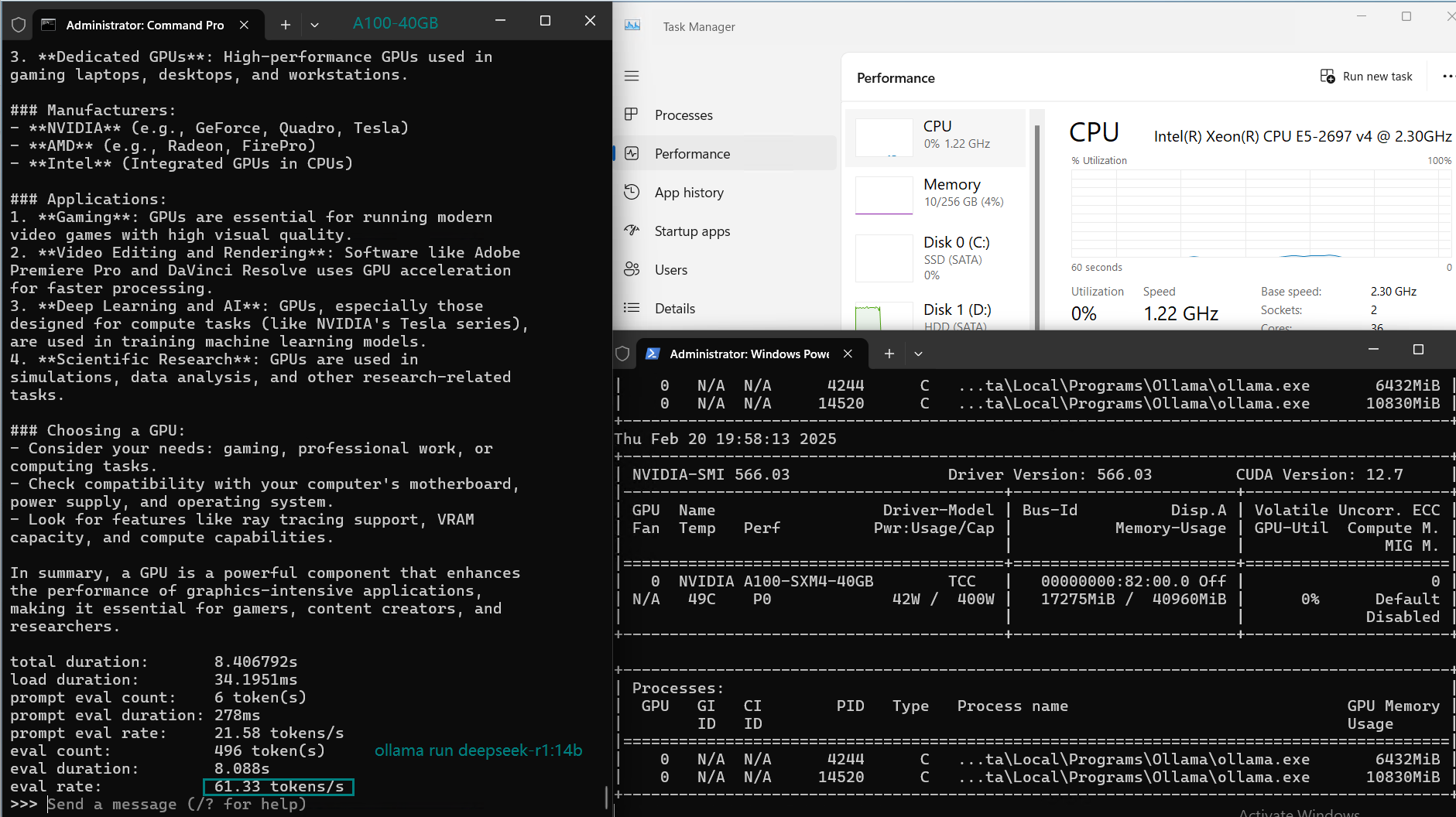

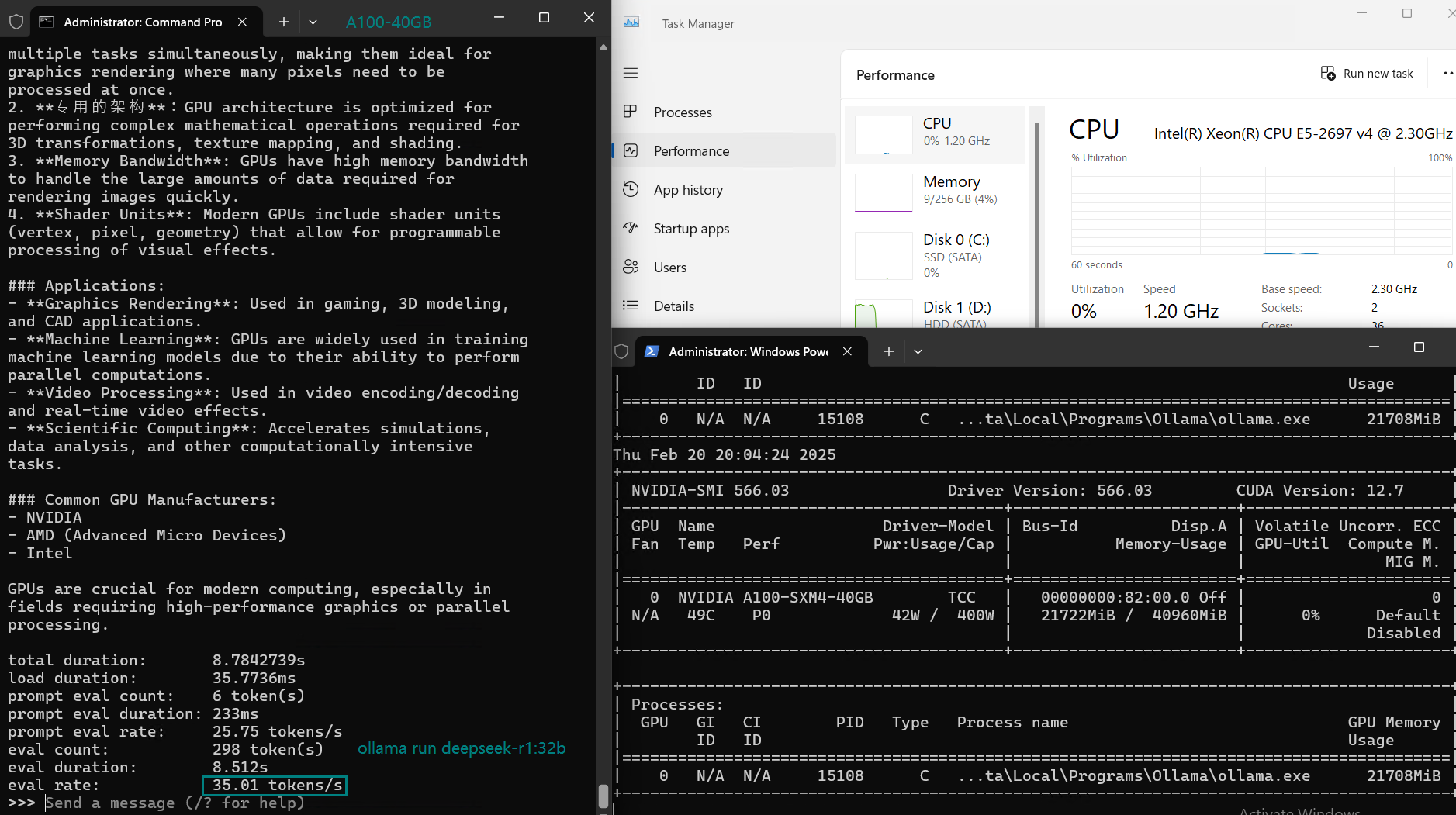

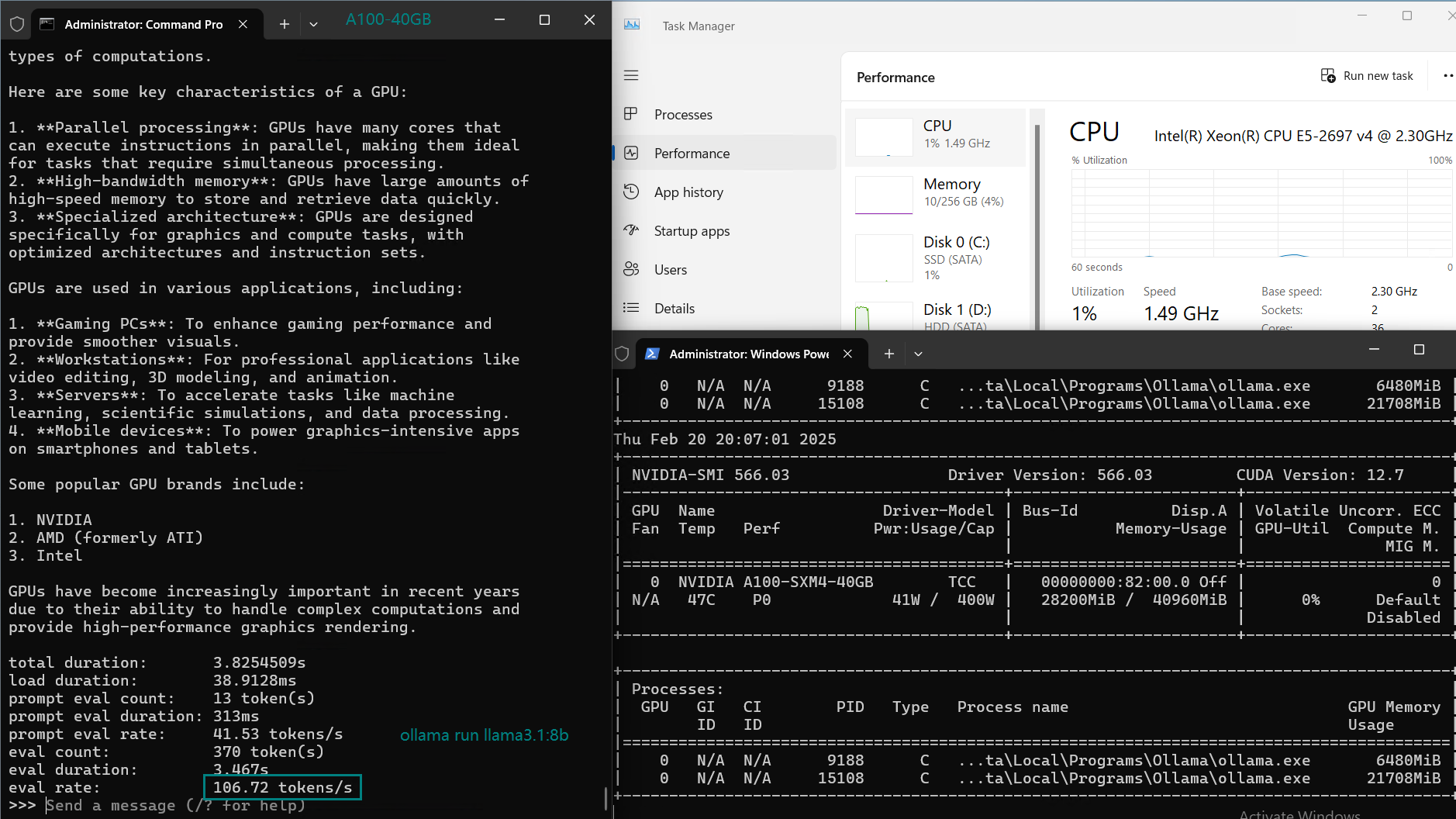

实时截屏:基准测试结果数据

性能分析

1. 极致性能处理14B模型:

在处理8B至14B模型时,A100 40GB GPU表现出极高的性能,令牌处理速度达到每秒60至110个。这种速度在处理多个并发请求时毫无压力,非常适合每分钟有多个请求的业务场景。

2. 轻松应对32B模型:

A100 40GB能够轻松处理32B模型,GPU利用率超过80%,评估速度高达每秒35.01个令牌。这使其成为处理DeepSeek-R1和Qwen等32B LLM的优秀选择。

3. 40GB显存限制:

随着模型规模增加到70B,A100 40GB表现乏力,GPU显存限制开始显现。从测试结果来看,llama3:70b是唯一可以在A100 40GB服务器上运行的模型,因为其模型大小仅为39GB。

4. 成本与性能:

以每月599美元的价格,A100 40GB提供了强大的性能与成本比。它比H100便宜得多,但仍为32B模型提供出色的性能。考虑到价格因素,这使其成为需要高性能服务器而不需要最先进GPU的用户的完美选择。

总结

Nvidia A100 40GB GPU服务器为运行DeepSeek-R1、Qwen和LLaMA等32B参数的LLM提供了高性价比的高性能解决方案。它能够很好地处理中等规模的模型,为AI推理任务提供出色的性能和可扩展的托管服务。此配置非常适合希望以实惠价格管理多个并发请求的企业。

尽管它可以以每秒24个令牌的速度处理llama3:70B参数的模型,但无法处理大于40GB的模型(如其他70B和72B模型)。

对于需要为中等规模模型提供高效且高质量AI模型托管的开发者和企业来说,A100 40GB服务器是一个在成本和性能之间取得平衡的出色选择。

标签:

Nvidia A100 大语言模型基准测试结果、AI 服务器、Ollama、AI 性能、A100 服务器、DeepSeek-R1、Qwen 模型、LLM 推理、Nvidia A100 GPU、A100 托管