服务器规格

我们在一台专用 H100 GPU 服务器 上进行了基准测试,其配置如下:

服务器配置:

- 价格:2599.0 美元/月

- CPU:双18核Intel Xeon E5-2697v4

- 内存:192GB

- 存储:240GB SSD + 2TB NVMe + 8TB SATA

- 网络:1Gbps

- 操作系统:Windows Server 2022

GPU详细信息:

- 显卡:Nvidia H100

- 微架构:Hopper

- 计算能力:9.0

- CUDA核心:14,592

- 张量核心:456

- 内存:80GB HBM2e

- FP32 性能:183 TFLOPS

该配置使其成为 深度学习、大语言模型推理和人工智能模型训练 的理想 H100 托管解决方案。

在 H100 GPU 上对 Ollama 进行基准测试

我们在 Ollama 0.5.7 上测试了多种大语言模型(LLM),包括 DeepSeek、Qwen 和 LLaMA,覆盖了不同参数规模的模型。

| 模型 | deepseek-r1 | deepseek-r1 | deepseek-r1 | qwen | qwen | qwen | qwen2 | llama3 | llama3.1 | llama3.3 | zephyr | mixtral |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 14b | 32b | 70b | 32b | 72b | 110b | 72b | 70b | 70b | 70b | 141b | 8x22b |

| 尺寸 | 9GB | 20GB | 43GB | 18GB | 41GB | 63GB | 41GB | 40GB | 43GB | 43GB | 80GB | 80GB |

| 量化 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 正在运行 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 | Ollama0.5.7 |

| 下载速度(mb/s) | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 | 113 |

| CPU 速率 | 5% | 4% | 4% | 4% | 3% | 3% | 4% | 3% | 4% | 3% | 2% | 3% |

| 内存速率 | 4% | 3% | 4% | 4% | 4% | 3% | 3% | 3% | 3% | 3% | 4% | 4% |

| GPU 执行时间 | 75% | 83% | 92% | 72% | 83% | 90% | 86% | 91 | 90% | 93% | 83% | 83% |

| 评估率(令牌/秒) | 75.02 | 45.36 | 24.94 | 48.23 | 28.17 | 20.19 | 28.28 | 26.94 | 25.20 | 24.34 | 38.62 | 38.28 |

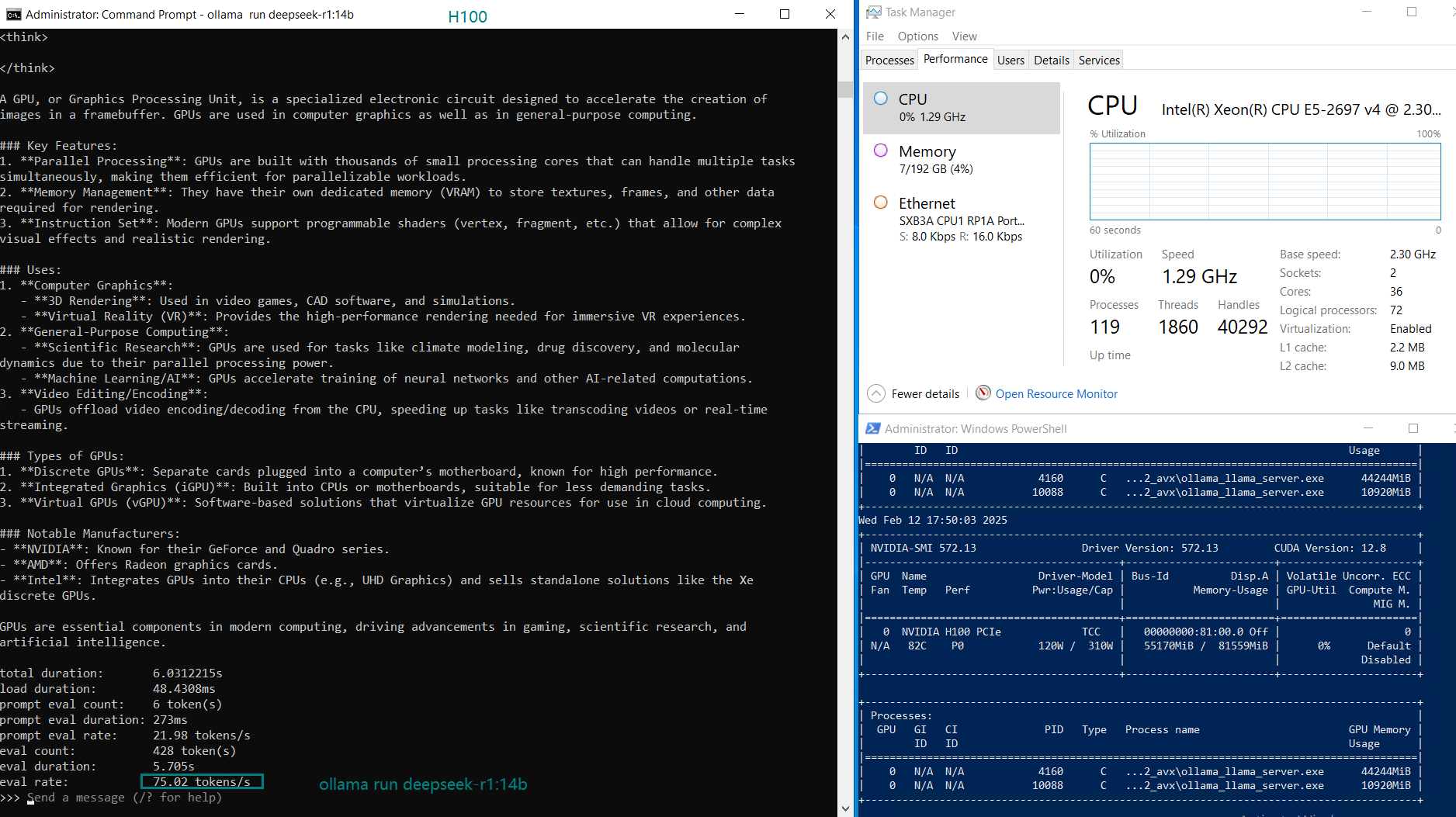

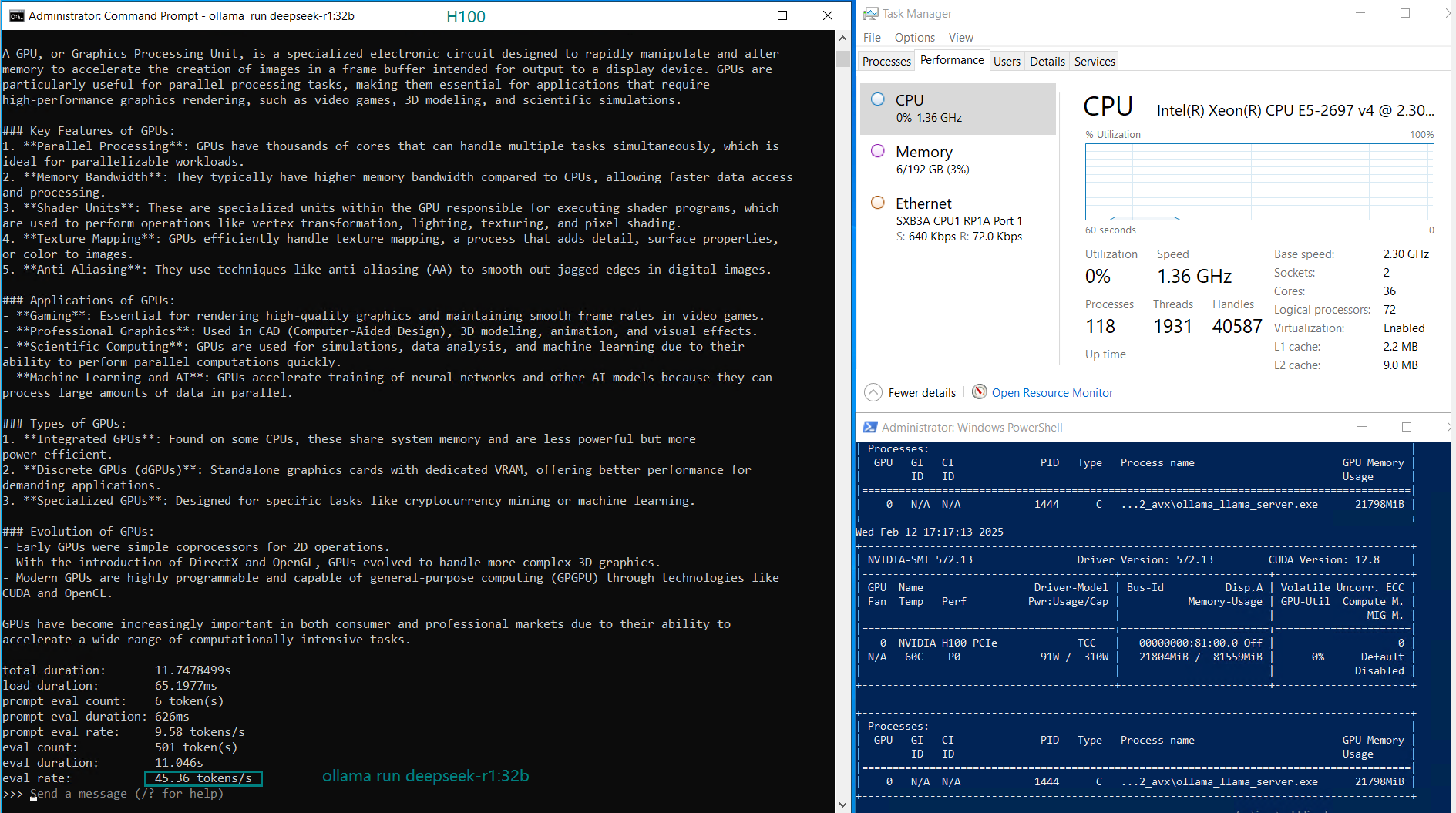

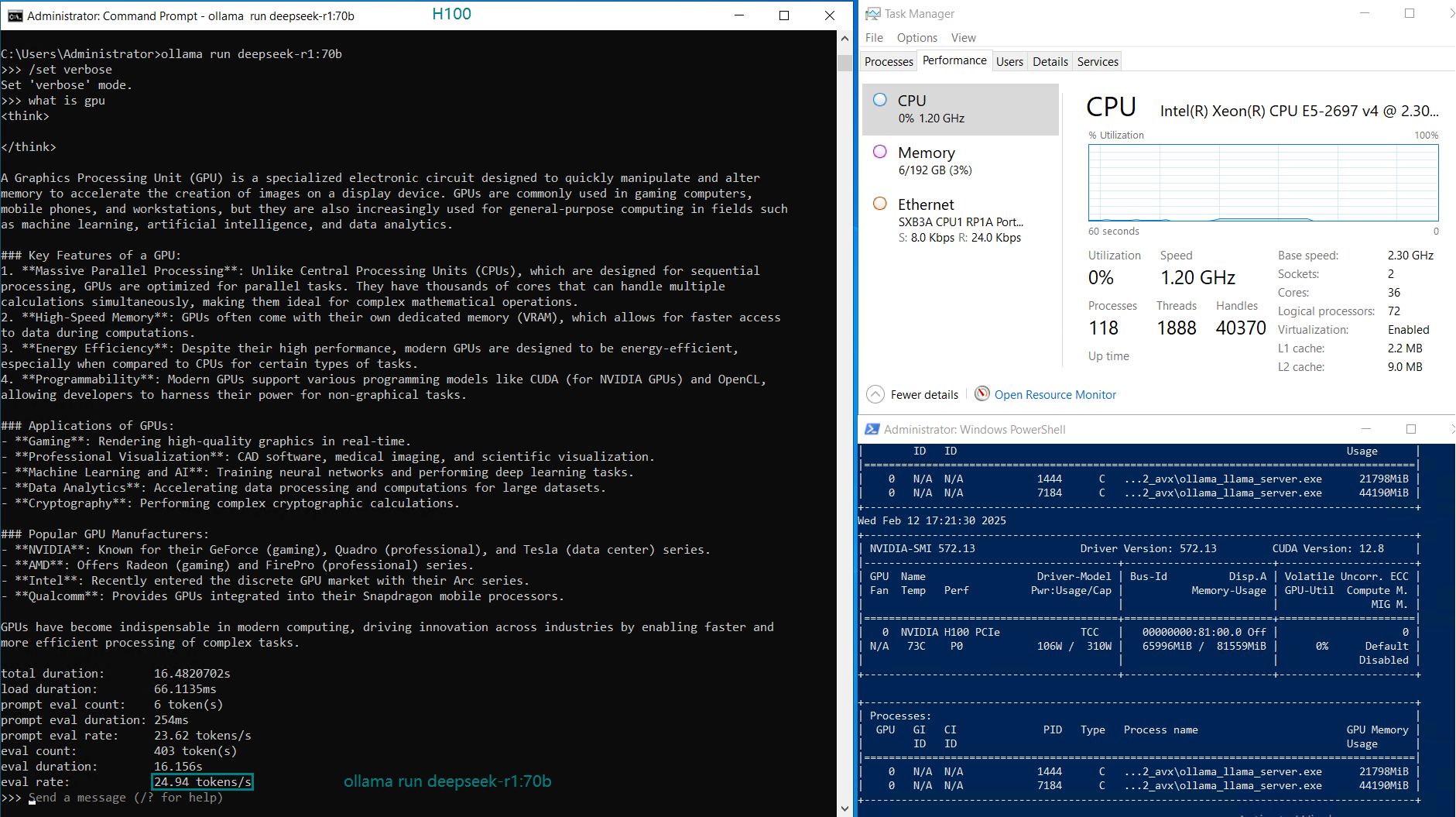

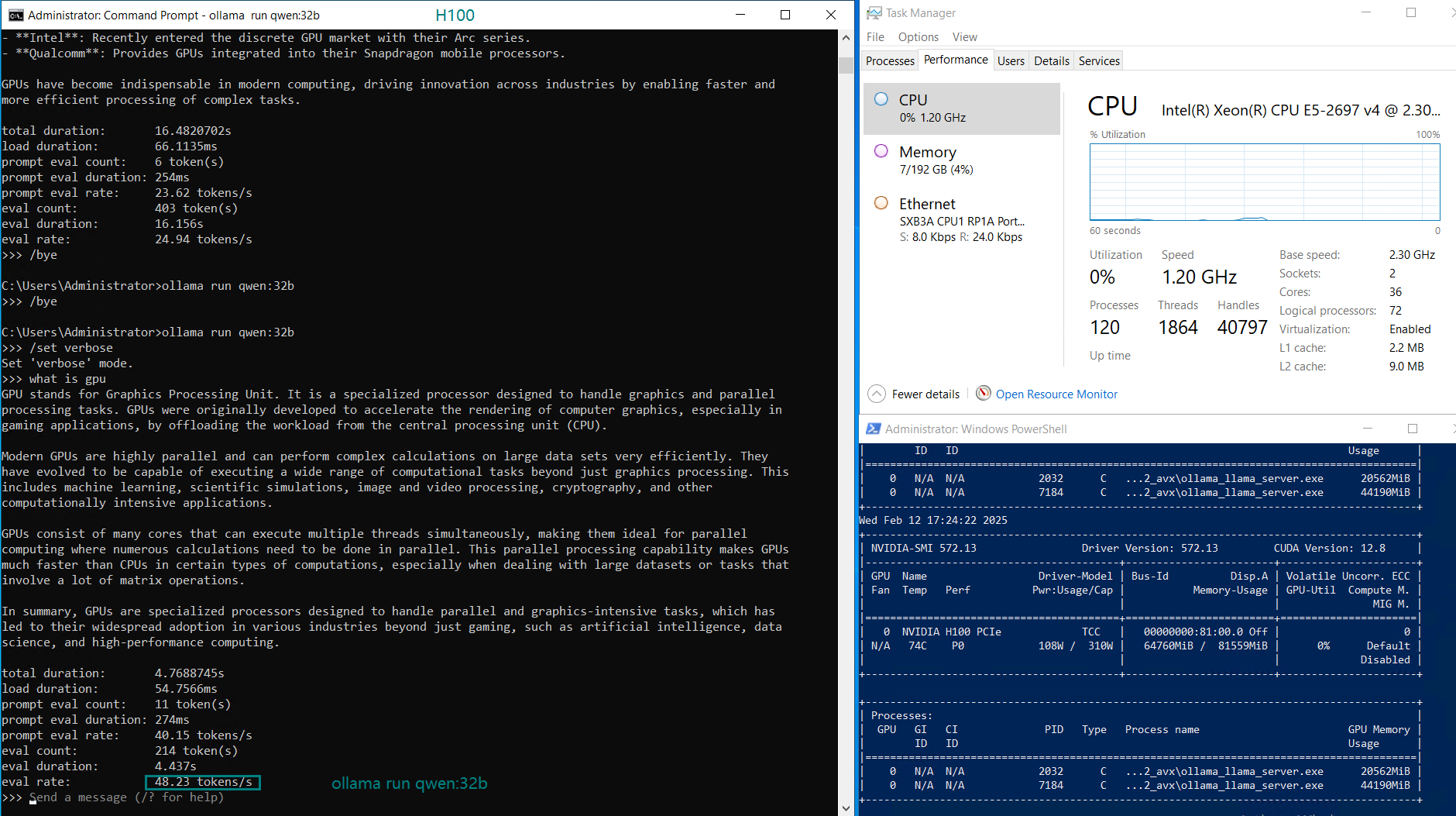

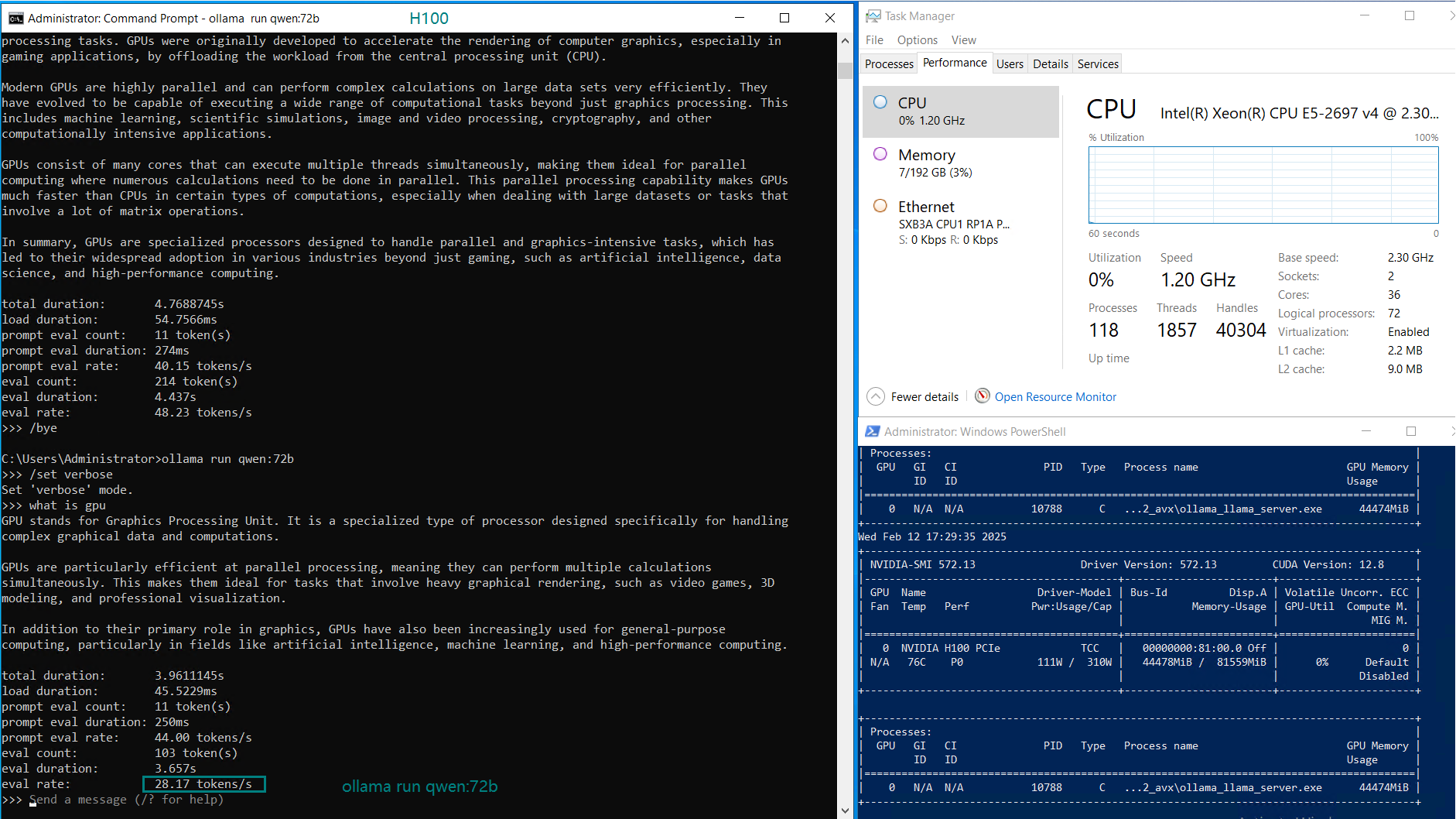

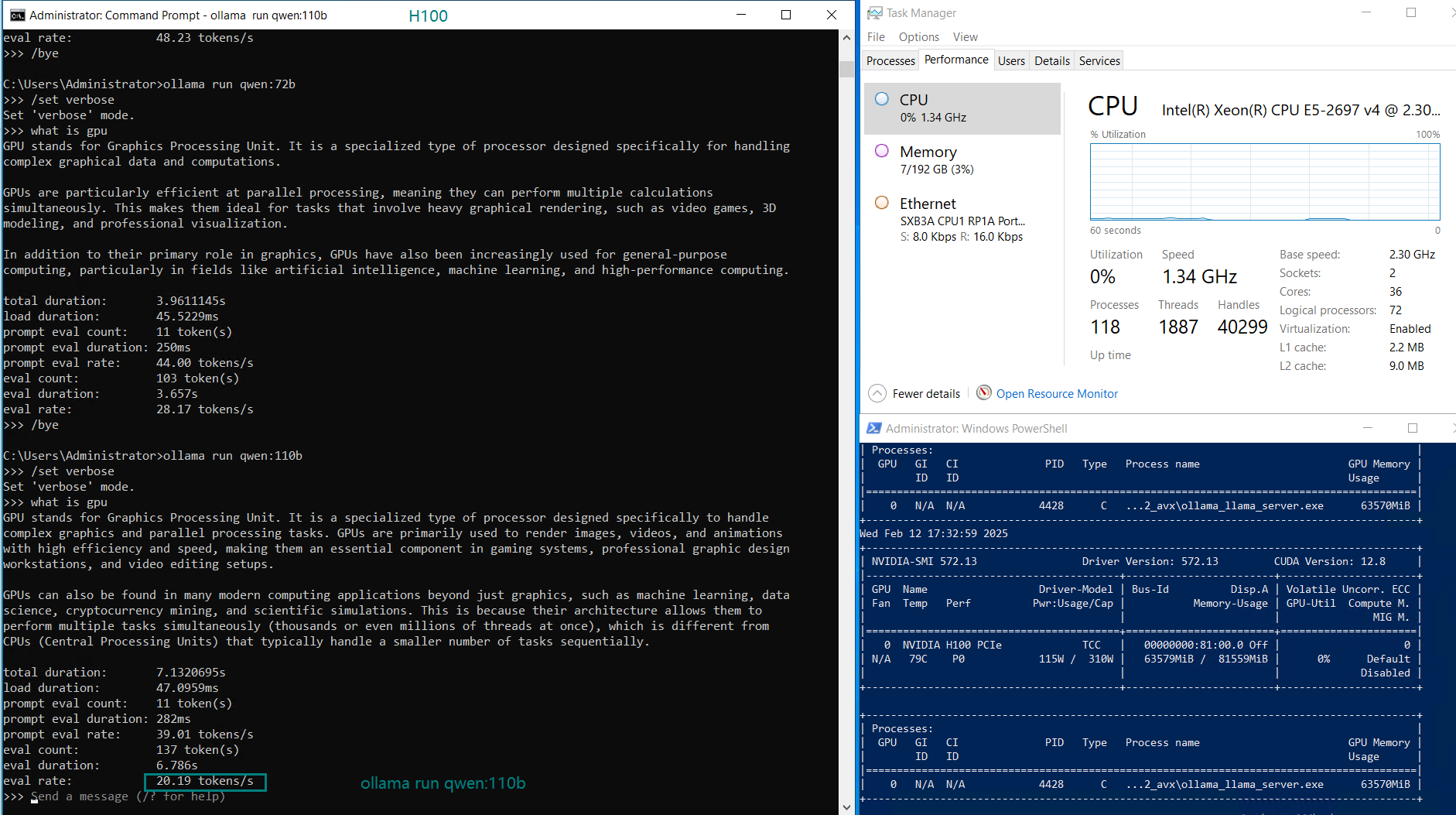

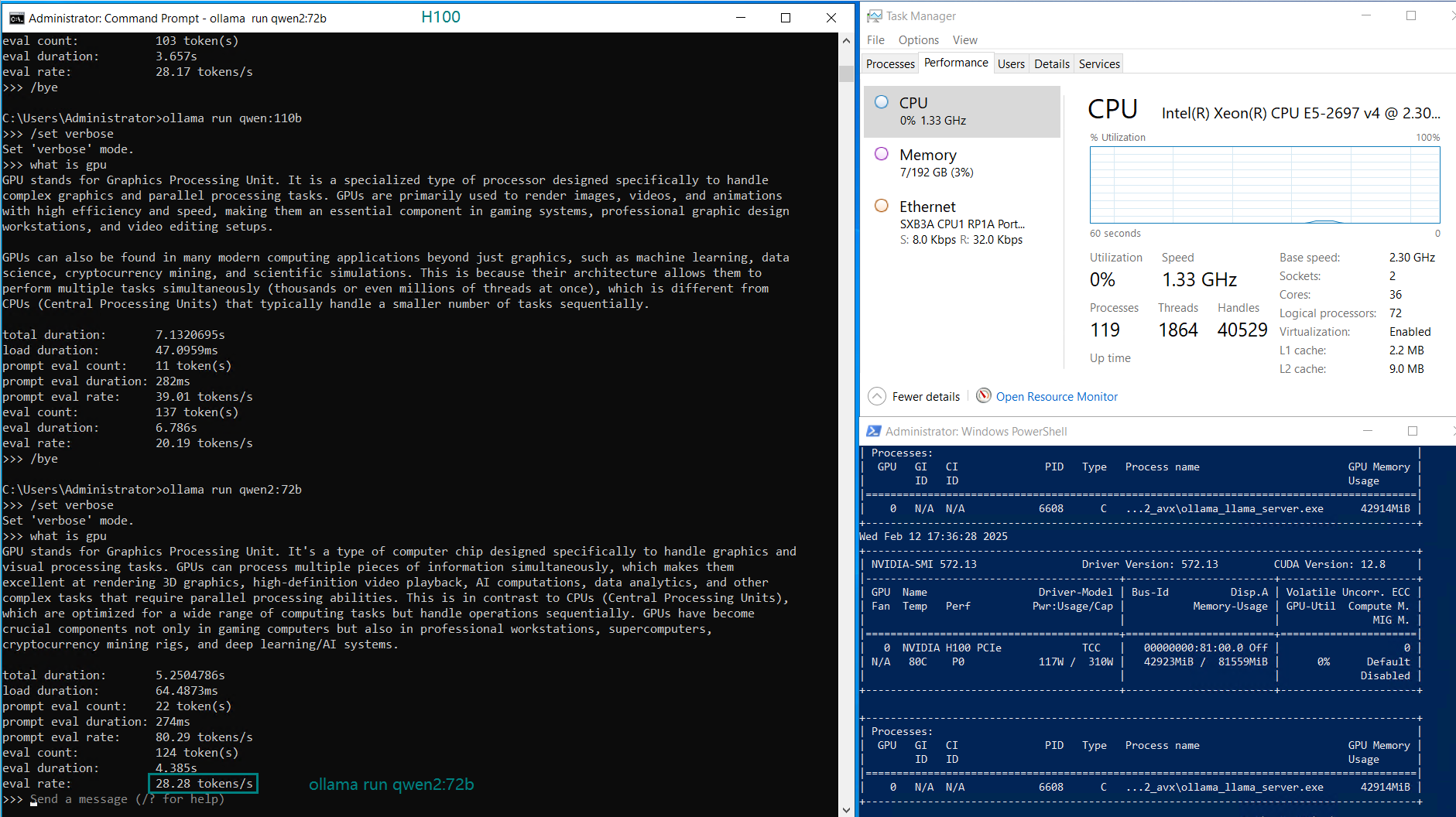

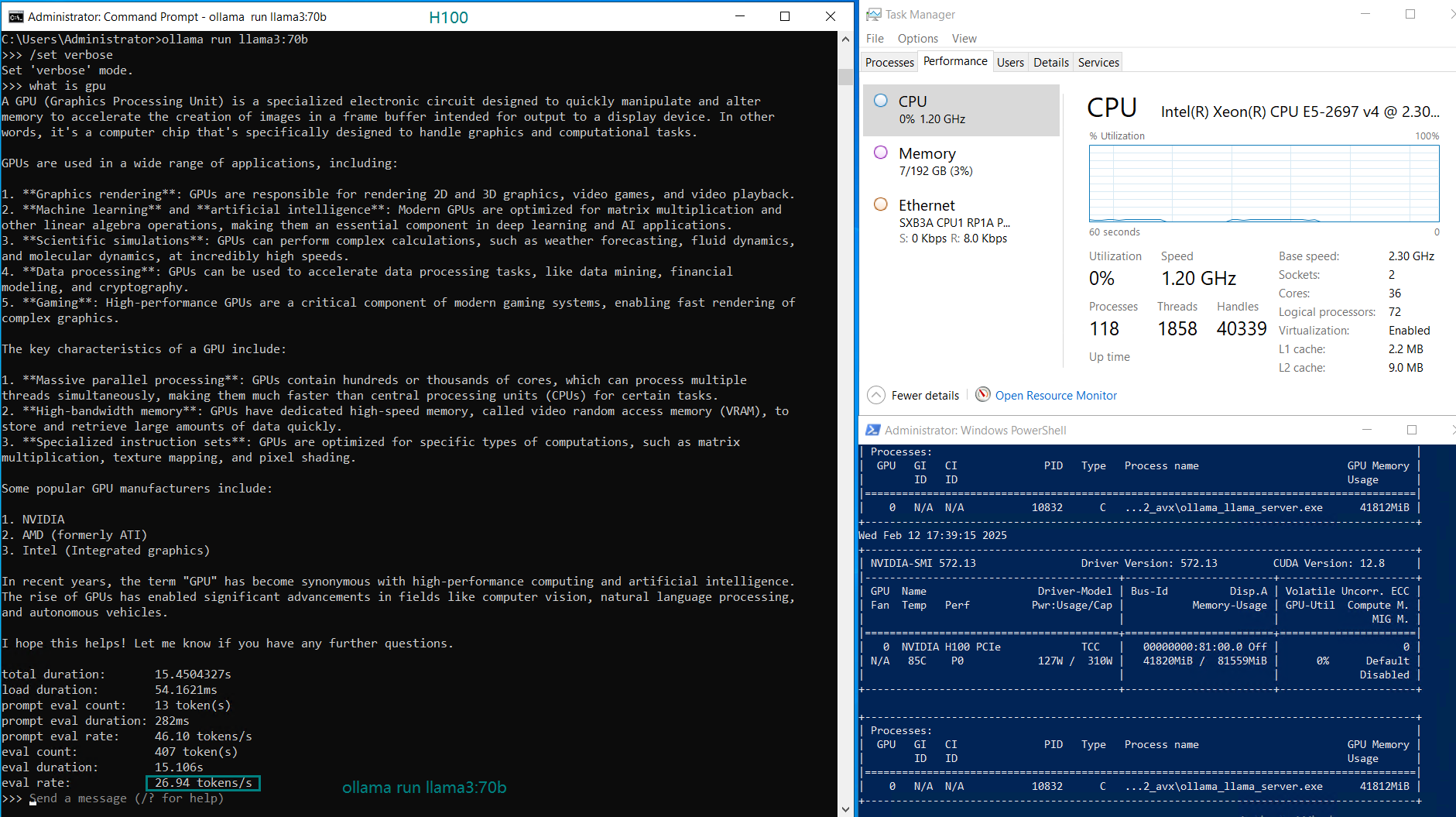

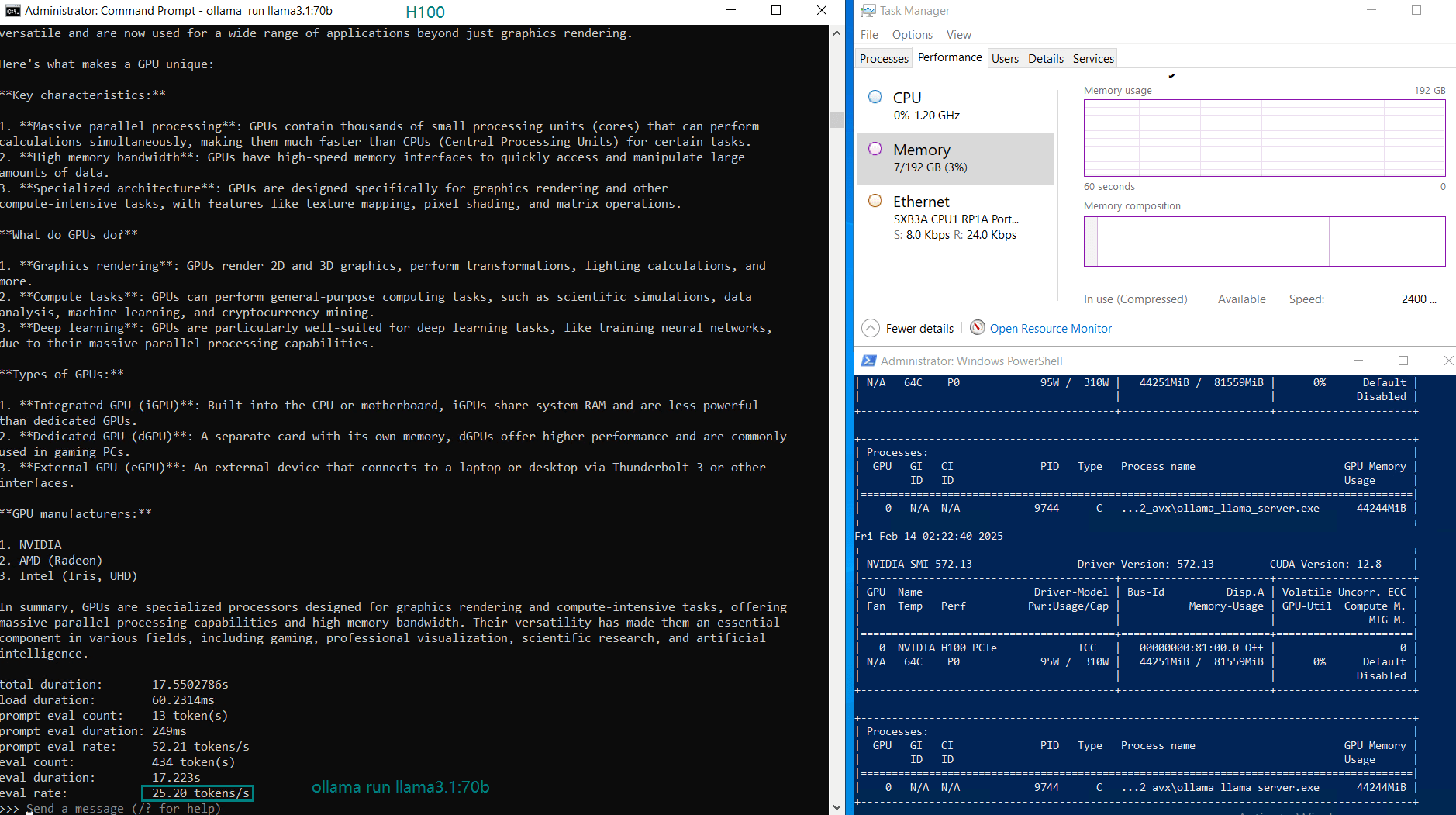

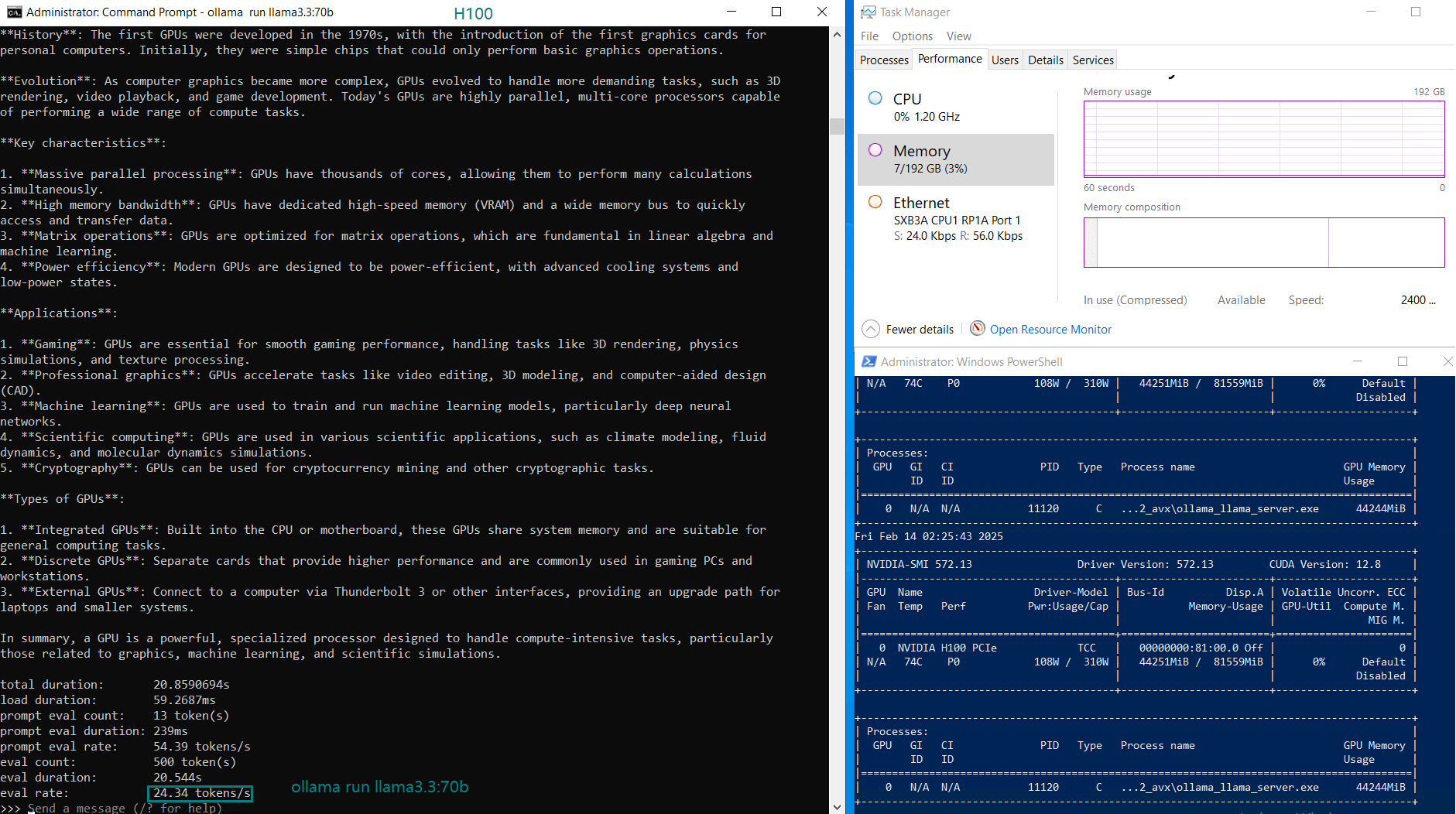

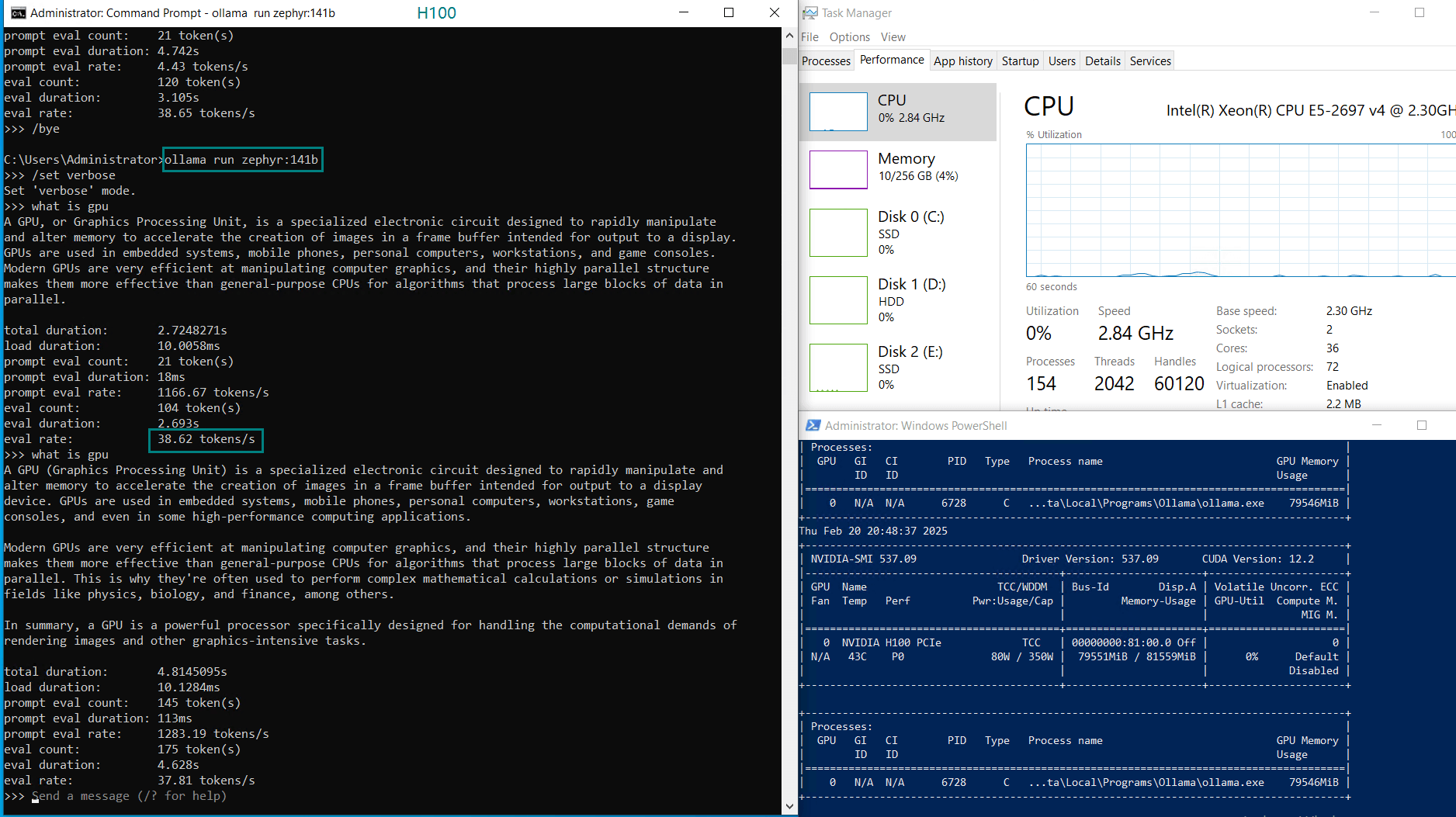

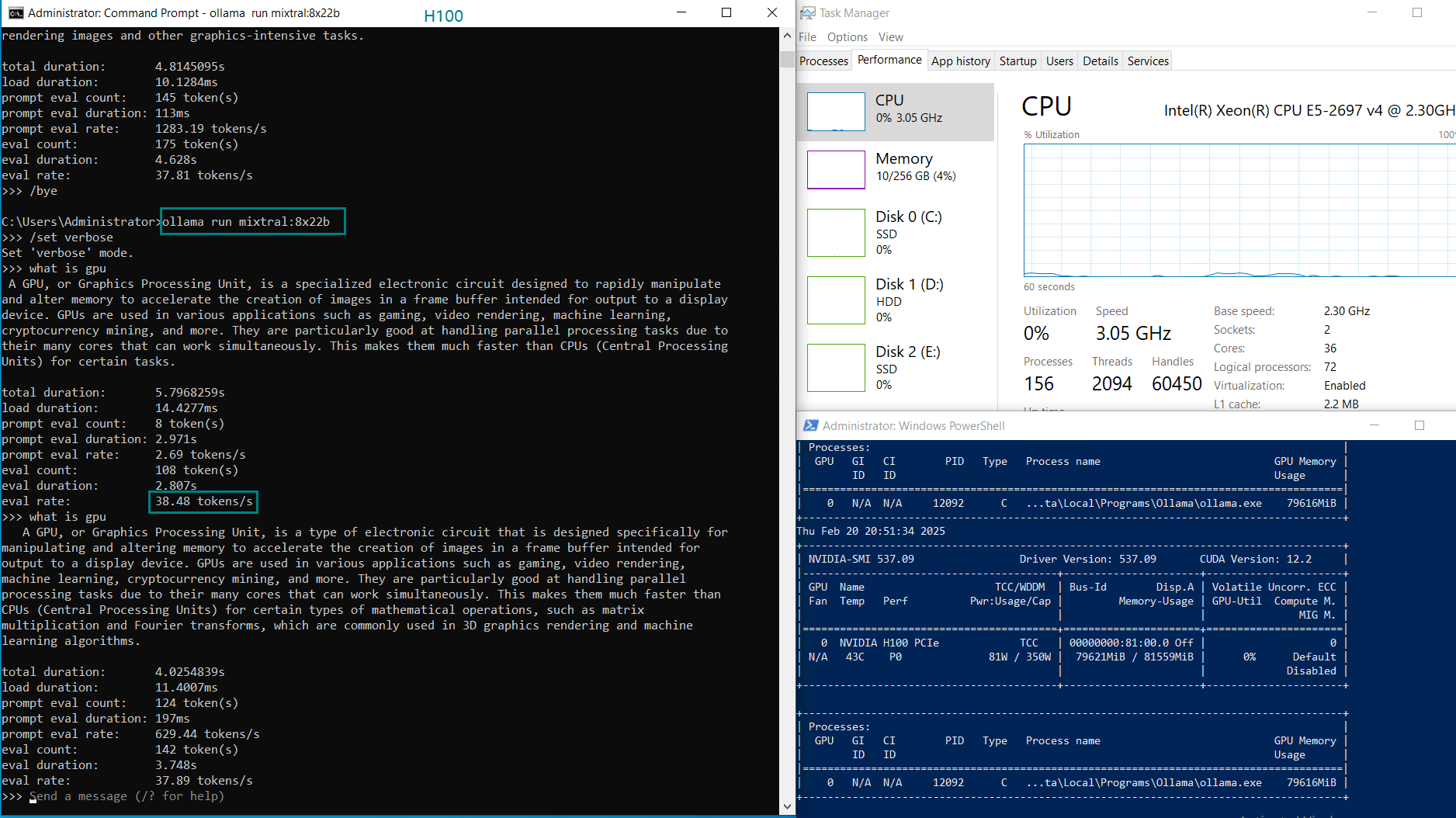

Record real-time H100 gpu server resource consumption data:

截图:点击放大查看

分析与见解

1. CPU利用率

在所有模型测试中,CPU 使用率均保持在 5% 以下,这表明 H100 几乎将所有计算任务都卸载到了 GPU 上。

2. RAM利用率

内存使用率保持在 3-4% 左右,这进一步确认大部分计算处理都发生在 H100 GPU 的 HBM2e 显存 上。

3. Ollama 在 H100 上的表现

- DeepSeek 14B 模型 的 令牌吞吐量最高,为 75.02 tokens/s,使其在低端大语言模型应用中效率最高。

- 像 Qwen 110B 和 LLaMA 3.3 70B 这样的大型模型,GPU 利用率提升至 90-100%,同时评估速度相应下降至约 20 tokens/s。

- H100 GPU 即使在高负载情况下,也能高效处理 70B+ 规模的模型,因此非常适合用于 大语言模型托管和人工智能推理。

H100 与 A100 在大语言模型(LLM)中的对比

- 得益于更高的 FLOPS 和更先进的 张量核心,H100 在 Ollama 基准测试和大语言模型推理中显著优于 A100。

- 如果您需要运行 70B~110B 规模的模型,H100 是更优的选择,尤其适用于 实时应用场景。

| 指标 | Nvidia H100 | Nvidia A100 80GB |

|---|---|---|

| 架构 | Hopper 架构 | Ampere 架构 |

| CUDA 核心 | 14,592 | 6,912 |

| 张量核心 | 456 | 432 |

| 内存 | 配备 80GB HBM2e 高带宽显存 | 配备 80GB HBM2 高带宽显存 |

| FP32 TFLOPS | 183 | 19.5 |

| LLM 表现 | 快 2 倍 | 基线 |

H100 GPU 大语言模型托管

我们的专用 H100 GPU 服务器 针对大语言模型推理、微调以及深度学习工作负载进行了优化。配备 80GB HBM2e 显存,可高效处理 高达 110B 参数的模型。

新年特惠

GPU物理服务器 - A6000

¥ 1924.50/月

立省50% (原价¥3849.00)

月付季付年付两年付

立即订购- CPU: 36核E5-2697v4*2

- 内存: 256GB DDR4

- 系统盘: 240GB SSD

- 数据盘: 2TB NVMe + 8TB SATA

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia RTX A6000

- 显存: 48GB GDDR6

- CUDA核心: 10752

- 单精度浮点: 38.71 TFLOPS

总结与建议

英伟达 H100 GPU 在大语言模型推理和人工智能工作负载中表现出卓越的性能。在 H100 服务器上运行 Ollama 可以让用户高效处理大规模 AI 模型,同时实现高吞吐量和低延迟

对于需要 大语言模型托管、H100 GPU 托管 或 高性能 AI 计算 的用户,我们的专用 H100 GPU 服务器 是最佳选择。

Tags:

Nvidia H100, GPU 服务器, 大语言模型推理, Ollama 人工智能推理, 大型模型, 深度学习, GPU 云计算, H100 与 A100 对比, 人工智能托管