测试服务器配置

在深入了解 Ollama RTX 2060 基准测试之前,我们先来看看这台服务器的配置:

服务器配置:

- 价格: ¥1393/月

- CPU:Intel 双路 10 核 E5-2660 v2

- 内存: 128GB

- 存储: 120GB + 960GB SSD

- 网络: 100Mbps Unmetered

- 操作系统: Windows 11 Pro

GPU 详情:

- GPU: Nvidia GeForce RTX 2060

- 计算能力 7.5

- 微架构: Ampere

- CUDA 核心数: 1920

- Tensor 核心数: 240

- 显存: 6GB GDDR6

- FP32 性能: 5.0 TFLOPS

该配置使我们能够在 RTX2060 上探索小规模 LLM 推理,但由于显存限制为 6GB,重点放在参数量不超过 30 亿的模型上。

基准测试结果:在 Nvidia RTX2060 上运行 Ollama

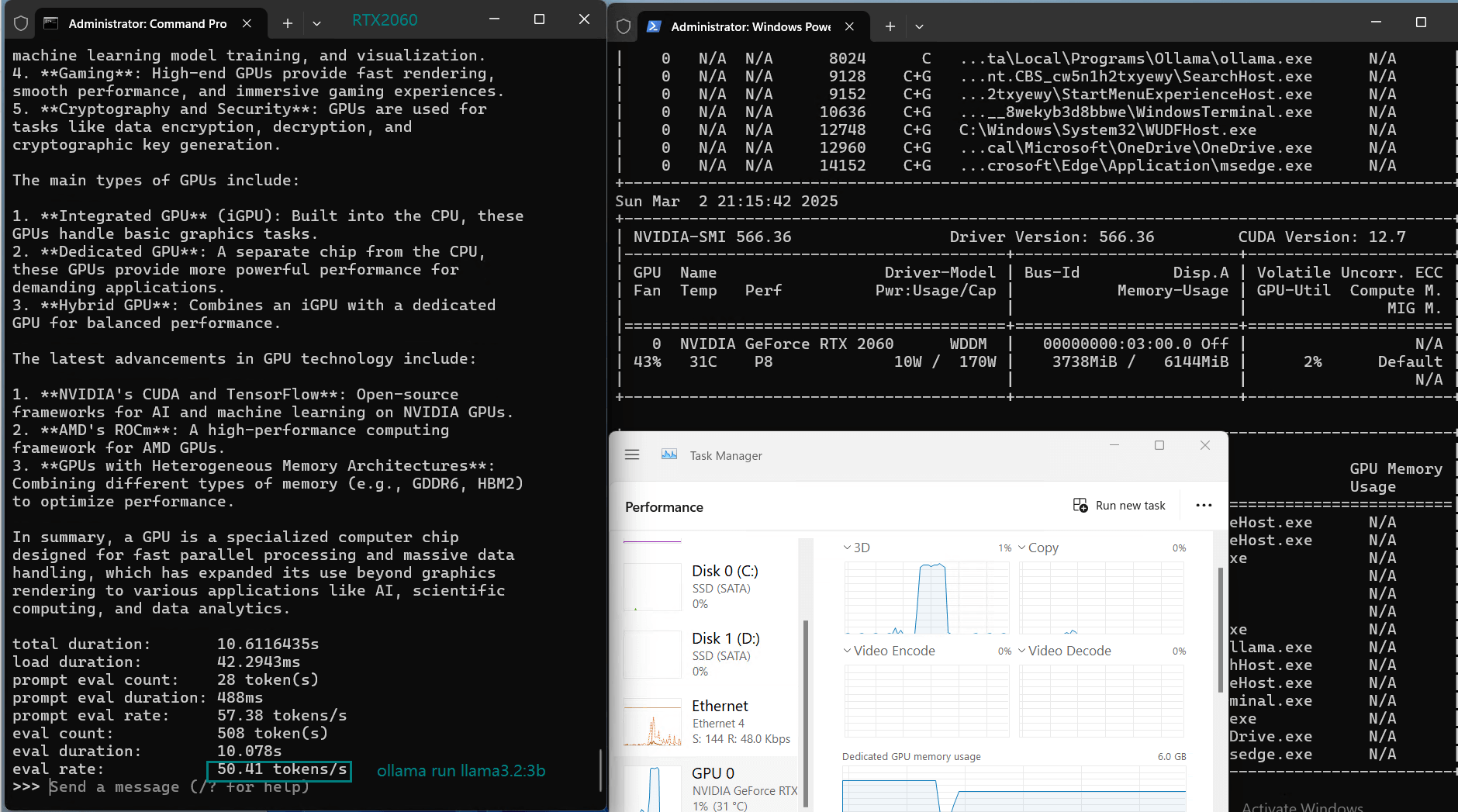

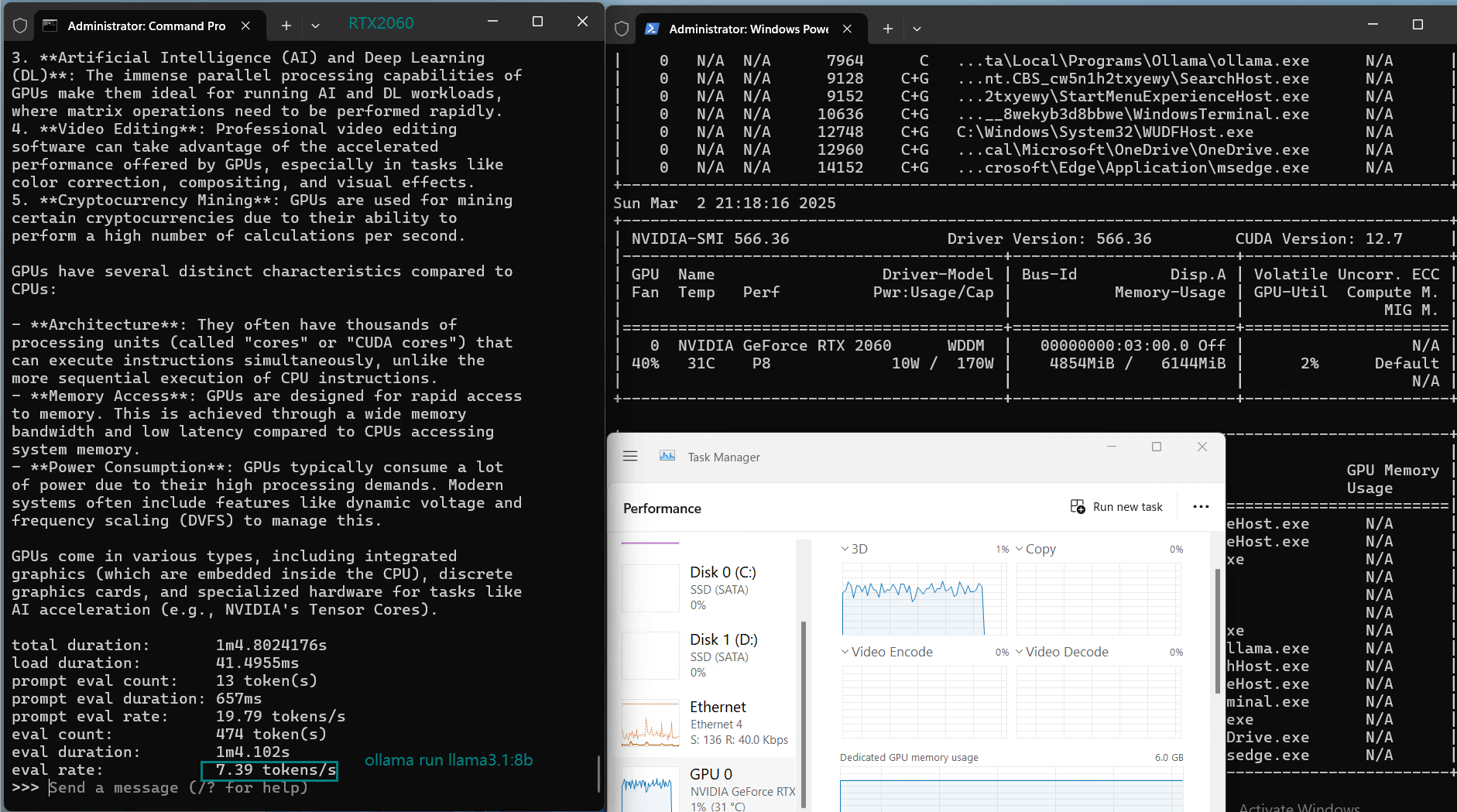

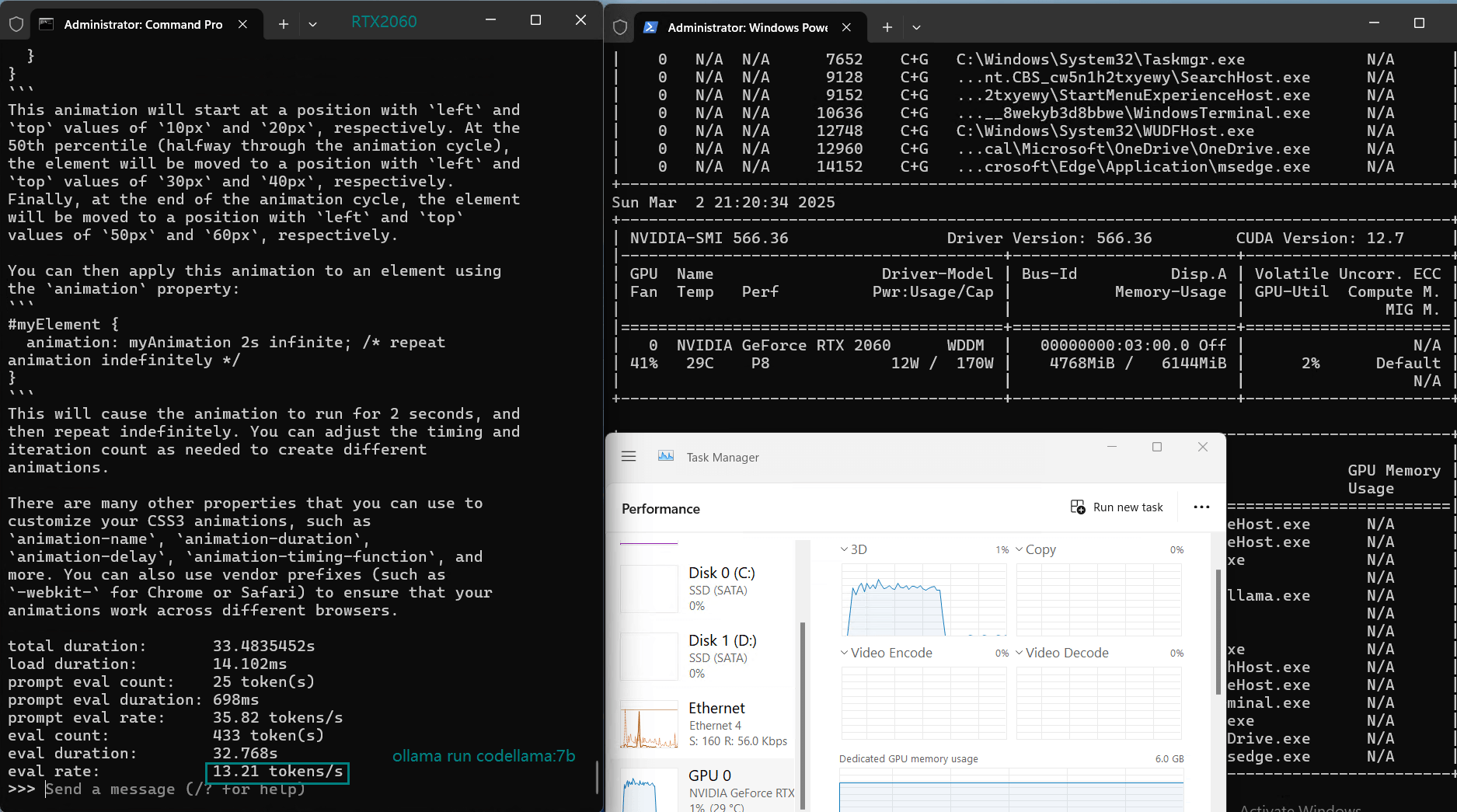

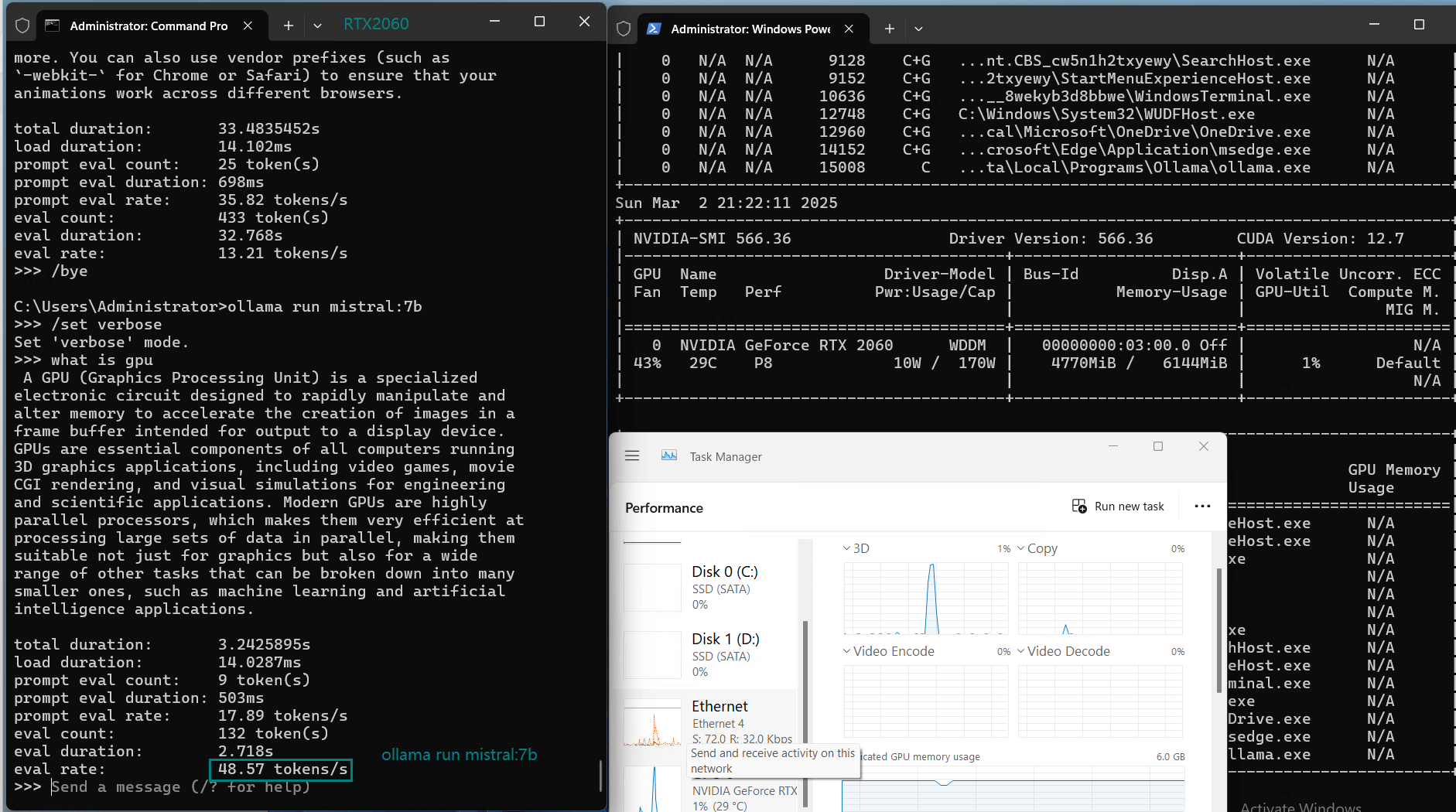

在测试中,我们使用 Ollama 0.5.11 对多种 LLM 在 Nvidia RTX 2060 GPU 上进行了基准测试。结果为该显卡在处理小型语言模型时的性能提供了宝贵参考。

| 模型 | deepseek-r1 | deepseek-r1 | deepseek-r1 | deepseek-coder | llama3.2 | llama3.1 | codellama | mistral | gemma | codegemma | qwen2.5 | qwen2.5 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 1.5b | 7b | 8b | 6.7b | 3b | 8b | 7b | 7b | 7b | 7b | 3b | 7b |

| 大小(GB) | 1.1 | 4.7 | 4.9 | 3.8 | 2.0 | 4.9 | 3.8 | 4.1 | 5.0 | 5.0 | 1.9 | 4.7 |

| 量化 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 运行于 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 |

| 下载速度(兆字节/秒) | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 |

| CPU 使用率 | 7% | 46% | 46% | 42% | 7% | 51% | 41% | 7% | 51% | 53% | 7% | 45% |

| 内存使用率 | 5% | 6% | 6% | 5% | 5% | 6% | 5% | 5% | 7% | 7% | 5% | 6% |

| GPU 利用率 | 39% | 35% | 32% | 35% | 56% | 31% | 35% | 21% | 12% | 11% | 43% | 36% |

| 评估速度(tokens/秒) | 43.12 | 8.84 | 7.52 | 13.62 | 50.41 | 7.39 | 13.21 | 48.57 | 3.70 | 3.69 | 36.02 | 8.98 |

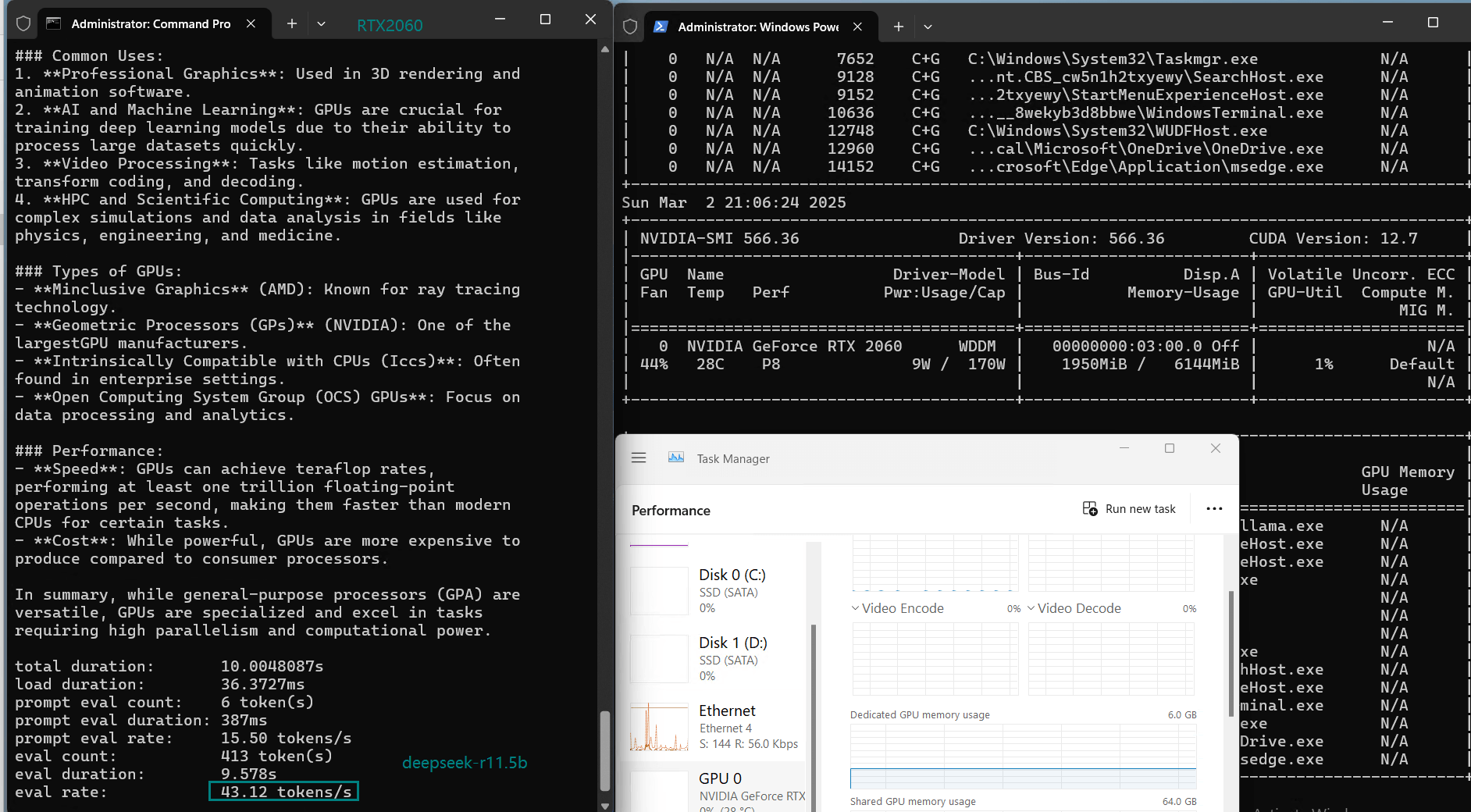

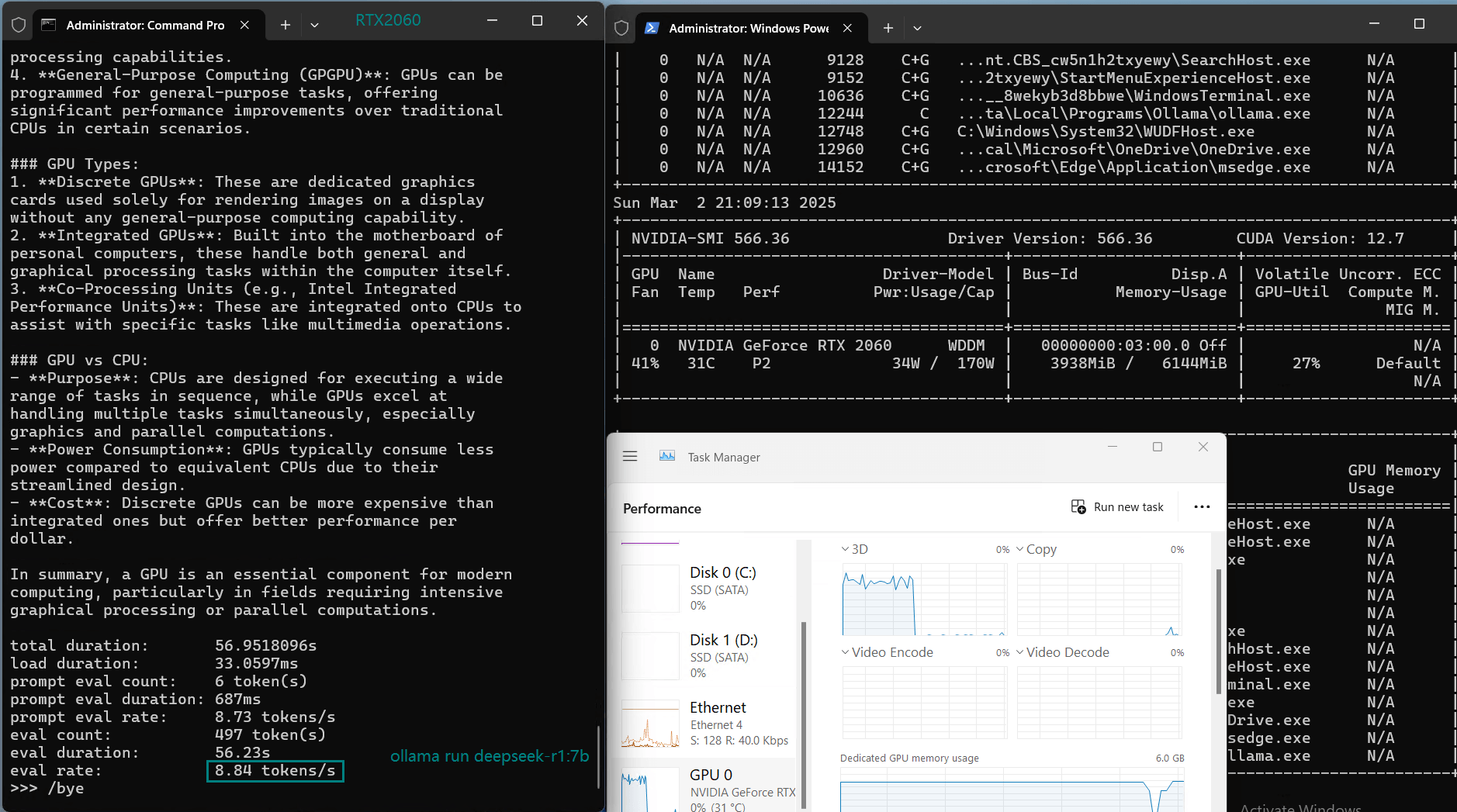

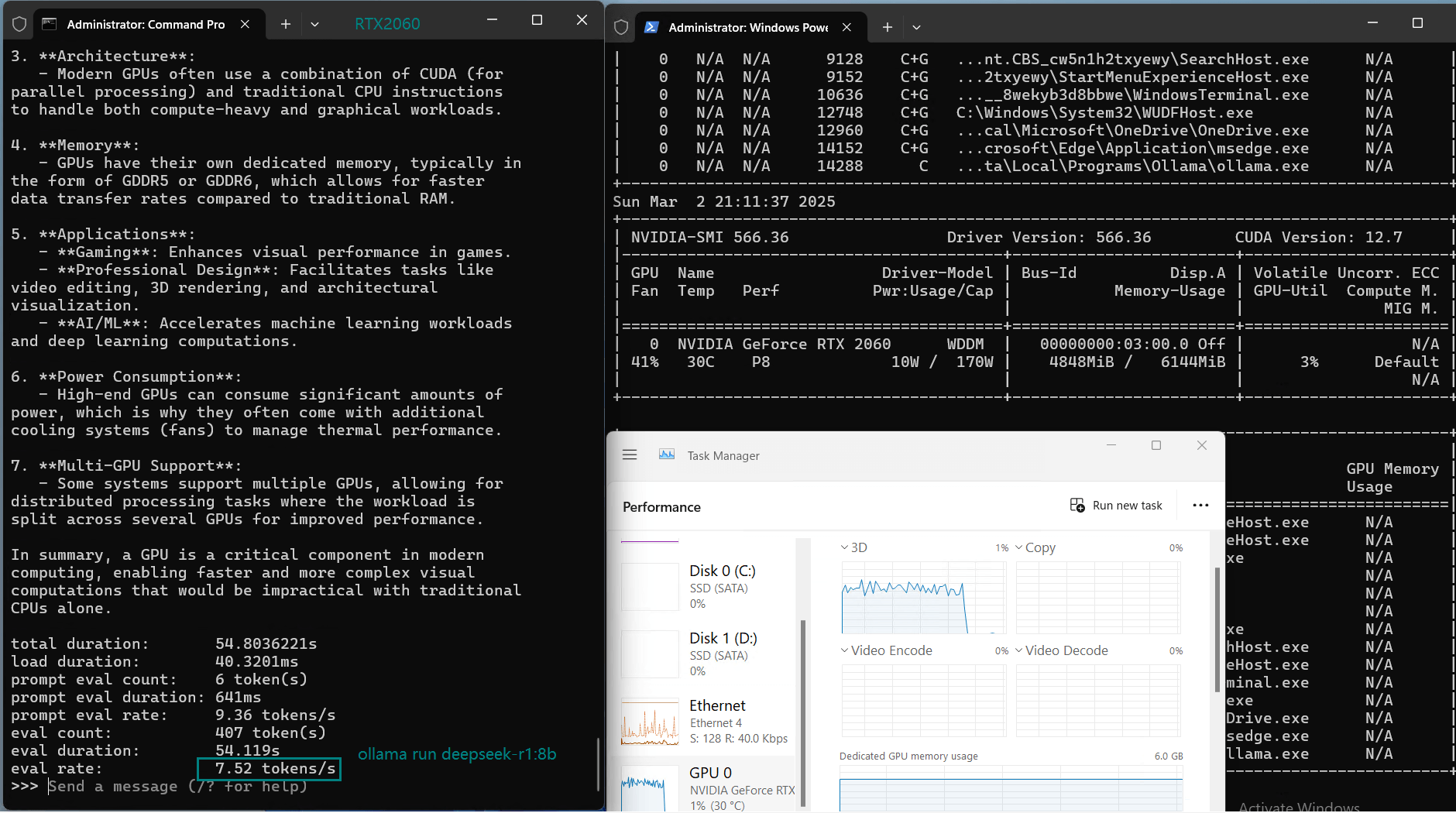

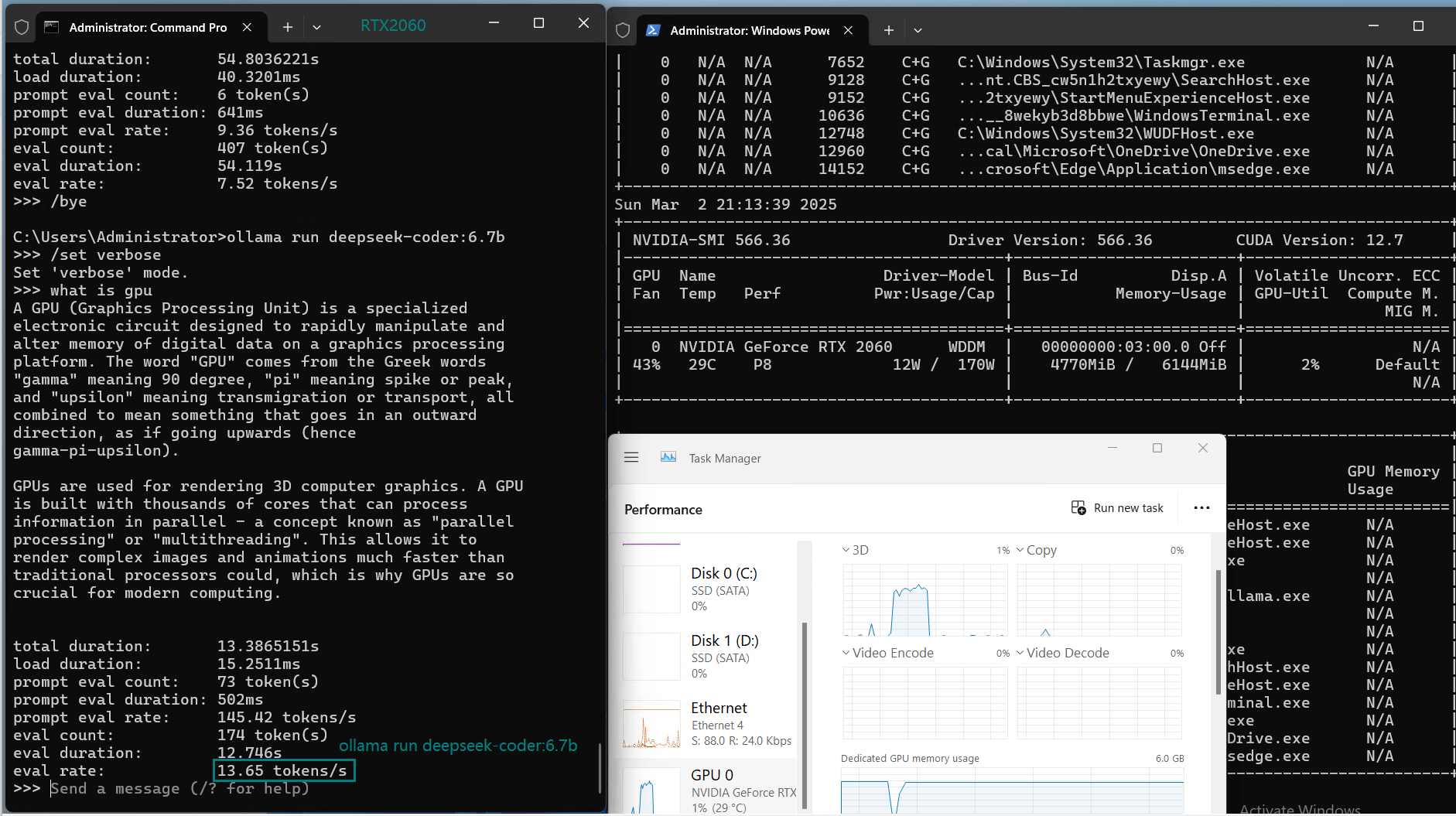

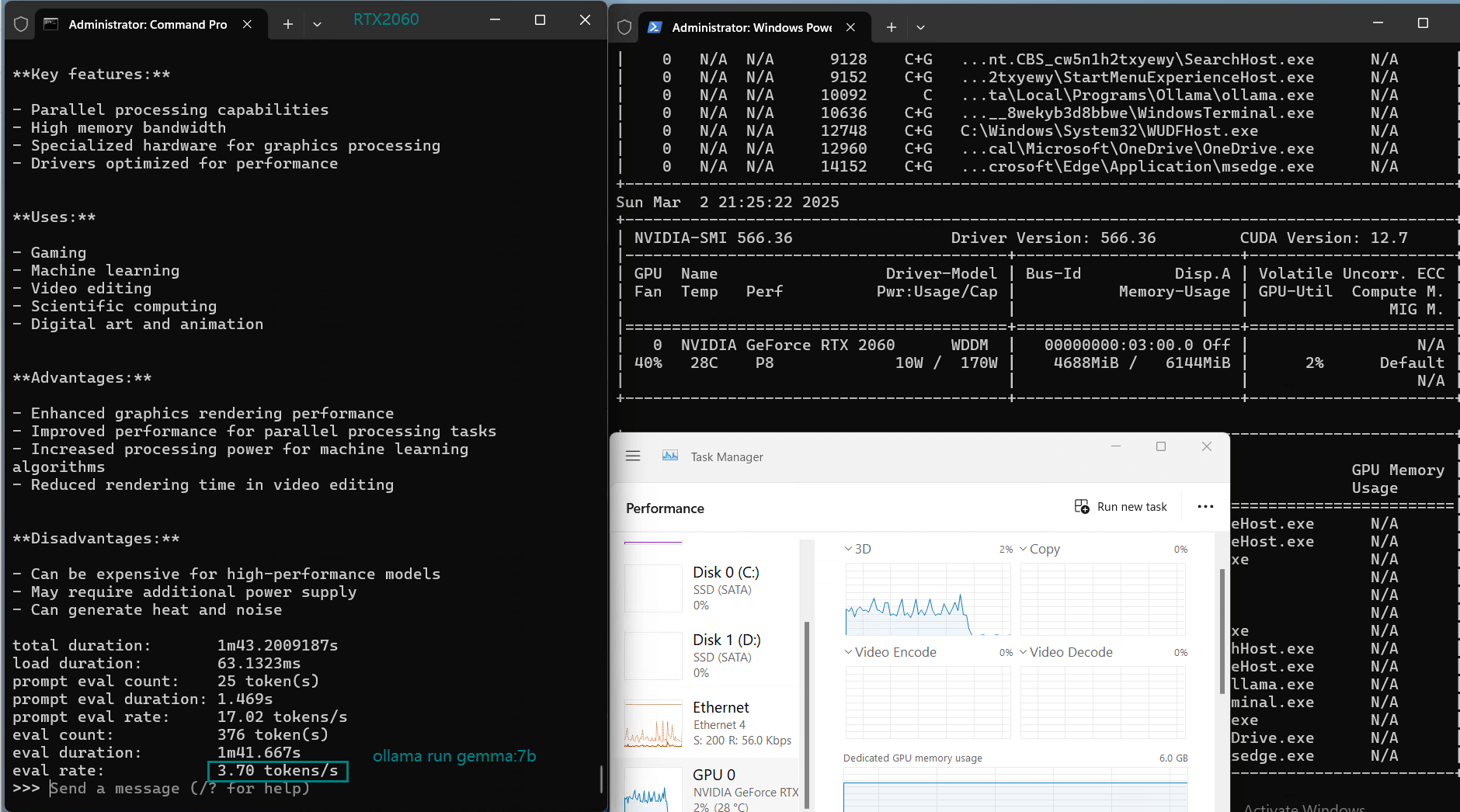

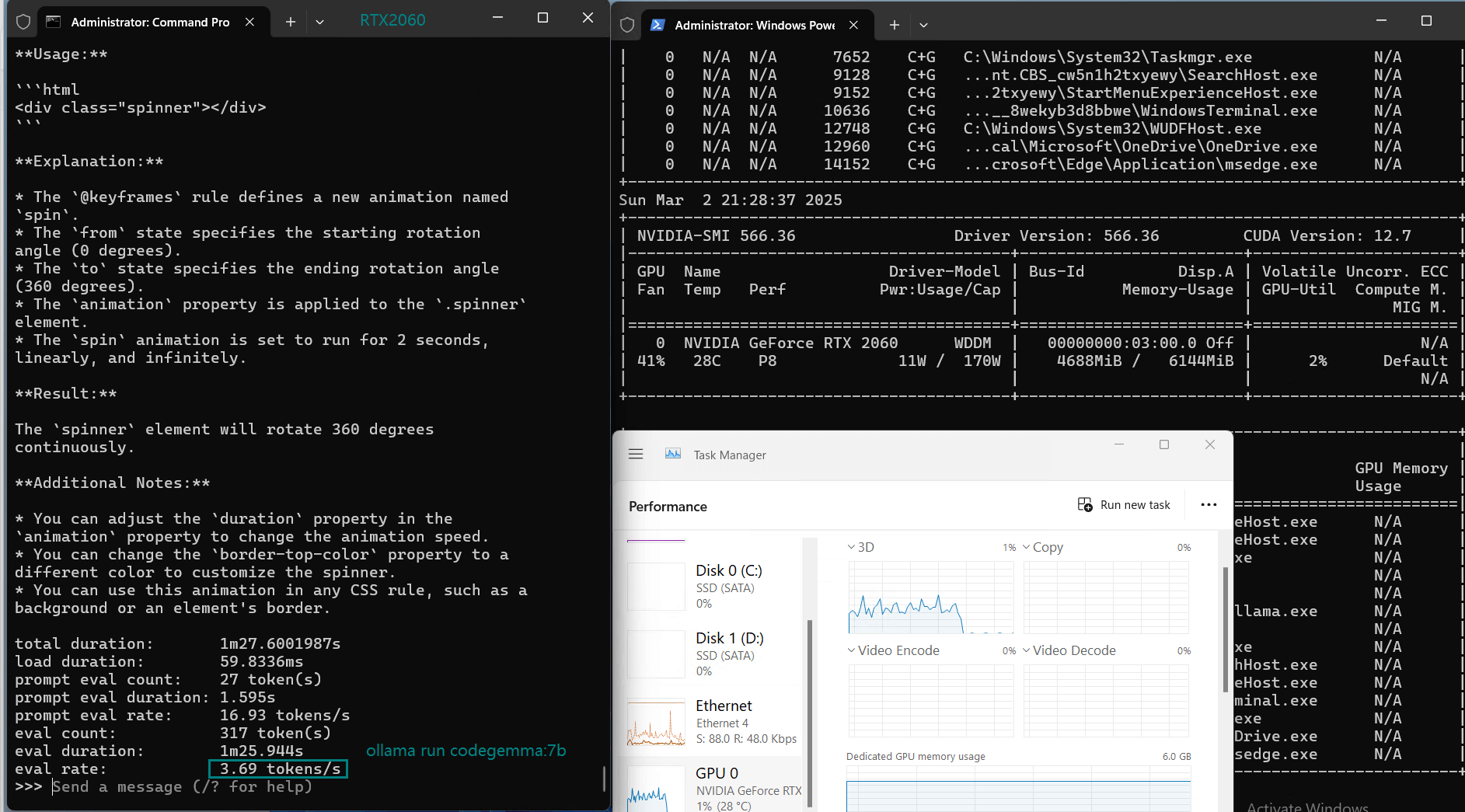

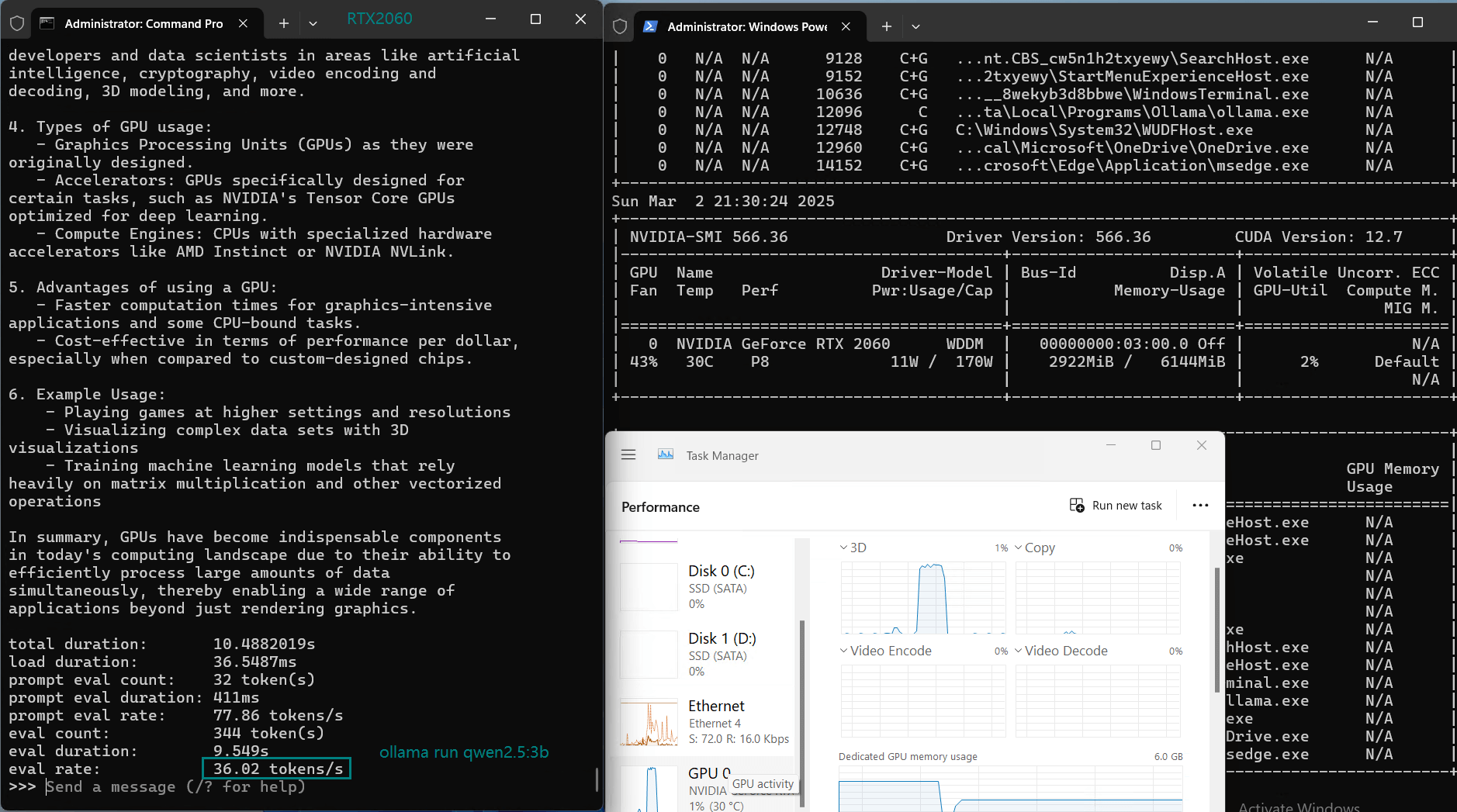

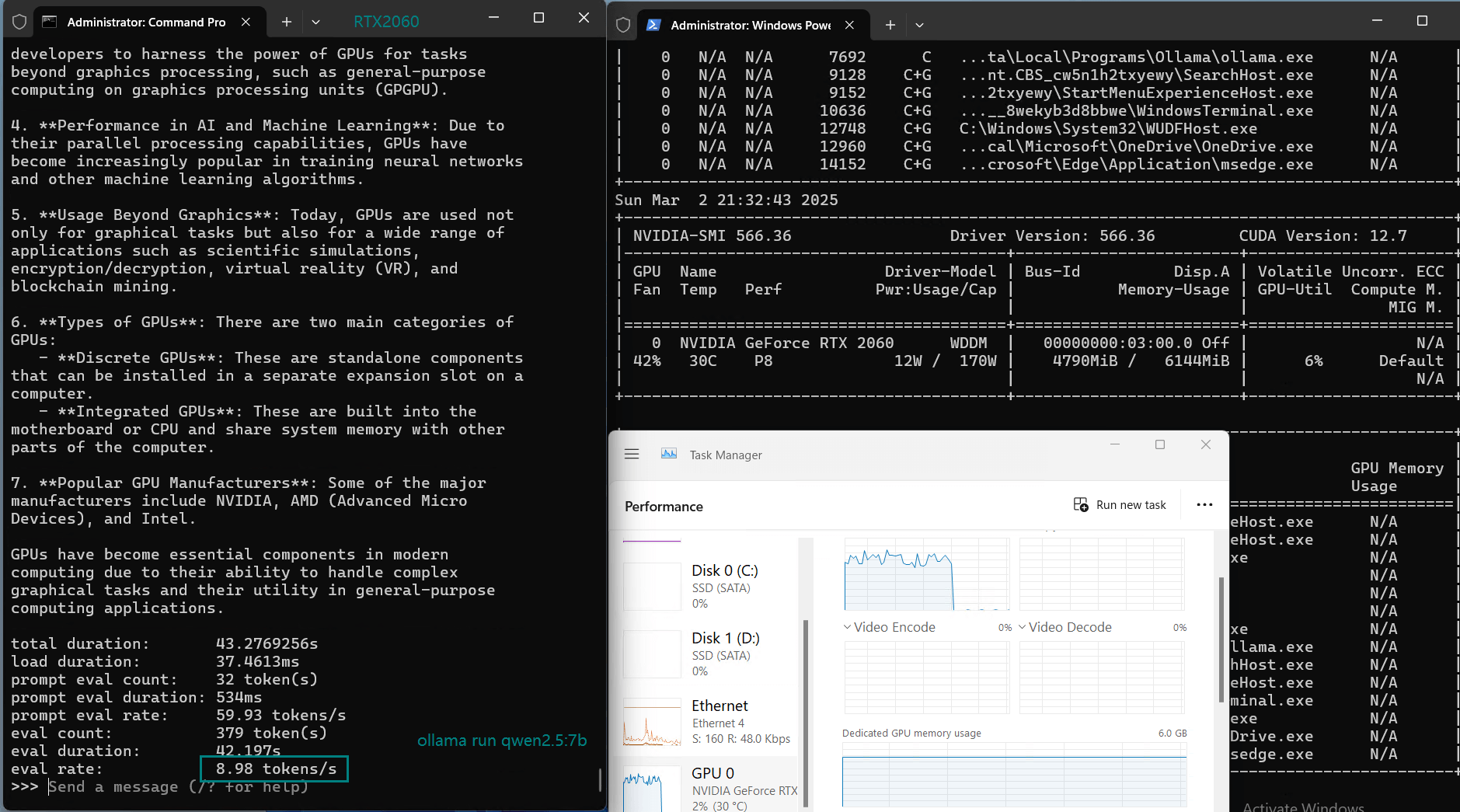

一段用于记录 RTX 2060 GPU 服务器实时资源消耗数据的视频:

在 Nvidia RTX2060 GPU 服务器上使用 Ollama 对 LLM 进行基准测试的截图

基准测试的主要发现

1️⃣.RTX2060 在 30 亿参数模型上表现良好

Llama 3.2(3B)提供了最快的推理速度(50.41 tokens/秒),是 RTX2060 小型 LLM 推理的最佳选择。Qwen 2.5(3B)也表现不错,速度为 36.02 tokens/秒,略慢于 Llama 3.2。

2️⃣.RTX2060 在 70 亿以上模型上表现吃力

像 Mistral 7B、DeepSeek 7B 和 Llama 3.1(8B)这样的模型推理速度较低(7-9 tokens/秒),显存使用接近 80%。虽然技术上可以运行,但性能对于实时应用来说过慢。

3️⃣.30 亿参数模型的高效利用

对于参数量 ≤3B 的模型,GPU 利用率保持在 50-60% 之间。RAM 和 CPU 使用率仍然很低(CPU <10%,内存 <6%)。

开始使用 RTX2060 主机部署小型 LLM

对于在 Ollama 上部署 LLM 的用户,选择合适的 NVIDIA RTX2060 主机方案可以显著影响性能和成本。如果您使用的是 0.5B–3B 参数的模型,RTX2060 是一个价格实惠、适合 AI 推理的可靠选择。

新年特惠

GPU云服务器 - A4000

¥ 692.45/月

立省45% (原价¥1259.00)

月付季付年付两年付

立即订购- 配置: 24核32GB, 独立IP

- 存储: 320GB SSD系统盘

- 带宽: 300Mbps 不限流

- 赠送: 每2周一次自动备份

- 系统: Win10/Linux

- 其他: 1个独立IP

- 独显: Nvidia RTX A4000

- 显存: 16GB GDDR6

- CUDA核心: 6144

- 单精度浮点: 19.2 TFLOPS

新年特惠

GPU物理服务器 - RTX 2060

¥ 629.55/月

立省55% (原价¥1399.00)

月付季付年付两年付

立即订购- CPU: 16核E5-2660*2

- 内存: 128GB DDR3

- 系统盘: 120GB SSD

- 数据盘: 960GB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia RTX 2060

- 显存: 6GB GDDR6

- CUDA核心: 1920

- 单精度浮点: 6.5 TFLOPS

GPU物理服务器 - RTX 3060 Ti

¥ 1499.00/月

月付季付年付两年付

立即订购- CPU: 24核E5-2697v2*2

- 内存: 128GB DDR3

- 系统盘: 240GB SSD

- 数据盘: 2TB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显:RTX 3060 Ti

- 显存: 8GB GDDR6

- CUDA核心: 4864

- 单精度浮点: 16.2 TFLOPS

结论:RTX2060 最适合 30 亿参数模型

如果您希望使用 RTX2060 在 Ollama 上搭建经济实惠的 LLM 服务器,最佳选择是 30 亿参数的模型,如 Llama 3.2 和 Qwen 2.5。

最终推荐

- 追求快速推理 → Llama 3.2(3B)

- 替代选择 → Qwen 2.5(3B)

- 避免使用超过 70 亿参数的模型,因为速度慢且显存占用高

本次 RTX2060 Ollama 基准测试表明,Nvidia RTX2060 主机适合小型 LLM 推理,但不适合参数量超过 30 亿的模型。如果您需要运行 70 亿以上的模型,建议选择更高端的显卡,如 RTX 3060 或 A4000 服务器。

标签:

RTX2060 Ollama 基准测试、RTX2060 AI 推理、RTX2060 最佳 LLM、 Nvidia RTX2060 托管,、Llama 3 RTX2060、Qwen RTX2060、Mistral AI 基准测试、DeepSeek AI、小型 LLM 推理、经济型 AI 显卡