硬件介绍:RTX 3060 Ti概述

测试的美国服务器配置如下:

服务器配置:

- CPU:双12核E5-2697v2(24核心 & 48线程)

- 内存:128GB RAM

- 存储:240GB SSD + 2TB SSD

- 网络:100Mbps-1Gbps

- 操作系统:Windows 11 Pro

GPU详细信息:

- GPU:GeForce RTX 3060 Ti

- 微架构:Ampere

- 计算能力:8.6

- CUDA核心:4864

- 张量核心:152

- 虚拟内存:8GB GDDR6

- FP32性能:16.2 TFLOPS

这款GPU在成本和性能之间取得了平衡,非常适合AI工作负载和游戏基准测试。在LLM托管方面,8GB的显存足以运行量化模型(4位精度),这种方法大幅降低了内存需求,同时不会显著影响性能。

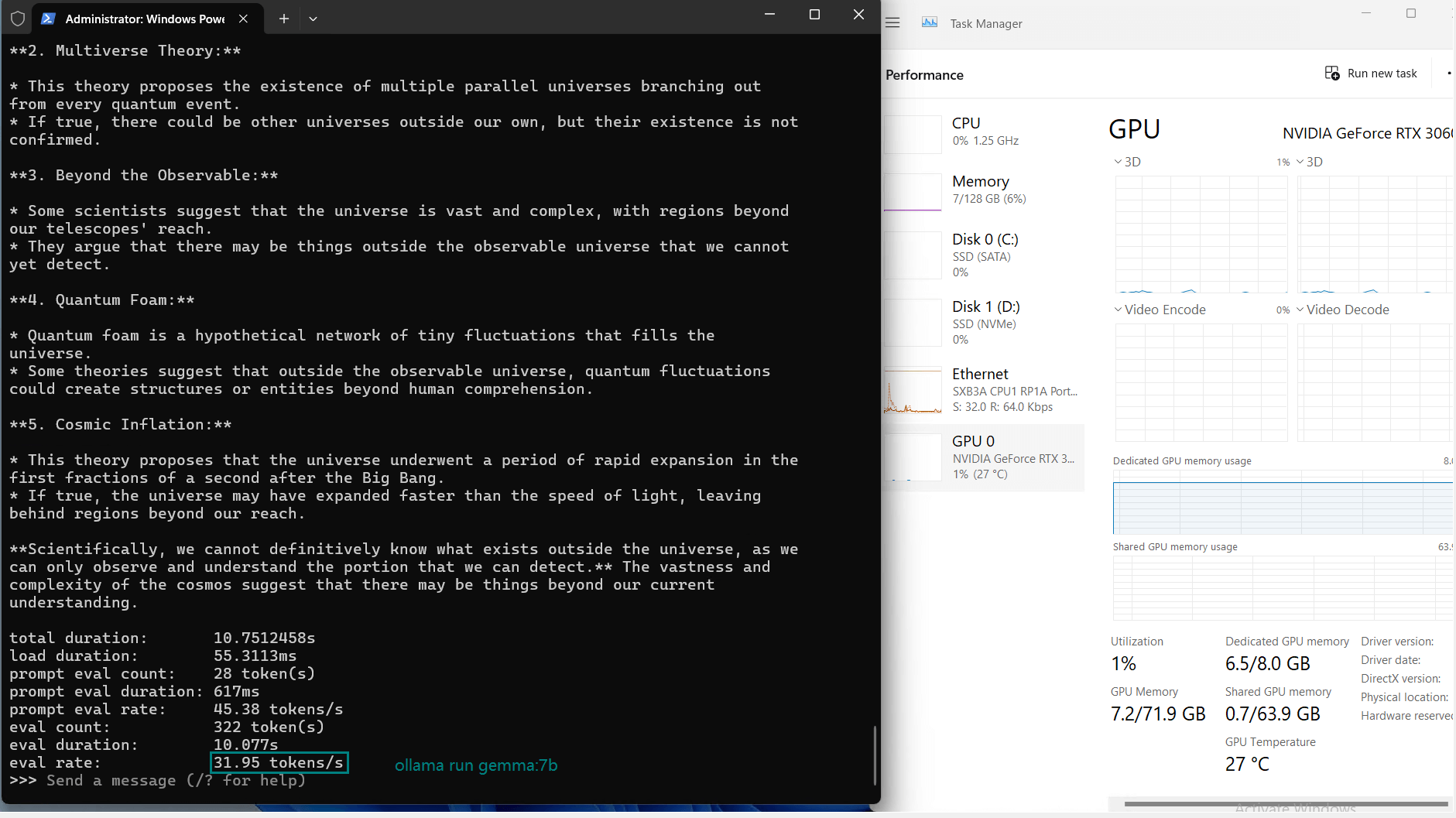

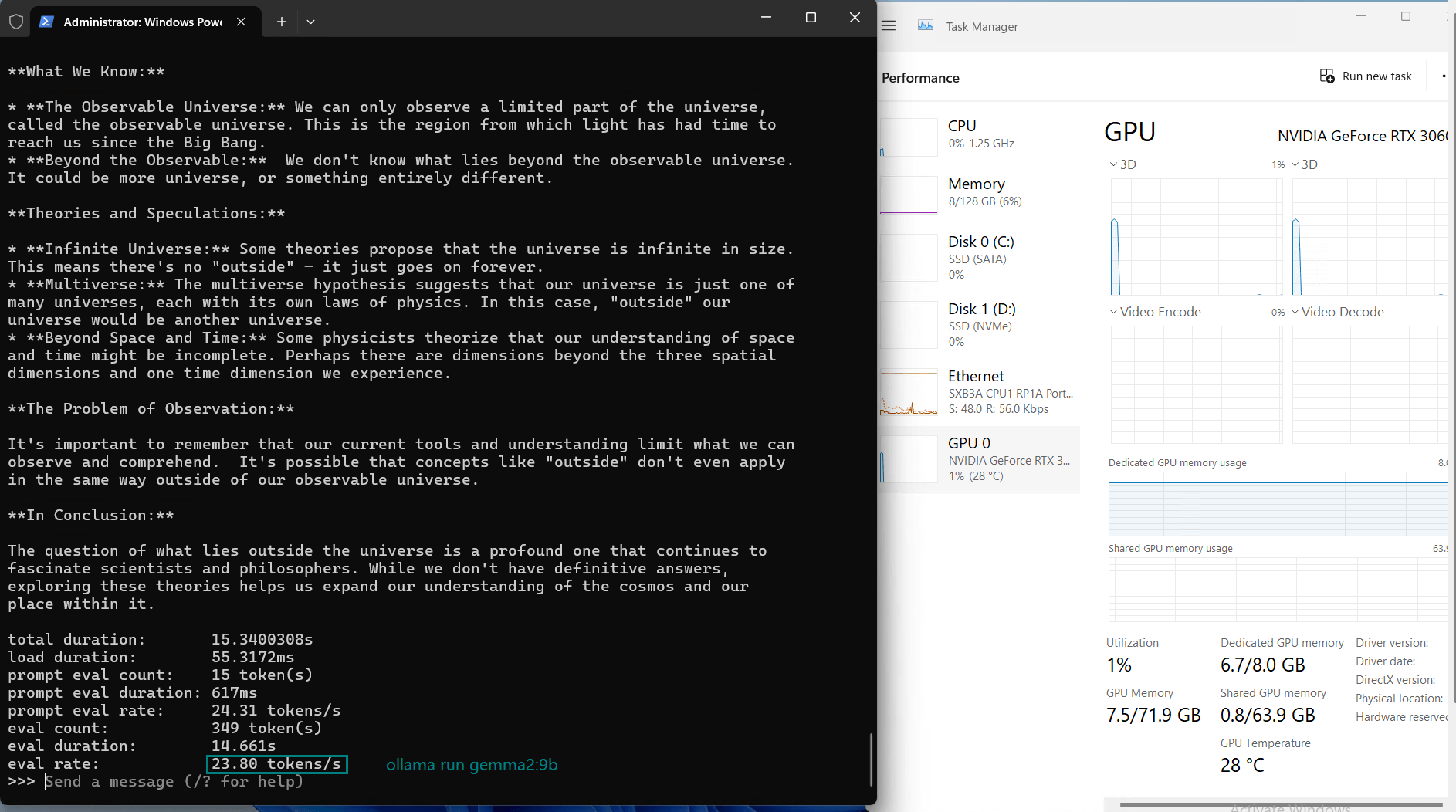

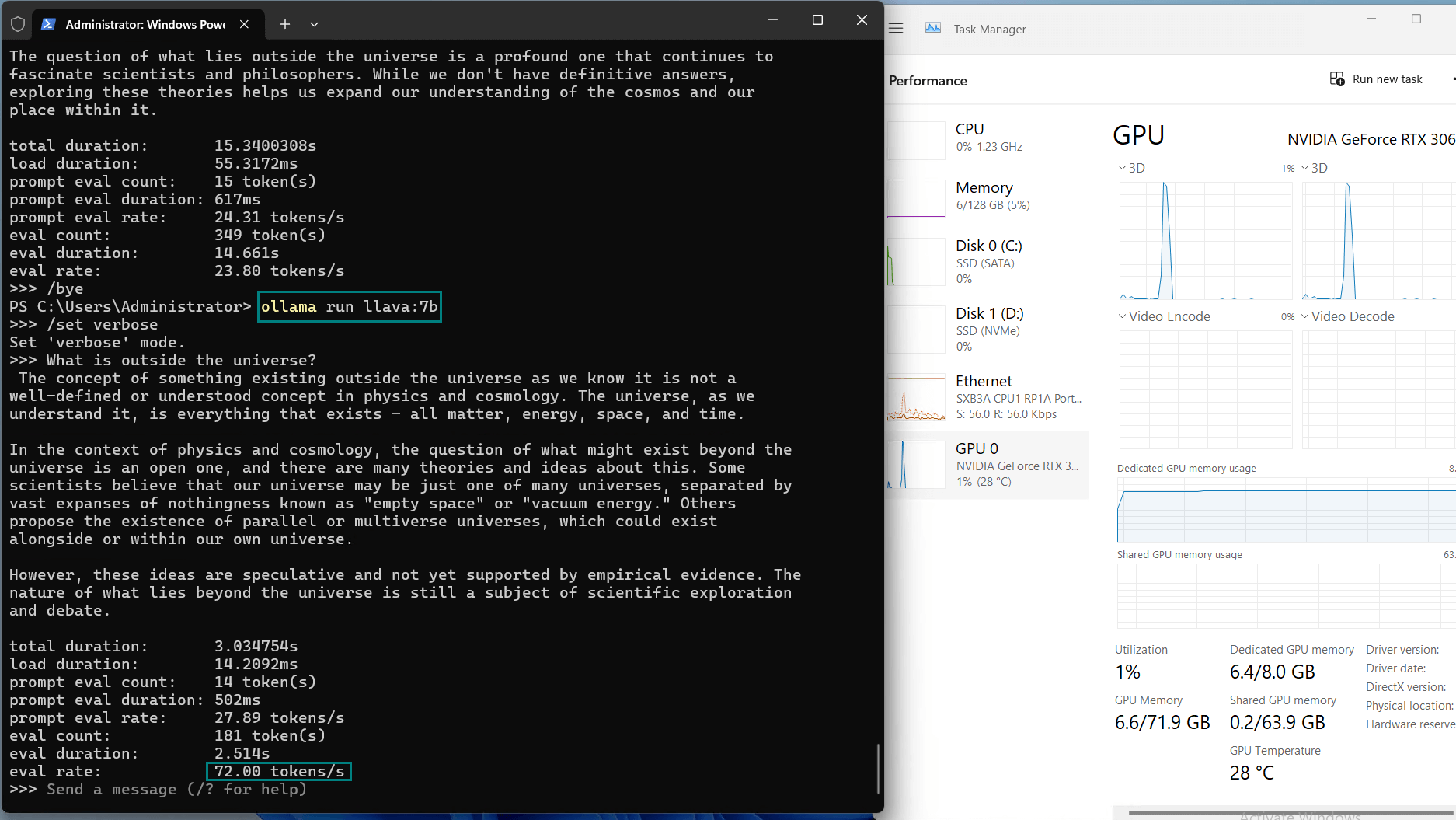

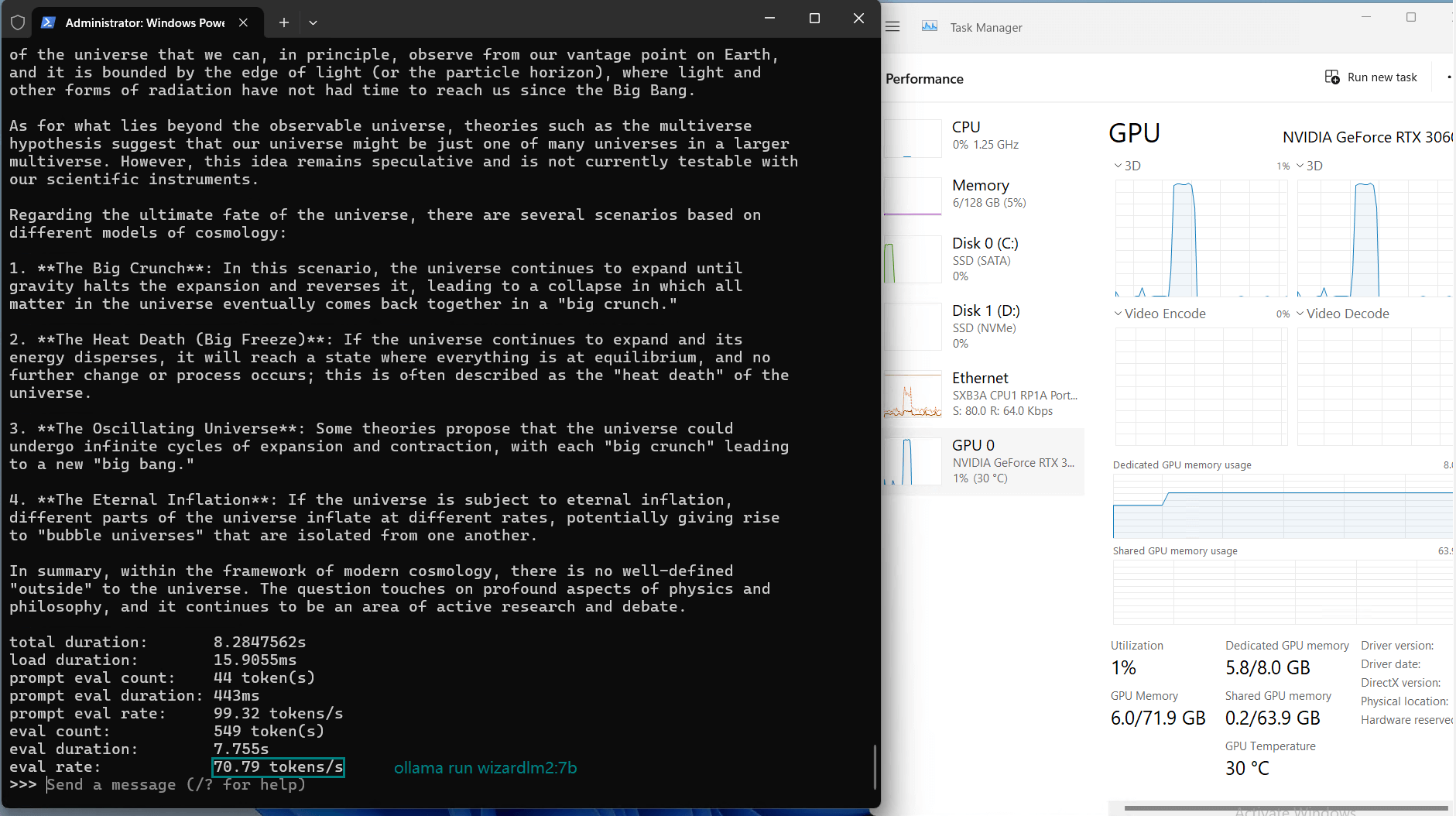

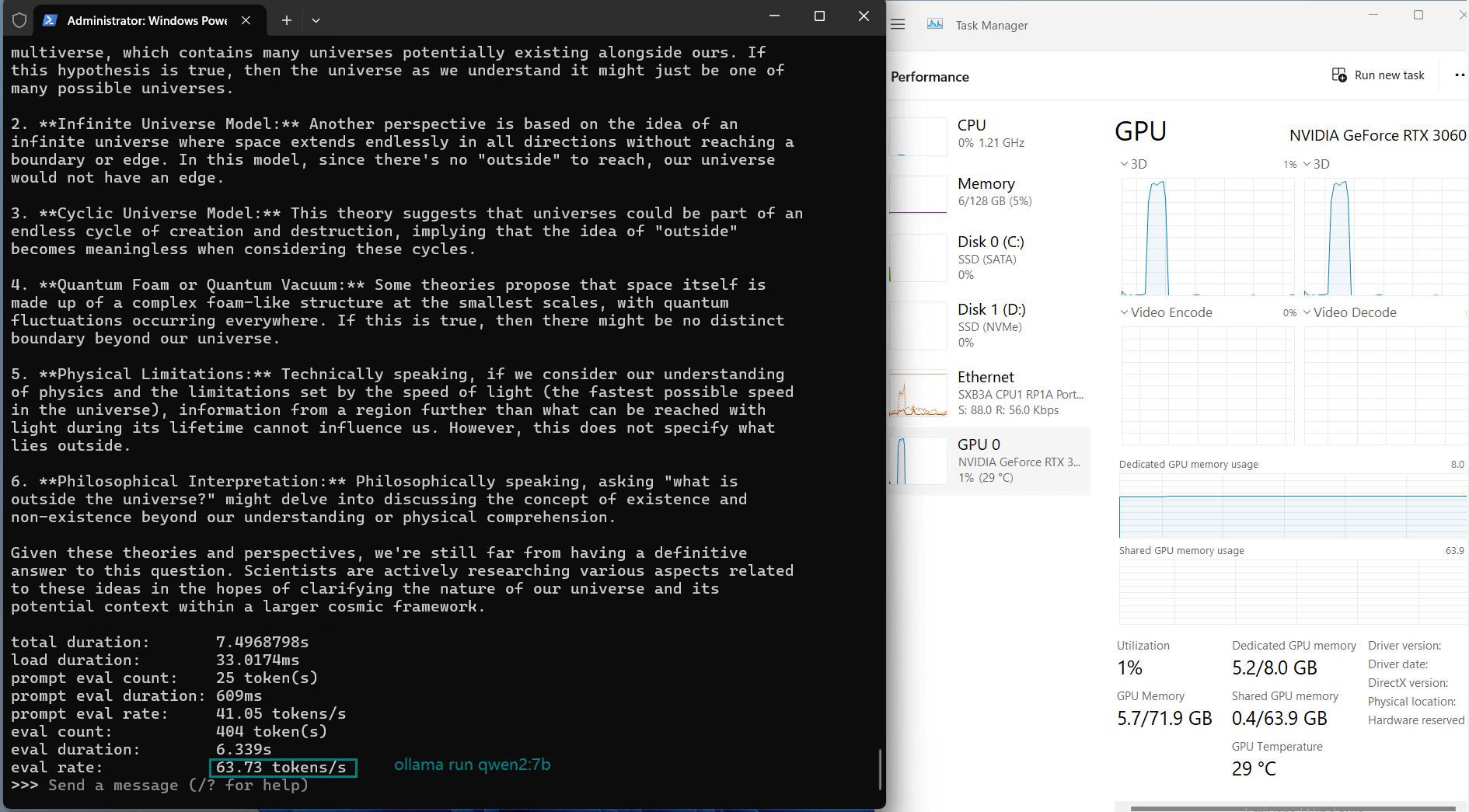

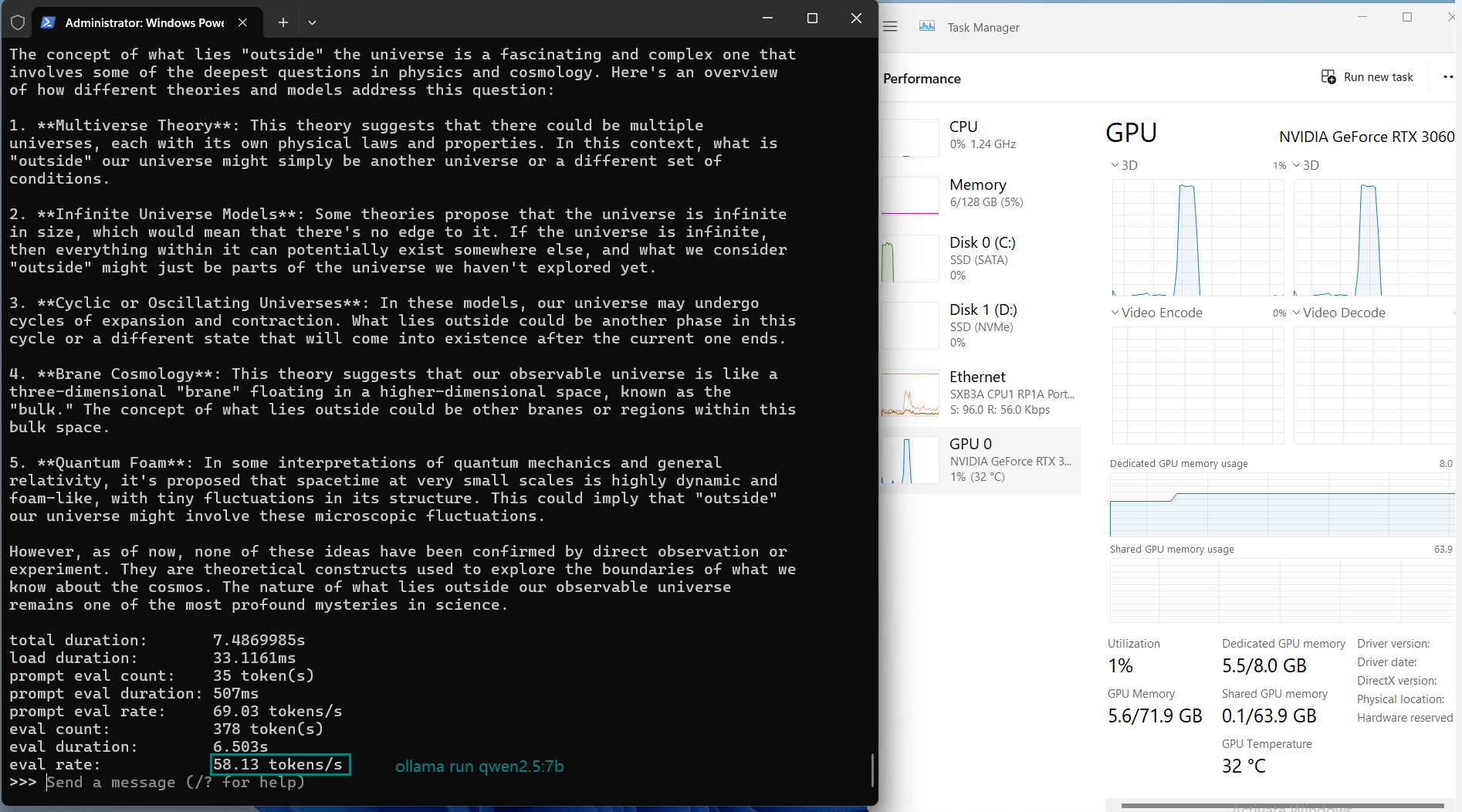

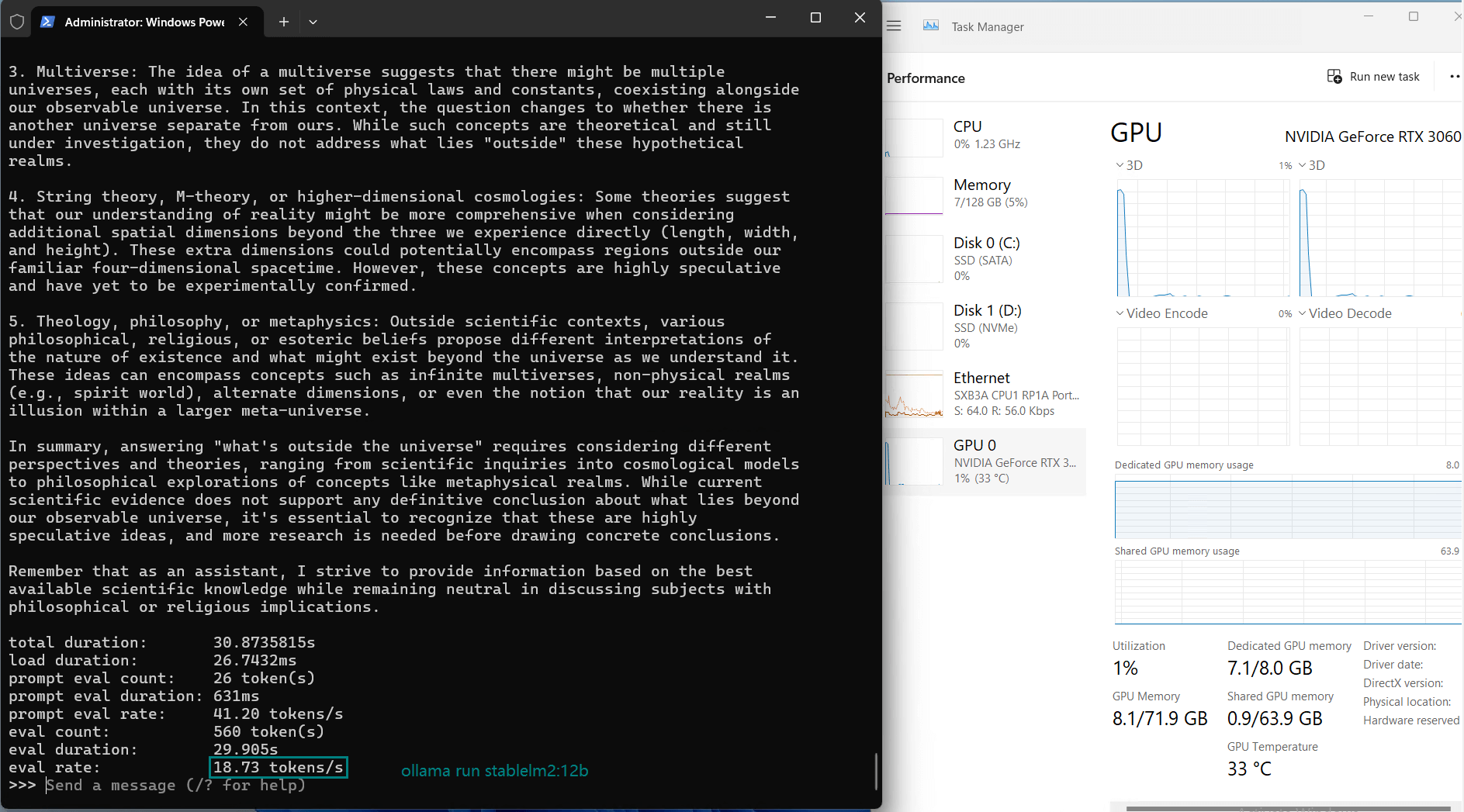

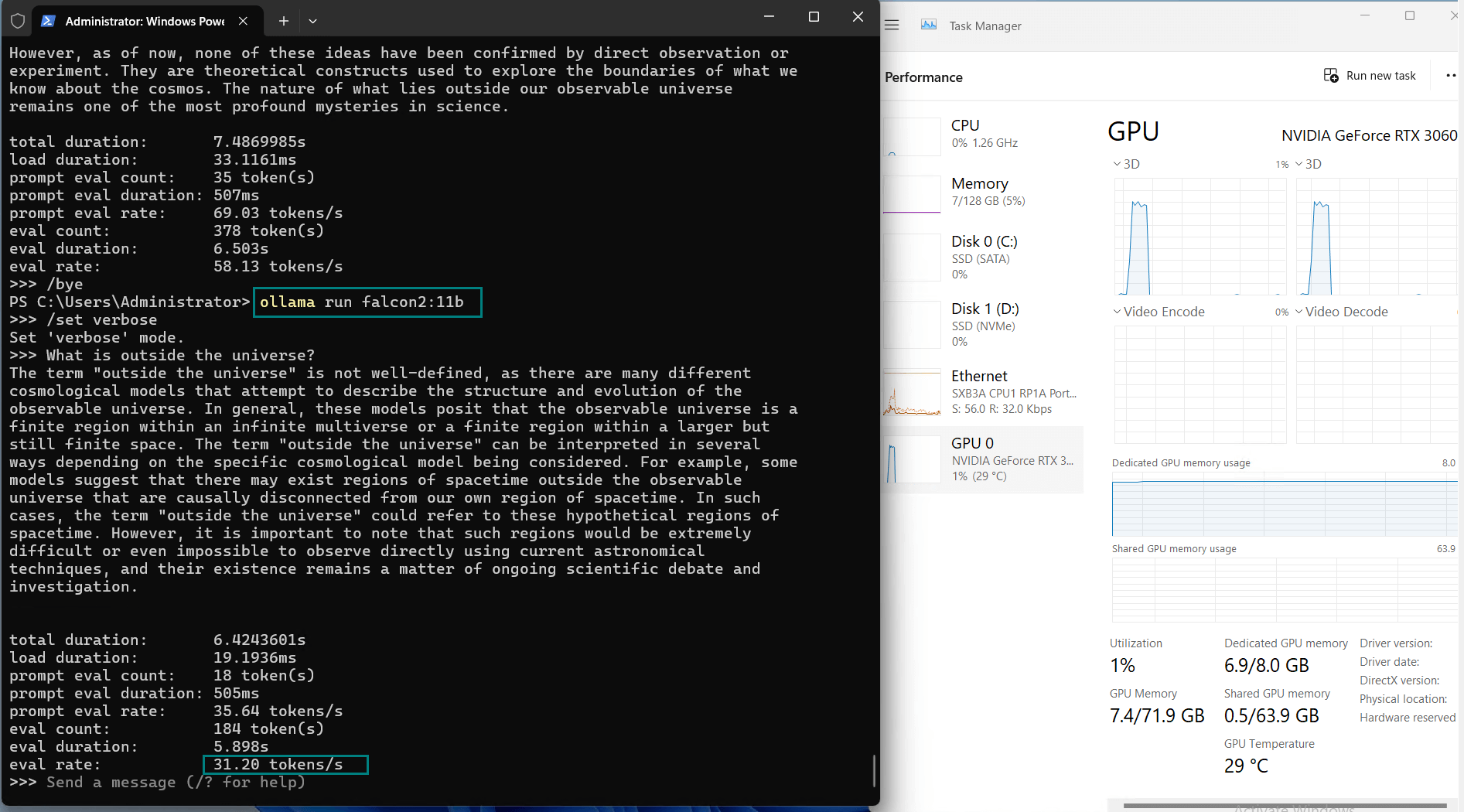

数据结果:在 Ollama 上进行 LLM 基准测试

以下是在 Nvidia RTX 3060 Ti GPU 上运行模型时获得的基准测试结果:

| 模型 | llama2 | llama2 | llama3.1 | mistral | gemma | gemma2 | llava | wizardlm2 | qwen2 | qwen2.5 | stablelm2 | falcon2 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 7b | 13b | 8b | 7b | 7b | 9b | 7b | 7b | 7b | 7b | 12b | 11b |

| 文件大小(GB) | 3.8 | 7.4 | 4.9 | 4.1 | 5.0 | 5.4 | 4.7 | 4.1 | 4.4 | 4.7 | 7.0 | 6.4 |

| 量化 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 运行平台 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 |

| 模型下载速度(mb/s) | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 |

| CPU 利用率 | 2% | 27-42% | 3% | 3% | 20% | 21% | 3% | 3% | 3% | 3% | 15% | 8 |

| RAM 利用率 | 3% | 7% | 5% | 5% | 9% | 6% | 5% | 5% | 5% | 5% | 5% | 5% |

| GPU vRAM | 63% | 84% | 80% | 70% | 81% | 83% | 80% | 70% | 65% | 68% | 90% | 85% |

| GPU 利用率 | 98% | 30-40% | 98% | 88% | 93% | 68% | 98% | 100% | 98% | 96% | 90% | 80% |

| 文本输出速率(tokens/s) | 73.07 | 9.25 | 57.34 | 71.16 | 31.95 | 23.80 | 72.00 | 70.79 | 63.73 | 58.13 | 18.73 | 31.20 |

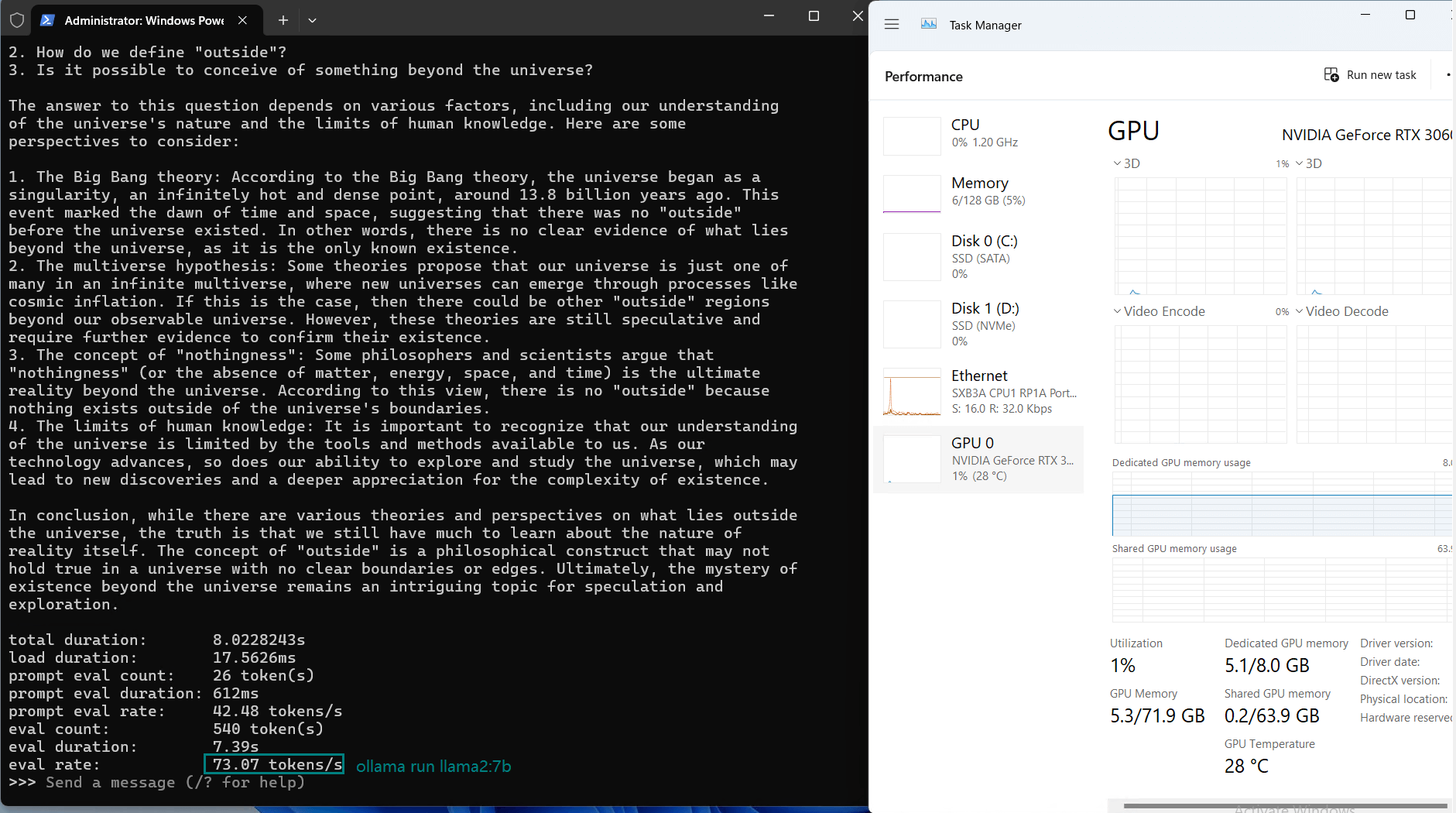

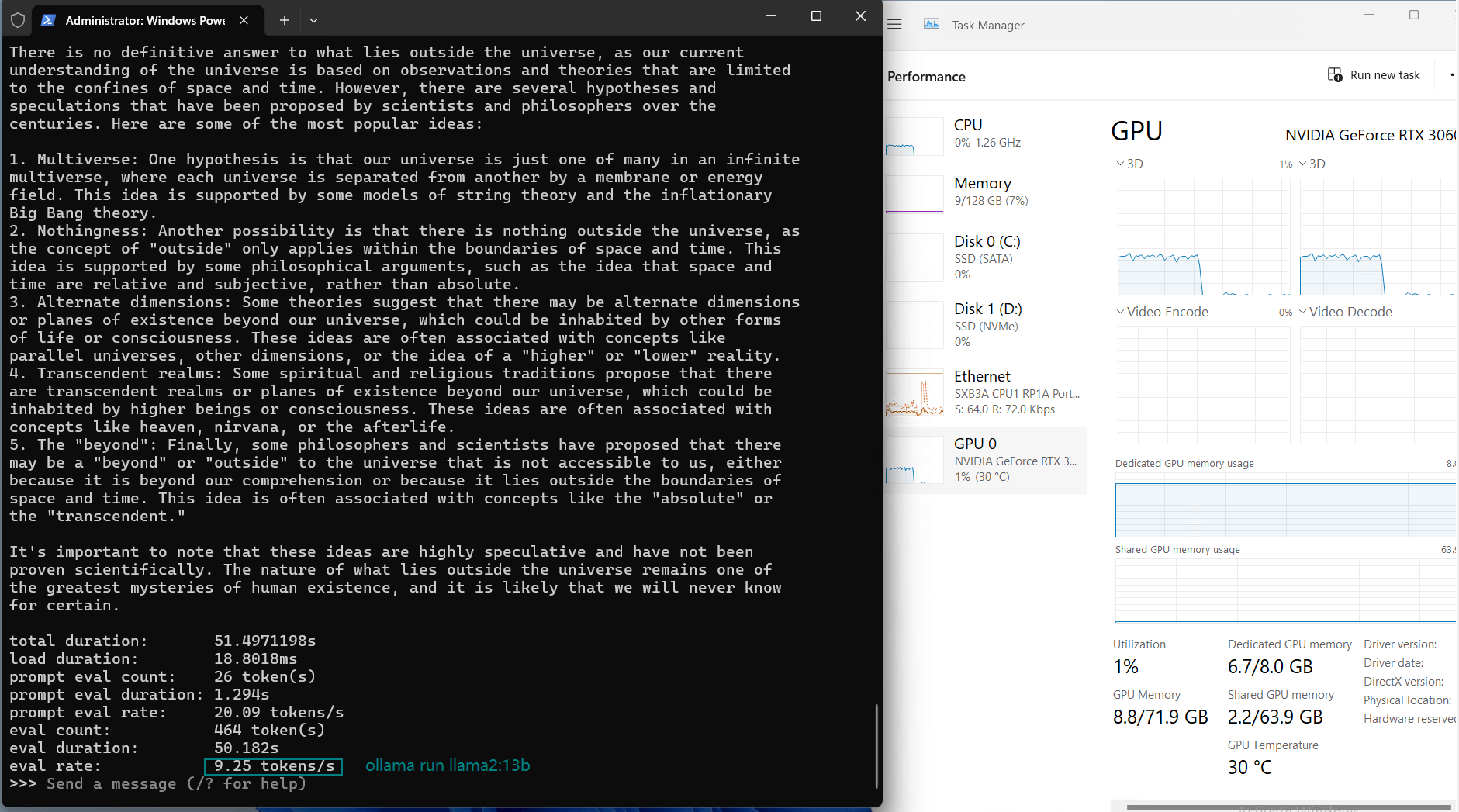

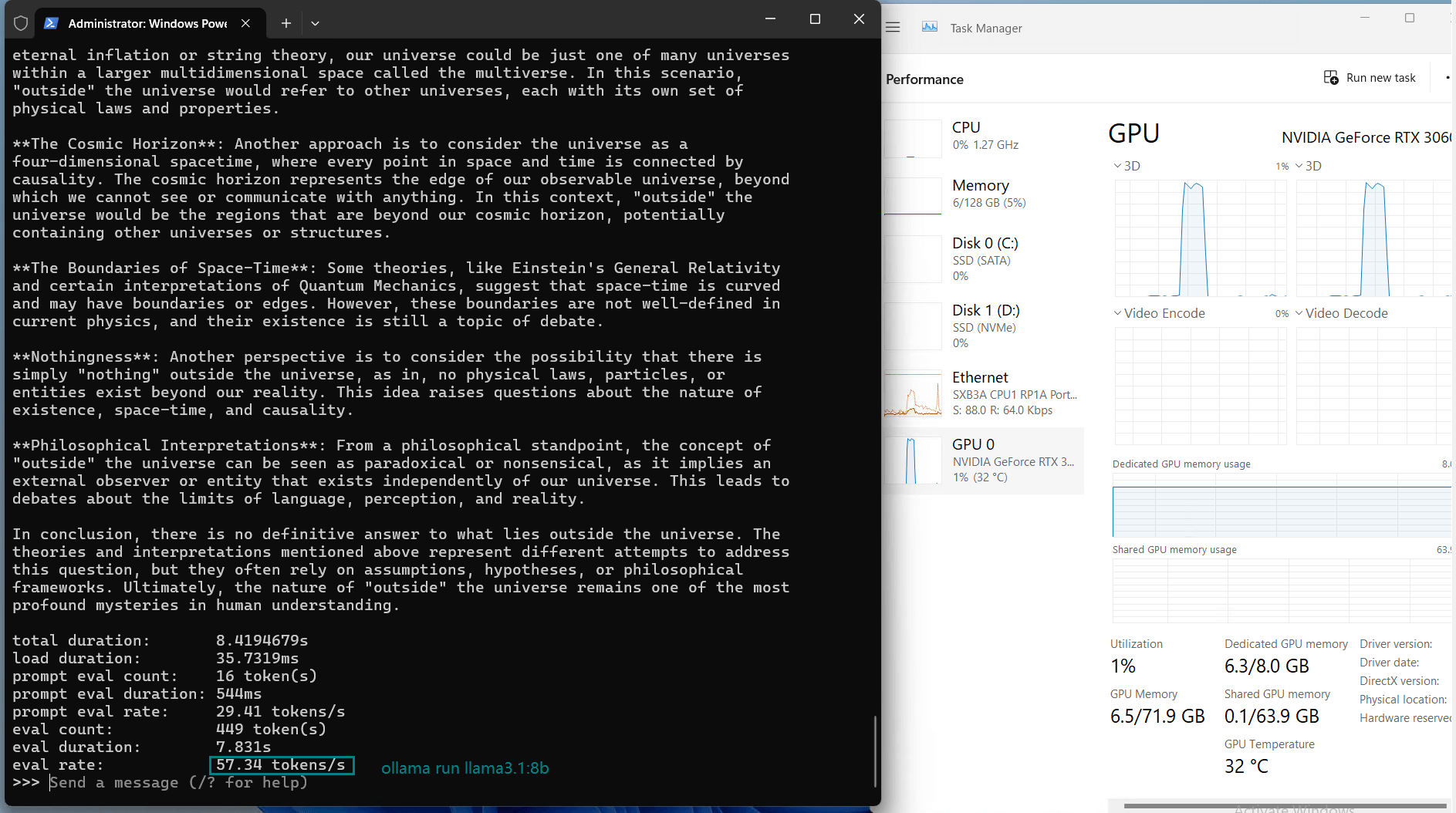

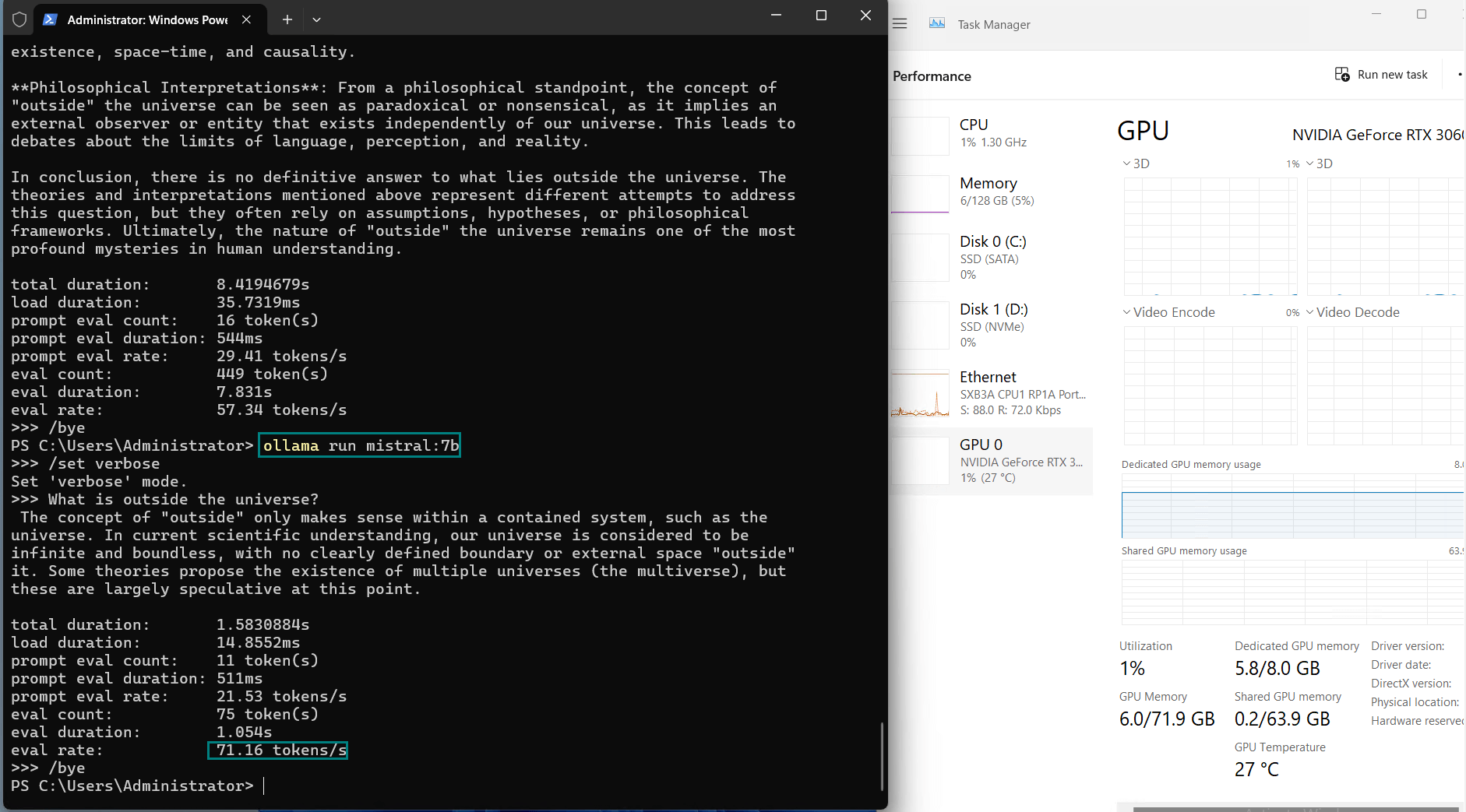

记录实时gpu服务器资源消耗数据:

屏幕截图:点击放大并查看

对Nvidia RTX 3060 Ti服务器的观察

1. 较小模型效率高

像Llama 2 (7b) 和 Mistral (7b) 这样的模型在RTX 3060 Ti上表现出色,GPU利用率高达98%,推理速度快(70+ tokens/s)。这些模型非常适合实时应用,特别是在RTX 3060服务器上托管时。

2. 较大模型效率低

像StableLM 2 (12b) 和 Falcon 2 (11b) 这样的模型超出了RTX 3060 Ti 8GB显存的限制,导致推理速度变慢。Llama 2 (13b)需要更多内存,更适合具有更大显存的GPU,如RTX 3090或4090。

3. 4位量化是至关重要的

将所有模型以4位精度运行对于适配RTX 3060 Ti的显存至关重要。如果没有量化,这些工作负载将超过GPU的显存,导致依赖CPU进行回退处理,从而降低性能。

4. CPU和RAM使用情况

大多数模型的CPU和RAM使用率相对较低,突出了GPU在此配置中处理了大部分工作负载。这也是使用RTX 3060 Ti进行Ollama托管的有力论据,因为它能够最小化额外的系统资源需求。

立即租用 RTX3060Ti 专用服务器

虽然 RTX 3060 Ti 在这项基准测试中表现出色,但它仍不及 VRAM 容量更高的 GPU,例如 RTX A4000(16GB)或 A5000(24GB)。这些 GPU 可以运行更大的模型,例如 13b-34b。然而,对于优先考虑成本效益的开发人员来说,RTX 3060 Ti 实现了良好的平衡,尤其是对于小于9b 的LLM 而言。

GPU物理服务器 - T1000

¥ 739.00/月

月付季付年付两年付

立即订购- CPU: 8核E5-2690

- 内存: 64GB DDR3

- 系统盘: 120GB SSD

- 数据盘: 960GB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia Quadro T1000

- 显存: 8GB GDDR6

- CUDA核心: 896

- 单精度浮点: 2.5 TFLOPS

新年特惠

GPU物理服务器 - RTX 3060 Ti

¥ 789.13/月

立省53% (原价¥1679.00)

月付季付年付两年付

立即订购- CPU: 24核E5-2697v2*2

- 内存: 128GB DDR3

- 系统盘: 240GB SSD

- 数据盘: 2TB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显:RTX 3060 Ti

- 显存: 8GB GDDR6

- CUDA核心: 4864

- 单精度浮点: 16.2 TFLOPS

新年特惠

GPU物理服务器 - A5000

¥ 1102.05/月

立省55% (原价¥2449.00)

月付季付年付两年付

立即订购- CPU: 24核E5-2697v2*2

- 内存: 128GB DDR3

- 系统盘: 240GB SSD

- 数据盘: 2TB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia RTX A5000

- 显存: 24GB GDDR6

- CUDA核心: 8192

- 单精度浮点: 27.8 TFLOPS

结论:RTX 3060 Ti是否适合LLM托管?

RTX 3060 Ti证明是一款具有成本效益的LLM基准测试选择,尤其是在配合Ollama的高效量化时。对于涉及13亿参数以下的模型,这一配置提供了竞争力的性能、高效性和低资源消耗。如果你在寻找一种负担得起的RTX 3060托管解决方案来运行Ollama中的LLM,这款GPU提供了稳定的表现,并且价格适中。

- 适合运行小型和中型的大型语言模型(4B-12B参数)。

- 开发者希望在低功耗下测试LLM的推理能力。

- 预算有限,但需要高性能GPU专用服务器。

对于更大规模的应用,建议升级到具有更多显存的GPU。然而,对于大多数处理量化LLM的开发者或寻求紧凑型RTX 3060基准测试的用户,这一配置仍然是强烈推荐的选择。

Tags:

RTX 3060基准测试, Ollama基准测试, LLM基准测试, Ollama测试, Nvidia RTX 3060基准测试, Ollama 3060, RTX 3060托管, Ollama RTX服务器