服务器配置:Nvidia Tesla P100 托管环境

在开始介绍 Ollama P100 基准测试之前,我们先来了解一下测试环境的配置:

服务器配置:

- 价格:1239~1399人民币/月

- CPU:双核10核心英特尔至强E5-2660v2处理器

- 内存:128GB DDR3

- 存储:120GB NVMe固态硬盘+960GB SSD

- 网络:100Mbps无限流量

- 操作系统:Windows 11 Pro

GPU 详细信息:

- GPU:Nvidia Tesla P100

- 计算能力:6.0

- 架构:Pascal

- CUDA核心数:3584

- 内存:16GB HBM2

- FP32性能:9.5 TFLOPS

这种配置提供了充足的内存和存储空间,能够确保模型加载和运行流畅,而P100的16GB显存也使得运行更大规模的模型成为可能,这与我们之前进行的RTX2060 Ollama性能测试相比有显著提升。

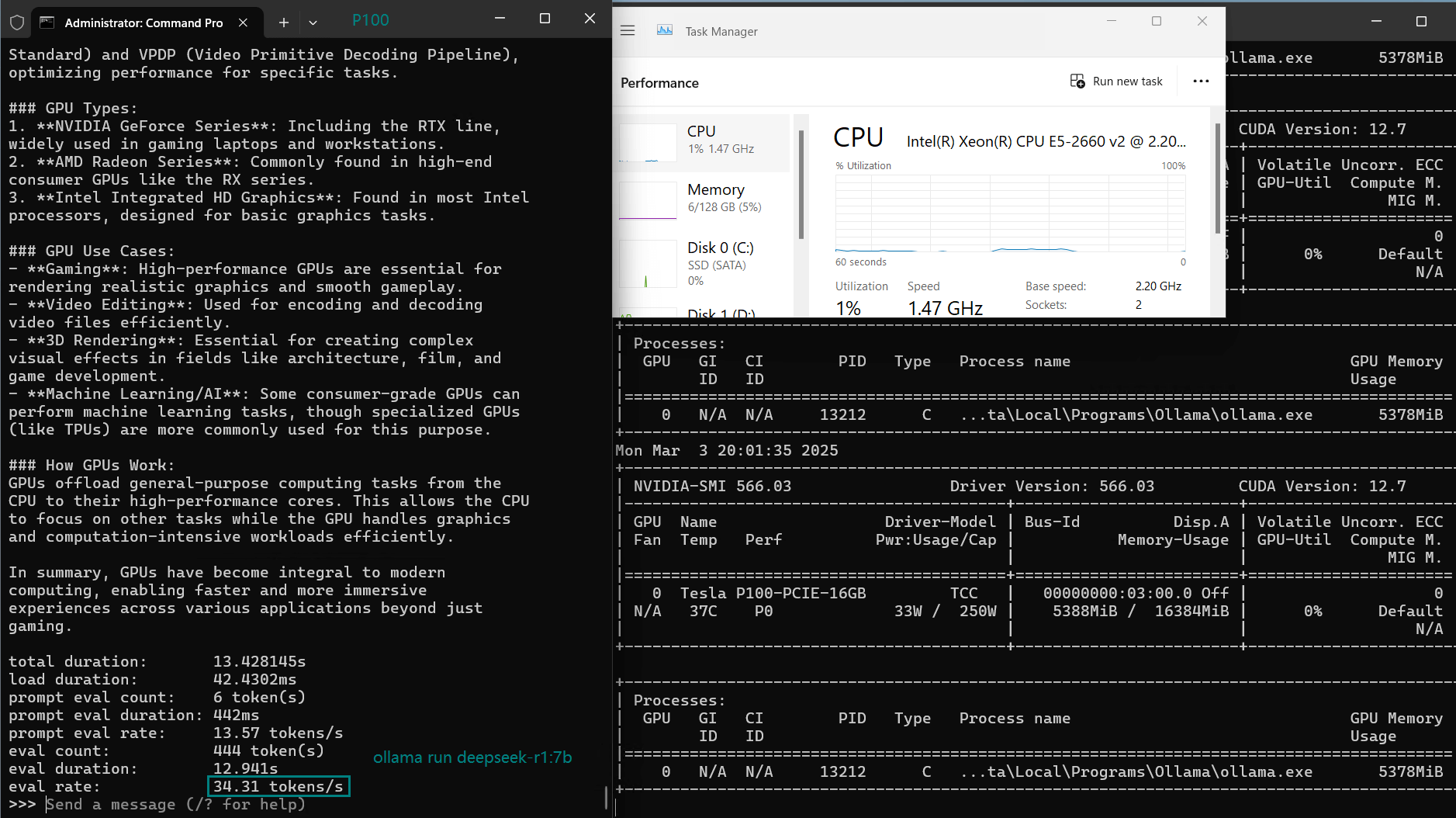

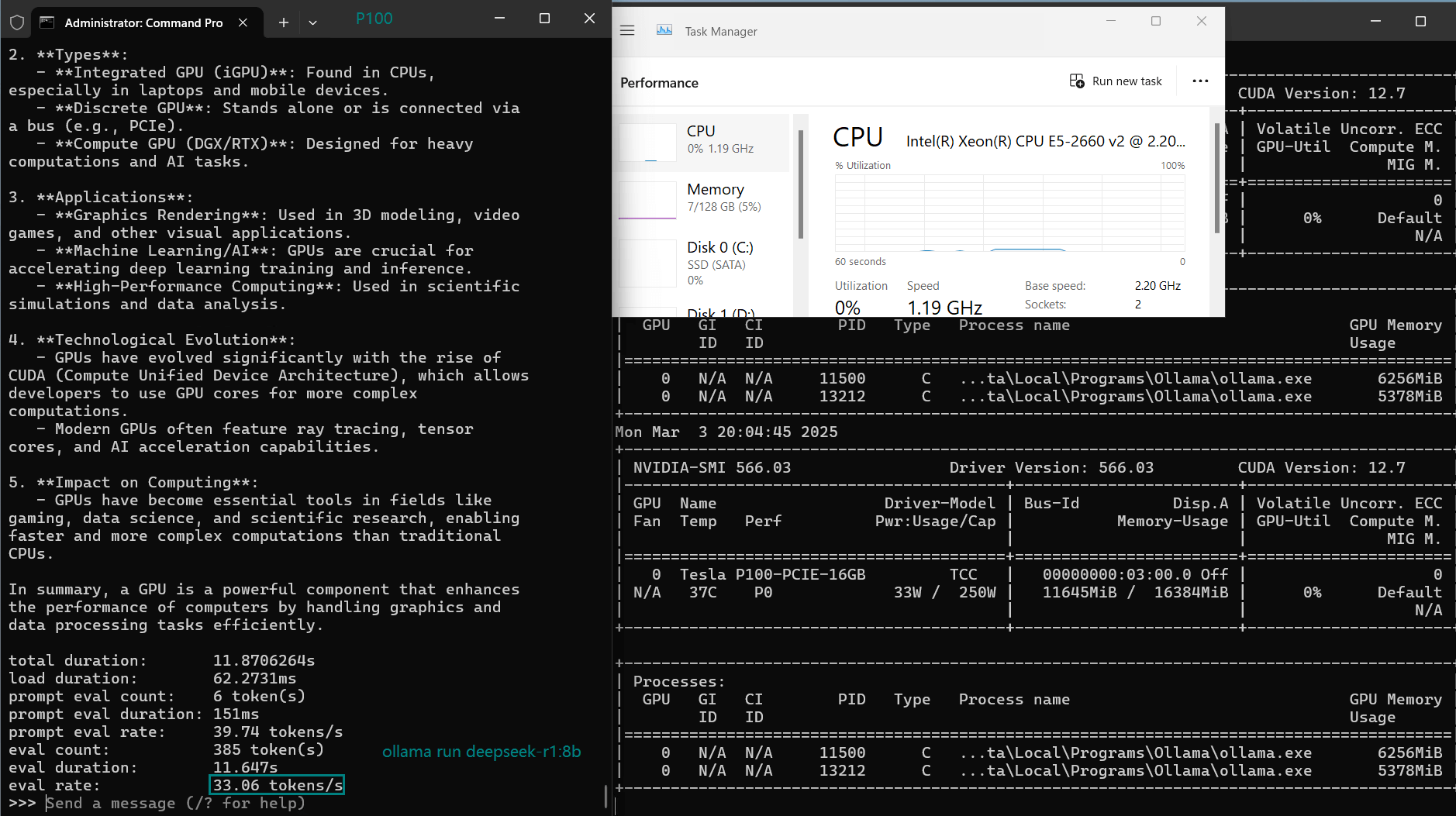

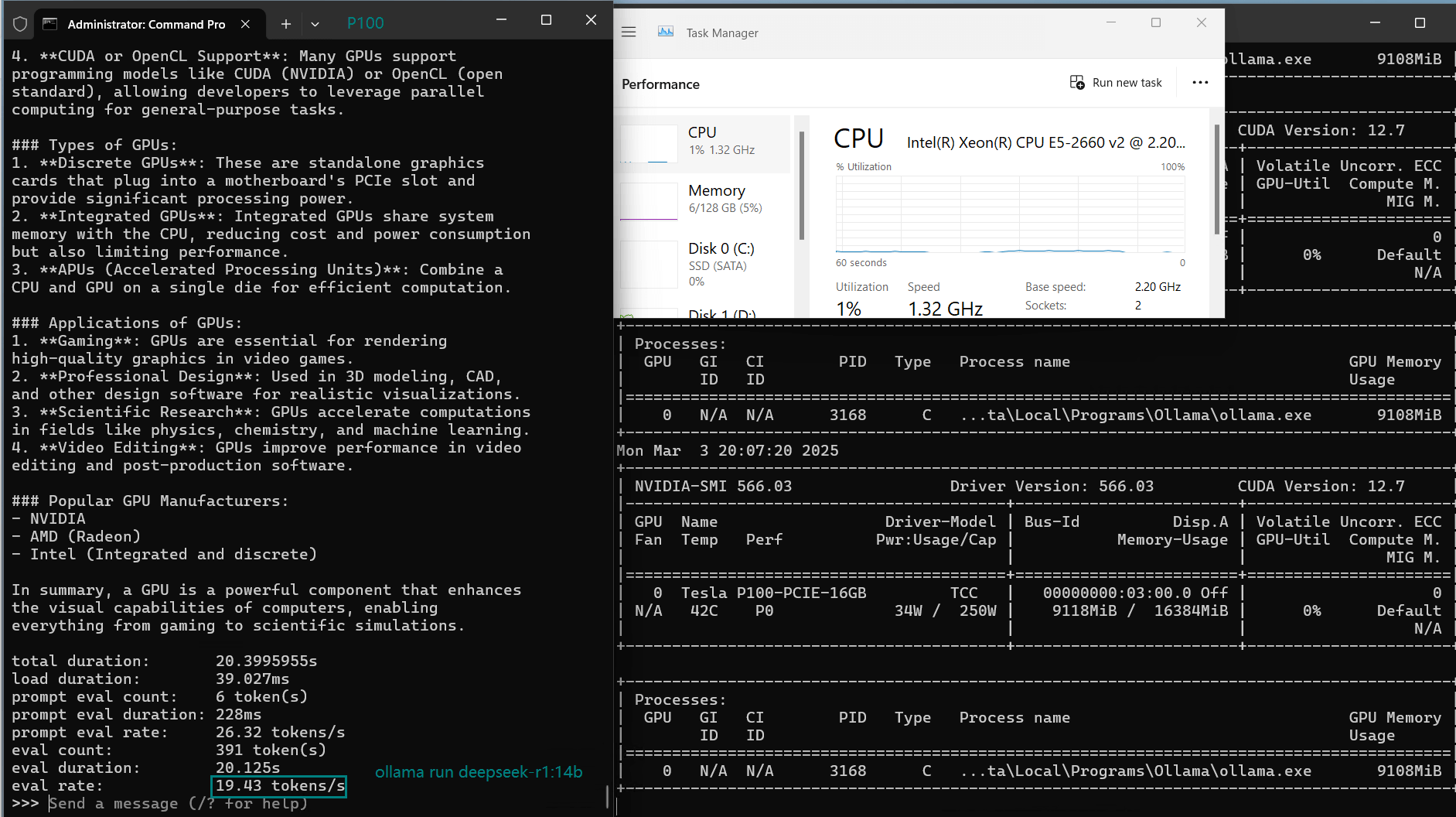

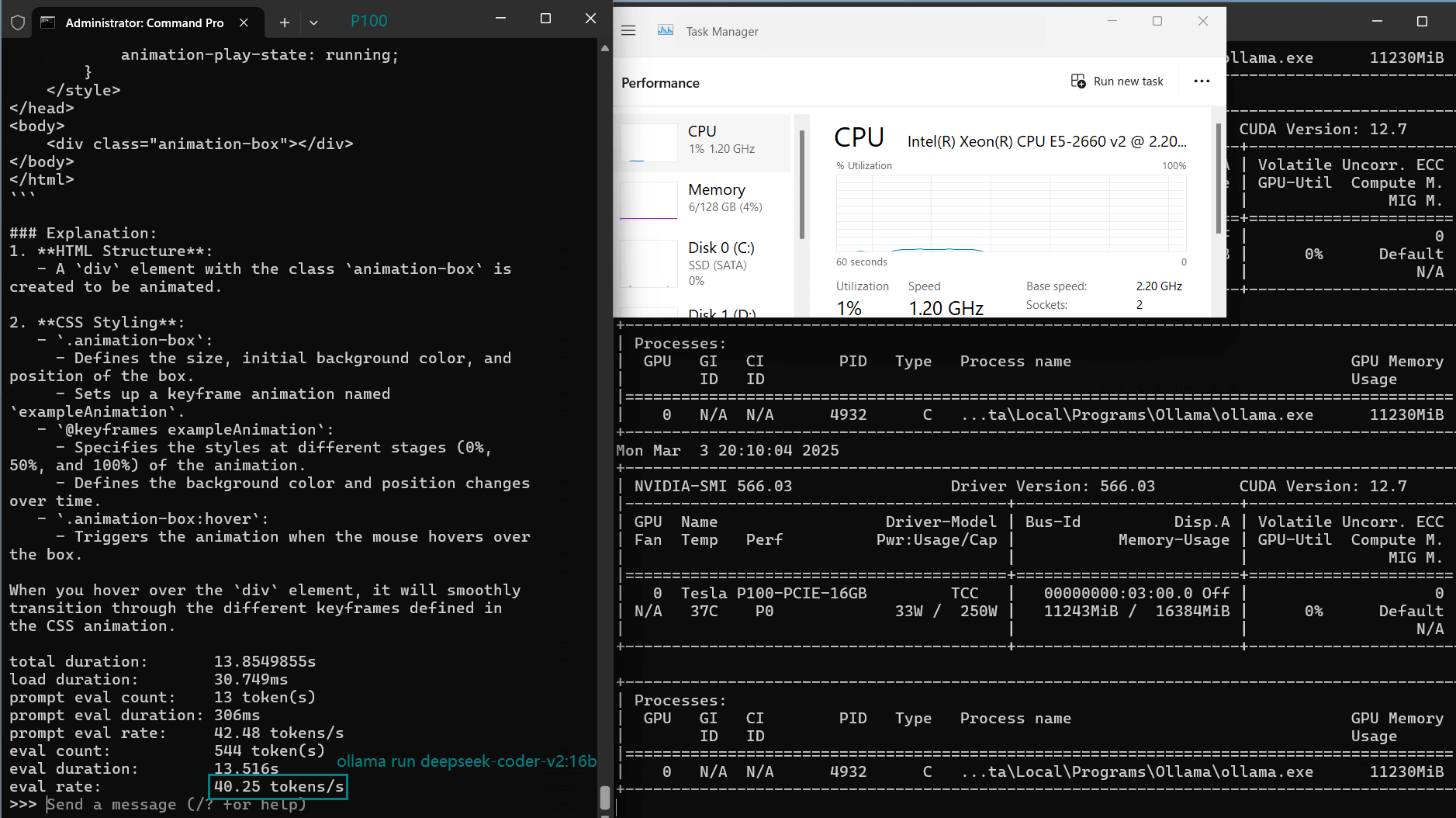

基准测试结果:使用Ollama在Tesla P100上运行大型语言模型

我们在Tesla P100搭配Ollama的平台上测试了各种7B到16B的模型,以下是它们的性能表现:

| 模型 | deepseek-r1 | deepseek-r1 | deepseek-r1 | deepseek-coder-v2 | llama2 | llama2 | llama3.1 | gemma2 | qwen2.5 | qwen2.5 |

|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 7b | 8b | 14b | 16b | 7b | 13b | 8b | 9b | 7b | 14b |

| 大小(GB) | 4.7 | 4.9 | 9 | 8.9 | 3.8 | 7.4 | 4.9 | 5.4 | 4.7 | 9.0 |

| 量化 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 运行 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 | Ollama0.5.11 |

| 下载速度(mb/s) | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 | 12 |

| CPU 速率 | 3% | 3% | 3% | 3% | 4% | 3% | 3% | 3% | 3% | 3% |

| RAM 速率 | 5% | 5% | 5% | 4% | 4% | 4% | 5% | 5% | 5% | 5% |

| GPU UTL | 85% | 89% | 90% | 65% | 91% | 95% | 88% | 81% | 87% | 91% |

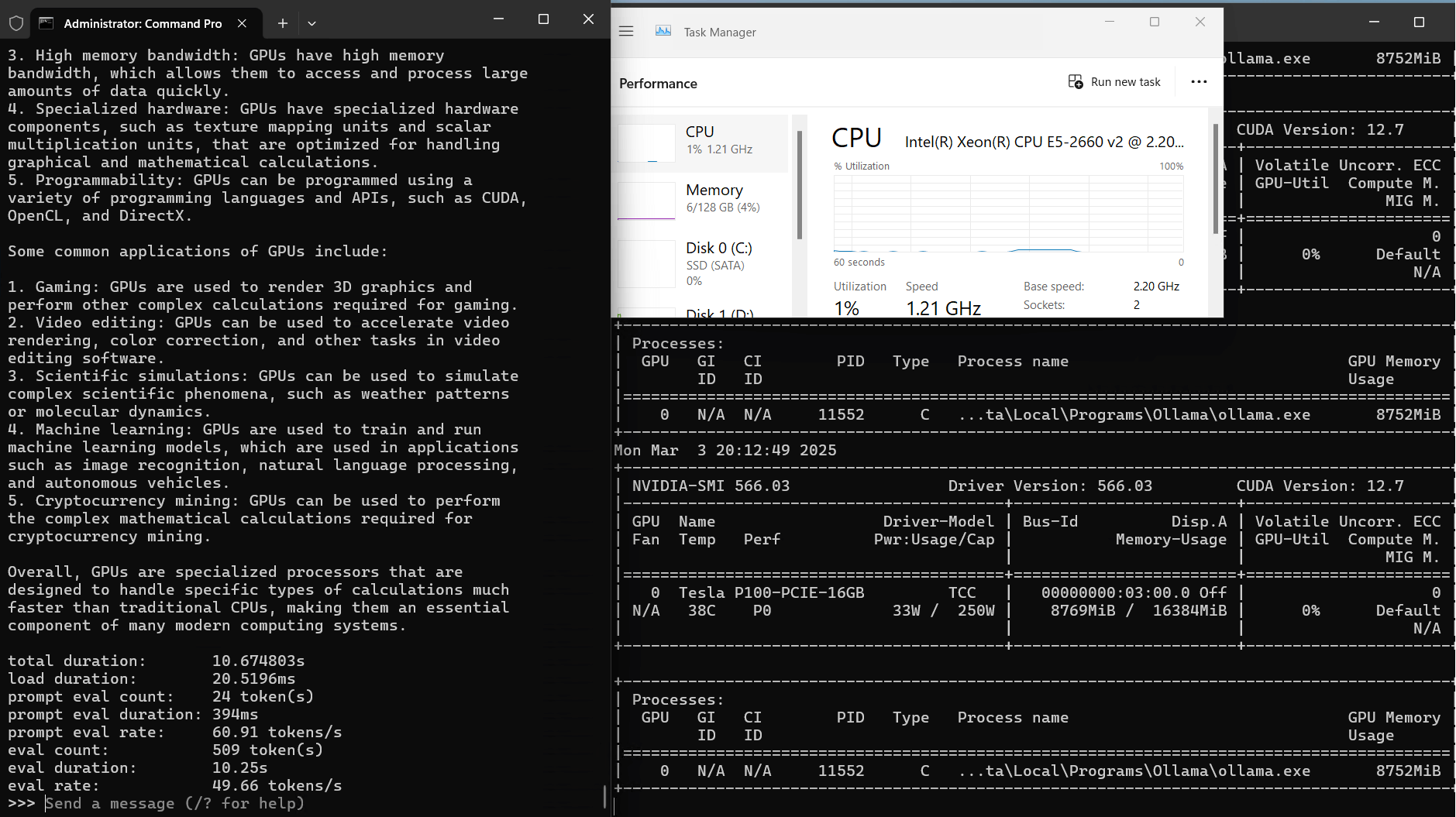

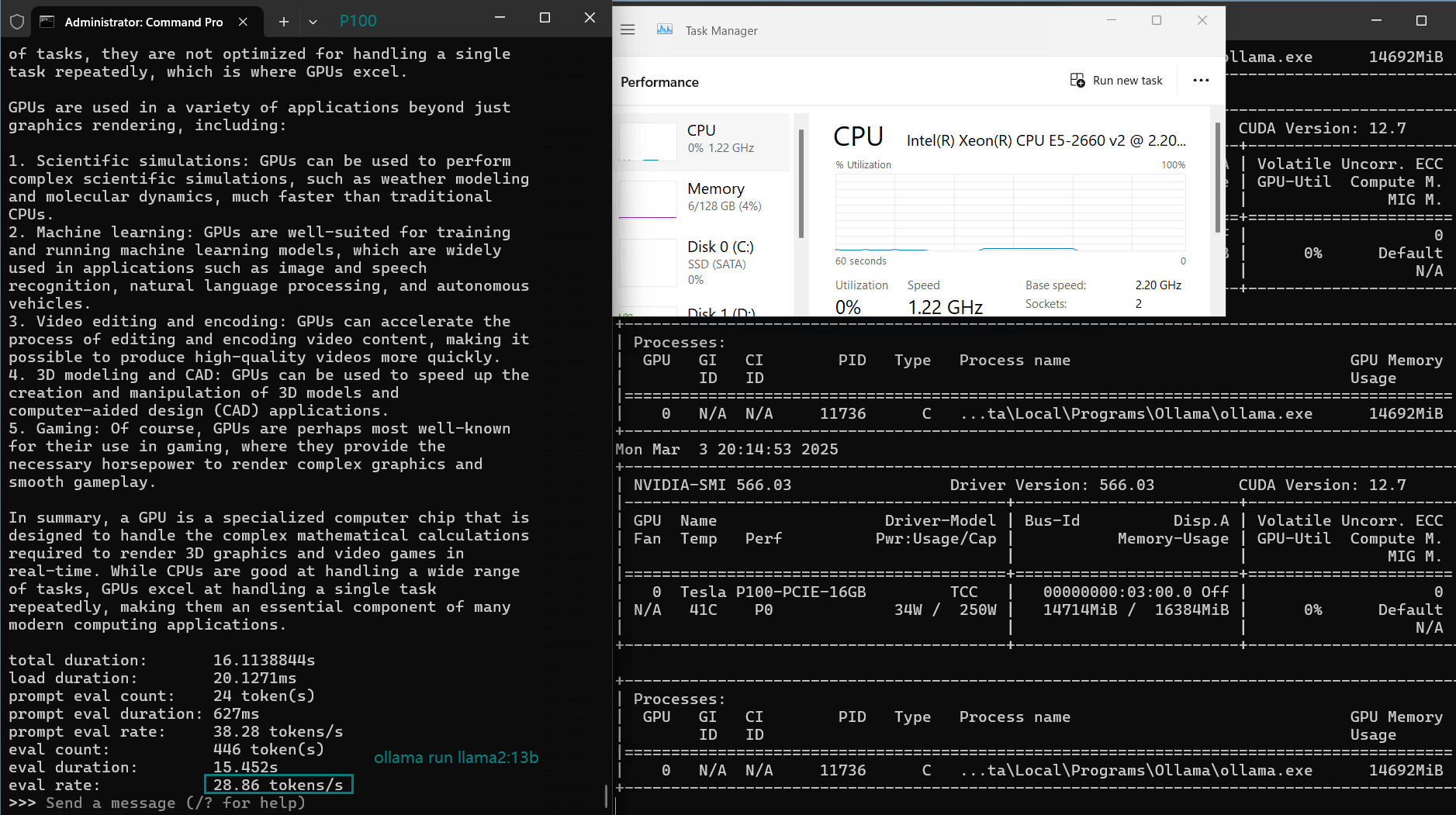

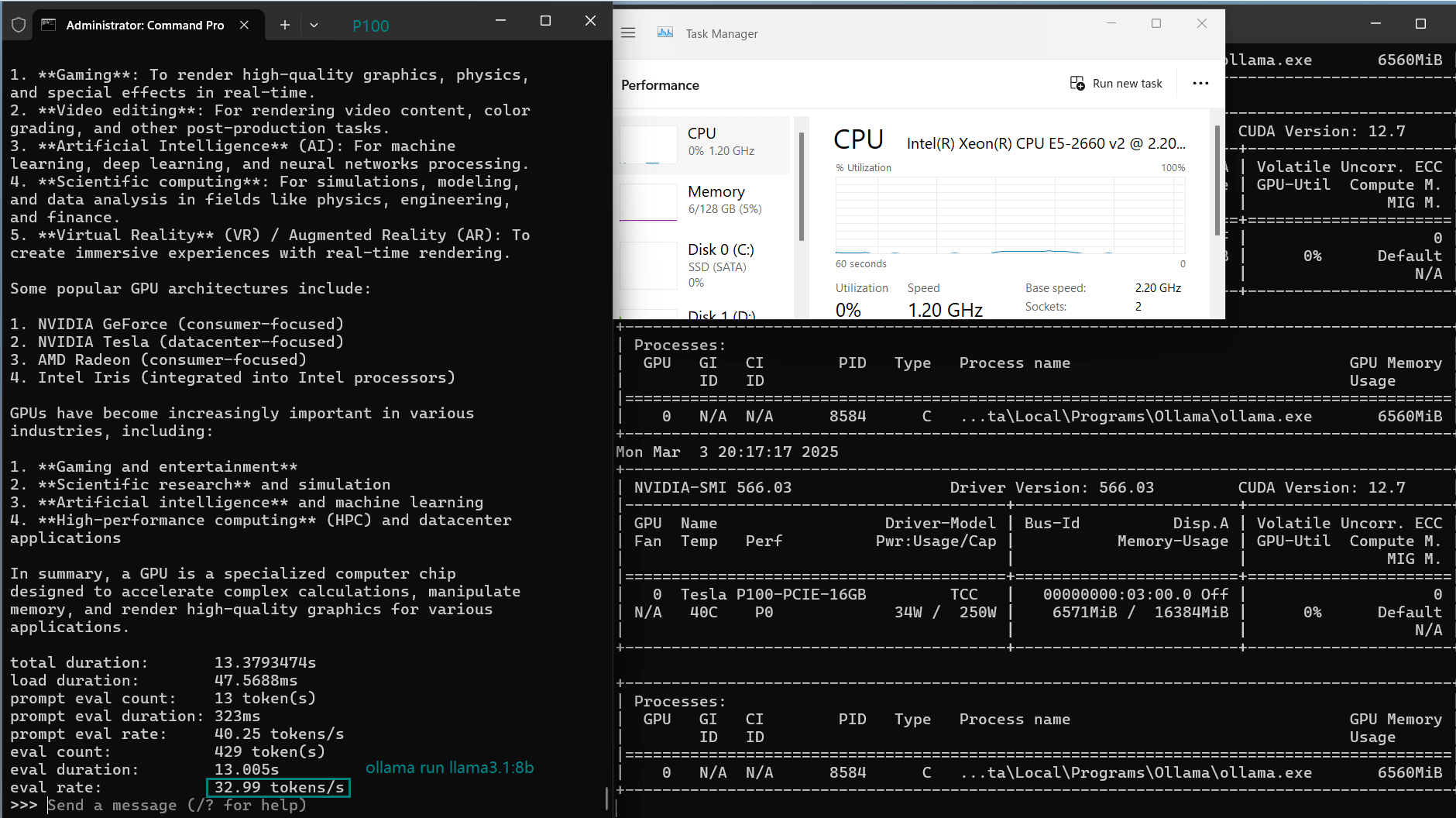

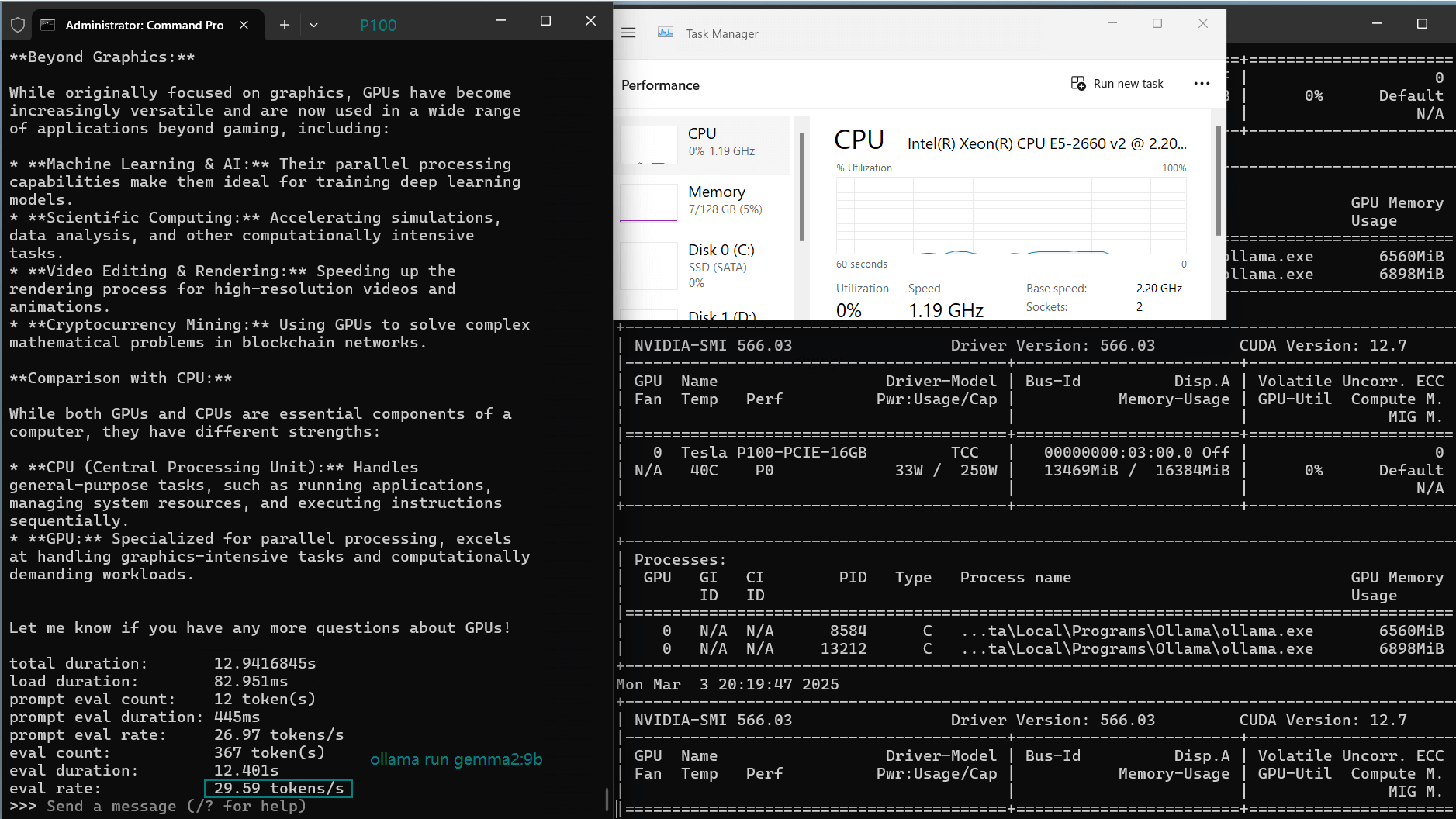

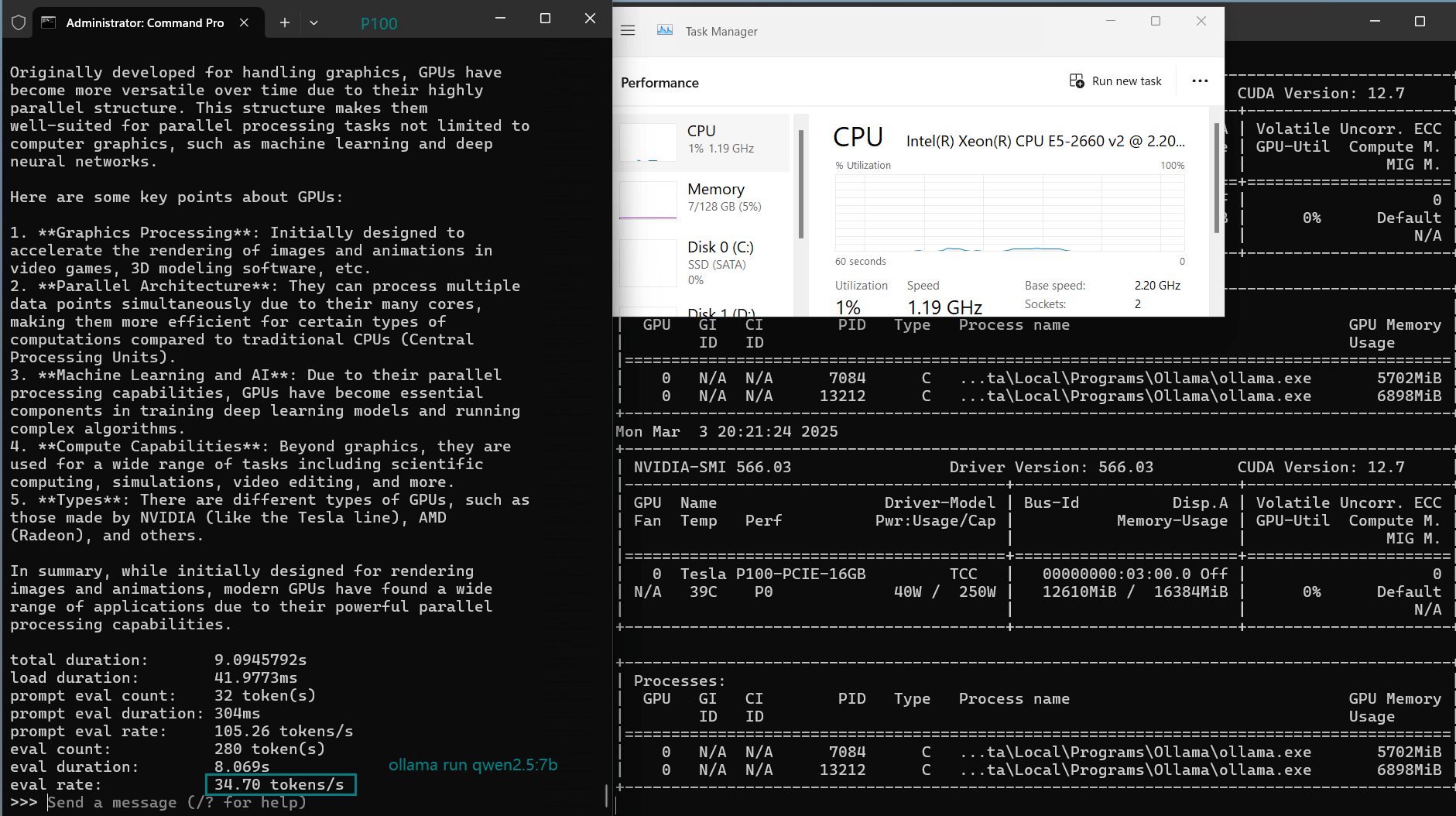

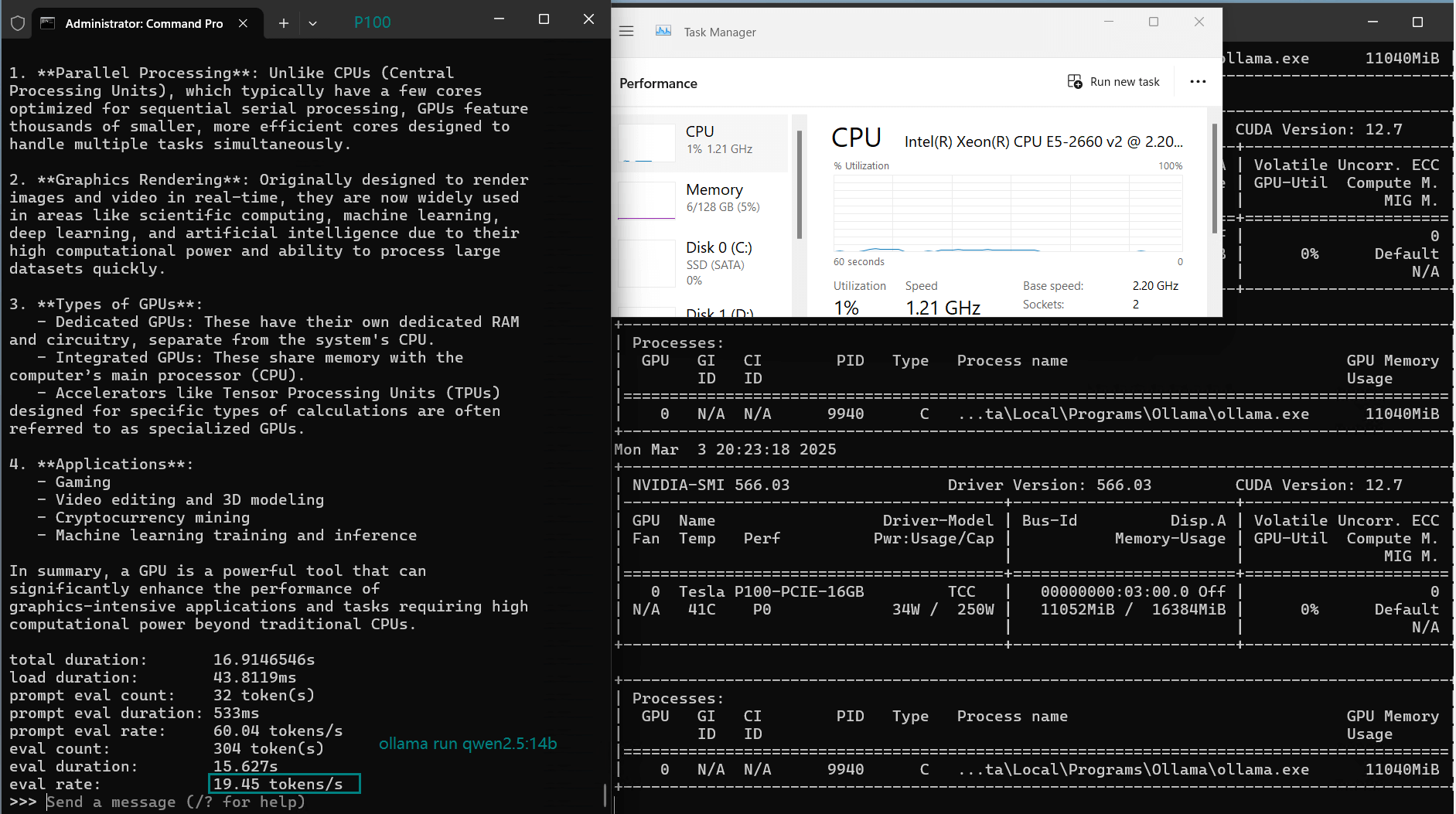

| 评估率(tokens/s) | 34.31 | 33.06 | 19.43 | 40.25 | 49.66 | 28.86 | 32.99 | 29.54 | 34.70 | 19.45 |

一段视频,用于记录P100 GPU的实时资源消耗数据:

使用Nvidia P100 GPU服务器在Ollama平台上对大型语言模型进行性能测试的屏幕截图

基准测试的主要结论

- 7B参数模型的最佳运行环境是Tesla P100搭配Ollama,Llama2-7B的运行速度可达49.66个token/秒。

- 14B及以上参数模型性能有所下降,DeepSeek-r1-14B的运行速度为19.43个token/秒,虽然仍可接受,但速度较慢。

- Qwen2.5和DeepSeek模型性能均衡,7B参数模型的运行速度稳定在33-35个token/秒之间。

- Llama2-13B的运行速度为28.86个token/秒,虽然可以运行,但速度低于7B模型。

- DeepSeek-Coder-v2-16B的性能令人惊喜,超过了14B模型(40.25个token/秒),但GPU利用率较低(65%),表明其效率不高。

Tesla P100适合在Ollama上运行大型语言模型吗?

如果您正在寻找价格实惠的Nvidia P100服务器用于大型语言模型推理,那么Tesla P100对于处理参数量不超过13B的模型来说是一个不错的选择。与RTX2060的Ollama基准测试结果相比,由于其拥有16GB显存,Tesla P100能够更好地处理更大规模的模型,但对于16B级别的模型来说,其性能可能不够理想。

✅ 使用NVIDIA P100运行Ollama的优缺点

- 能够高效运行7B-13B规模的模型

- 价格低于A4000或V100

- 处理7B+规模的大型语言模型时性能优于RTX2060

❌ 为 Ollama 提供的 NVIDIA P100 替代方案

- 难以处理16B+规模的模型

- 较旧的Pascal架构没有张量核心

如果您需要价格实惠的大型语言模型托管服务,那么以每月159-199美元的价格租用Tesla P100 GPU用于Ollama推理,对于小型到中型AI模型来说,性价比非常高。

开始使用Tesla P100服务器运行3-16B规模的大型语言模型

对于在Ollama平台上部署大型语言模型(LLM)的用户来说,选择合适的NVIDIA Tesla P100服务器解决方案对性能和成本有着显著的影响。如果您使用的模型参数规模在30亿到160亿之间,那么P100以其较高的性价比,是进行AI推理的理想选择。

GPU云服务器 - A4000

¥ 1109.00/月

月付季付年付两年付

立即订购- 配置: 24核32GB, 独立IP

- 存储: 320GB SSD系统盘

- 带宽: 300Mbps 不限流

- 赠送: 每2周一次自动备份

- 系统: Win10/Linux

- 其他: 1个独立IP

- 独显: Nvidia RTX A4000

- 显存: 16GB GDDR6

- CUDA核心: 6144

- 单精度浮点: 19.2 TFLOPS

GPU物理服务器 - P100

¥ 1239.00/月

月付季付年付两年付

立即订购- CPU: 16核E5-2660*2

- 内存: 128GB DDR3

- 系统盘: 120GB SSD

- 数据盘: 960GB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia Tesla P100

- 显存: 16GB GDDR6

- CUDA核心: 3584

- 单精度浮点: 9.5 TFLOPS

GPU物理服务器 - V100

¥ 1849.00/月

月付季付年付两年付

立即订购- CPU: 24核E5-2690v3*2

- 内存: 128GB DDR4

- 系统盘: 240GB SSD

- 数据盘: 2TB SSD

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia V100

- 显存: 16GB HBM2

- CUDA核心: 5120

- 单精度浮点: 14 TFLOPS

最终总结:在Ollama平台上,适合Tesla P100的最佳模型有哪些?

对于使用Nvidia P100云服务器的用户,在Ollama平台上进行小型AI推理时,推荐使用以下模型:

- Llama2-7B(速度最快:49.66 词元/秒)

- DeepSeek-r1-7B(性能均衡:34.31 词元/秒)

- Qwen2.5-7B(强劲的替代方案:34.70 词元/秒)

- DeepSeek-Coder-v2-16B(最佳大型模型:40.25 词元/秒)

为了获得最佳性能,建议使用参数规模在70亿到130亿之间的模型。如果您需要处理更大的语言模型推理任务,可以考虑升级到A4000或V100显卡。您想了解更多关于Ollama在Tesla P100和V100显卡上的性能对比测试吗?欢迎在评论区留言!

标签:

Ollama P100,Tesla P100大语言模型,Ollama与Tesla P100,Nvidia P100服务器托管,P100性能测试,Ollama性能测试,P100用于7B-14B大语言模型推理,Nvidia P100租赁,Tesla P100性能,Ollama大语言模型,DeepSeek-R1 P100,Llama2 P100性能测试,Qwen2.5 Tesla P100,Nvidia P100 AI推理