测试环境与配置

服务器配置:

- CPU:双18核E5-2697v4(36核,72线程)

- 内存:256GB

- 存储:240GB SSD + 2TB NVMe + 8TB SATA

- 网络:100Mbps-1Gbps连接

- 操作系统:Windows 11 Pro

GPU详细信息:

- 显卡:Nvidia A40

- 计算能力:8.6

- 微架构:Ampere

- CUDA核心:10,752

- 张量核心:336

- GPU内存:48GB GDDR6

- FP32 性能:37.48 TFLOPS

超大显存(48GB)确保 A40 服务器能够运行 70B 参数模型。

在 Ollama 平台上使用 A40 测试大型语言模型的推理能力

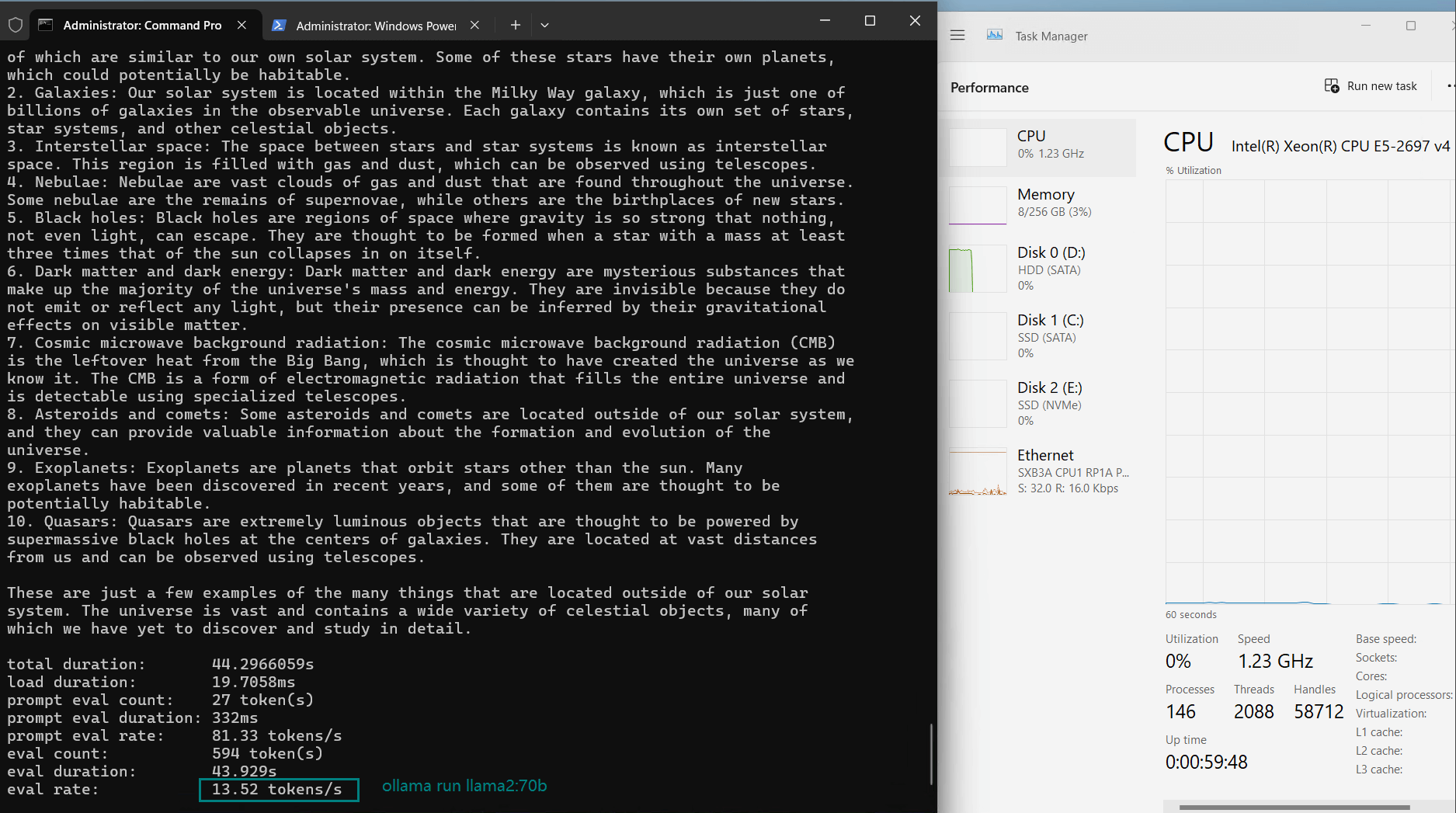

- Llama2 (70B)

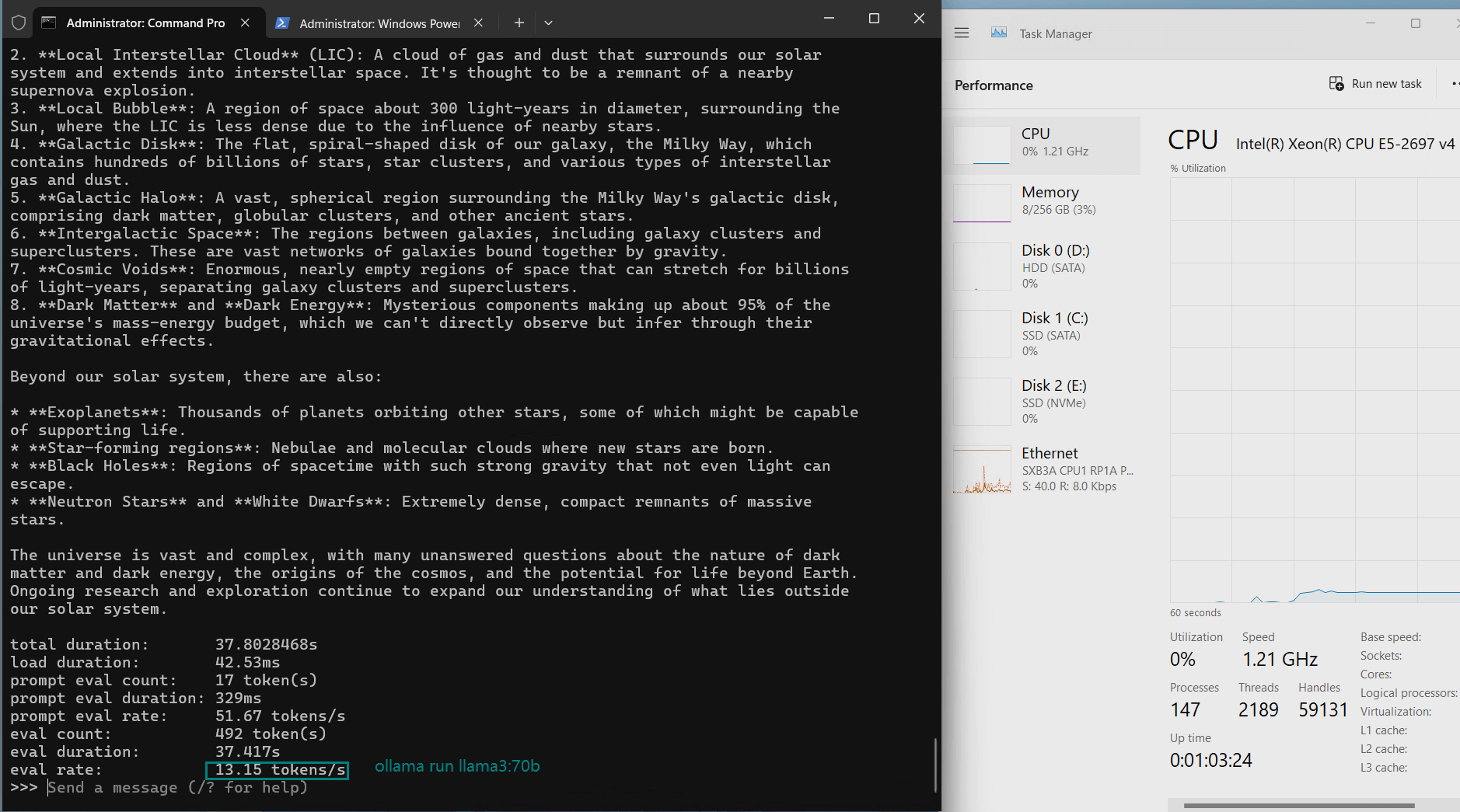

- Llama3 (70B)

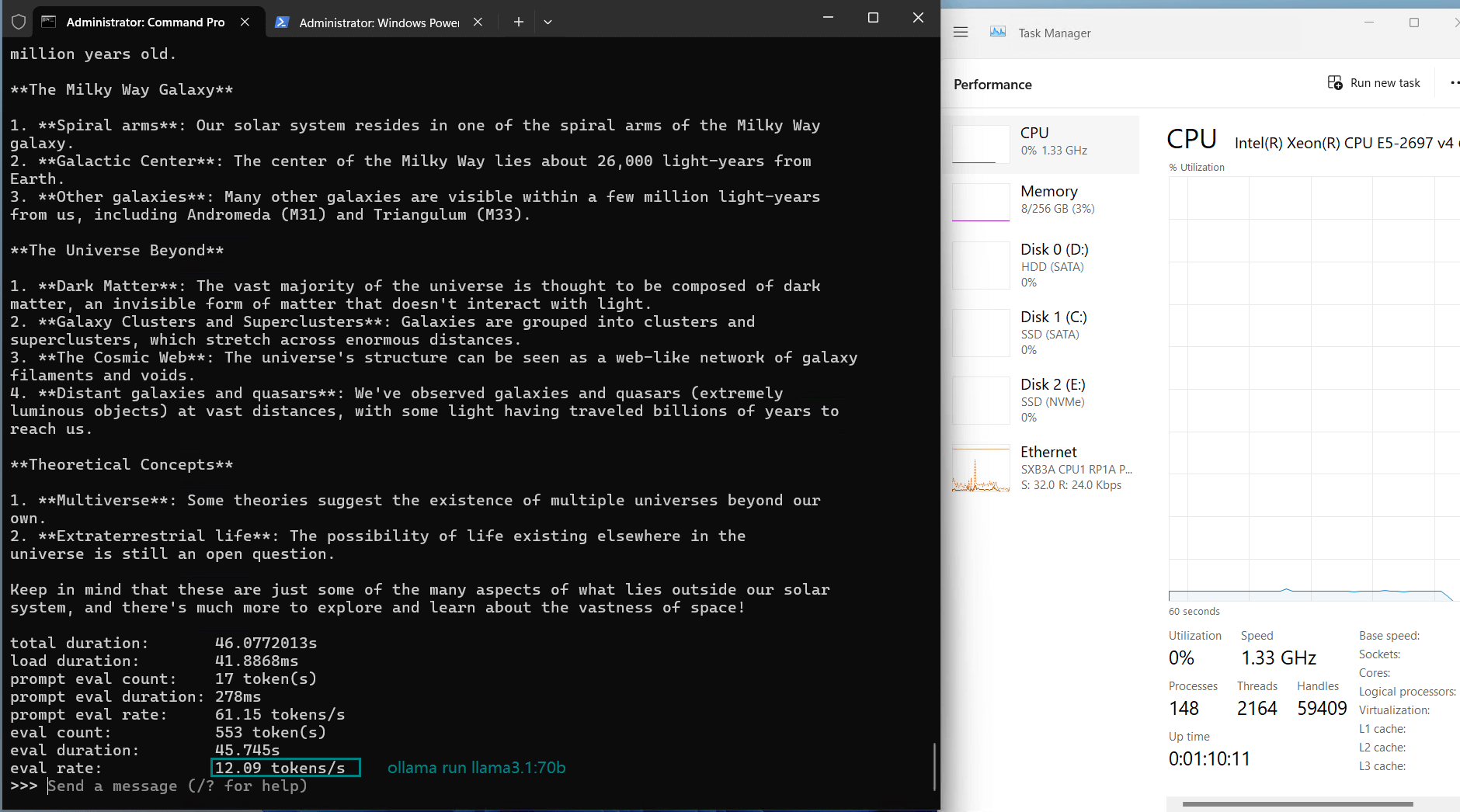

- Llama3.1 (70B)

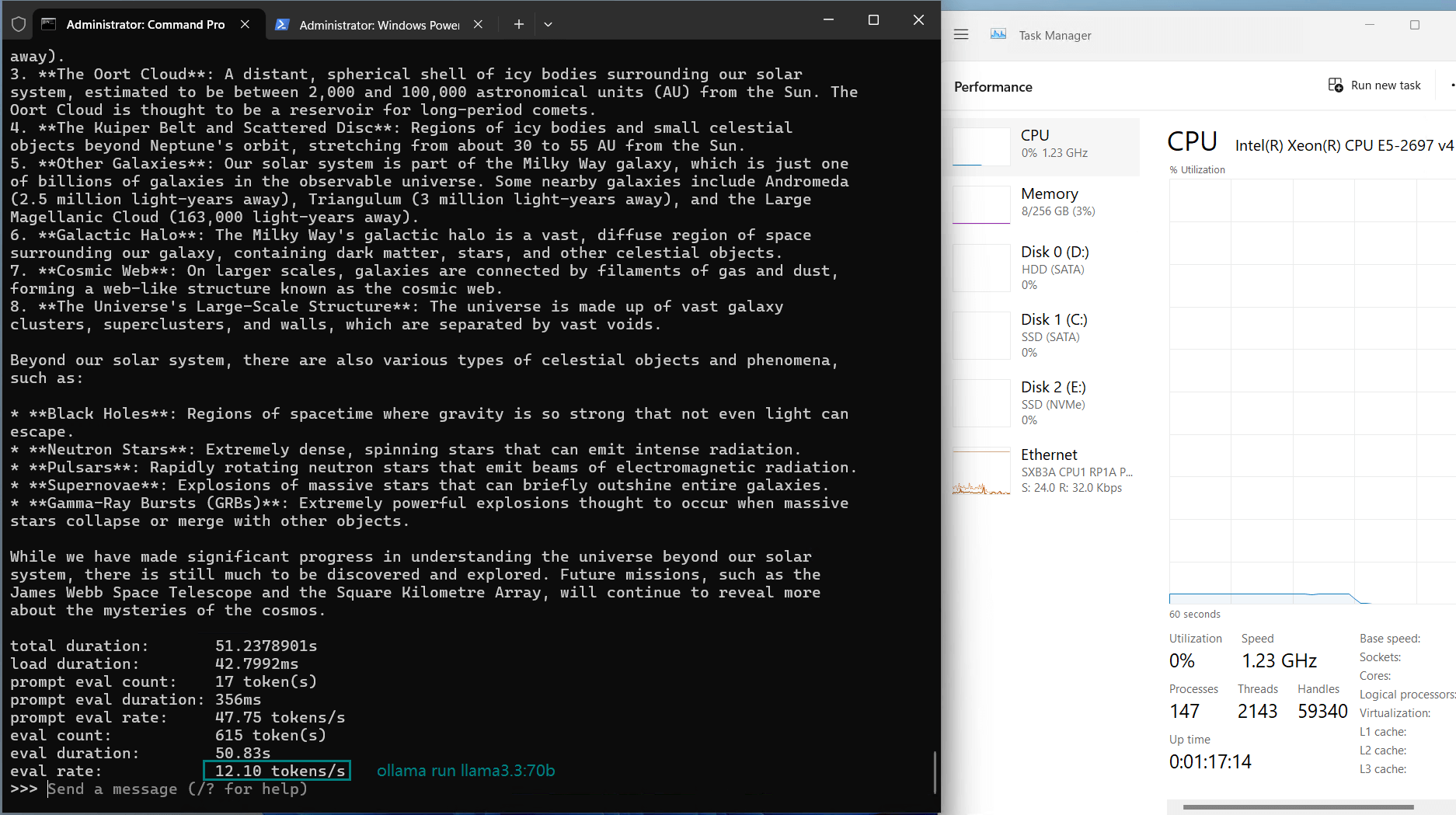

- Llama3.3 (70B)

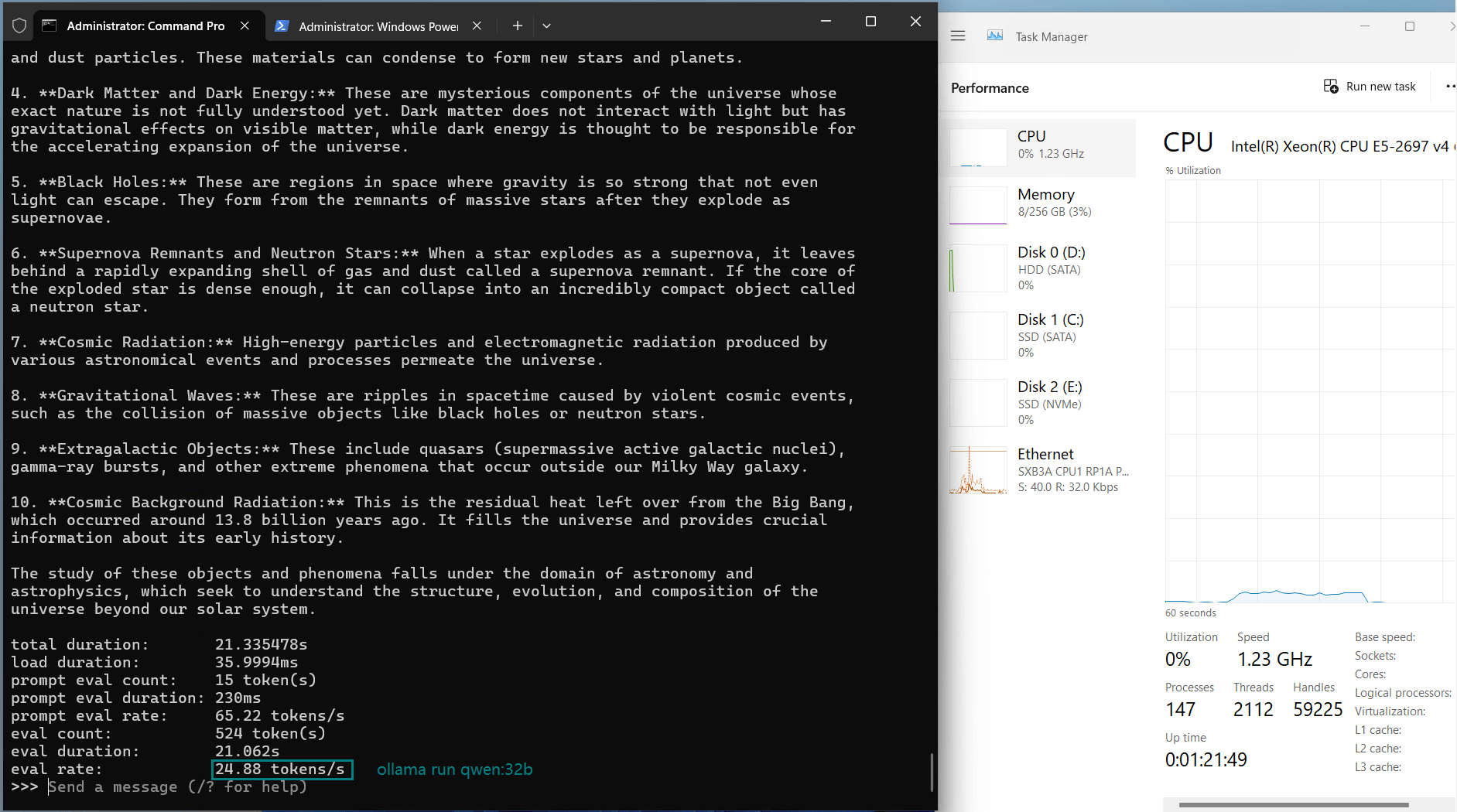

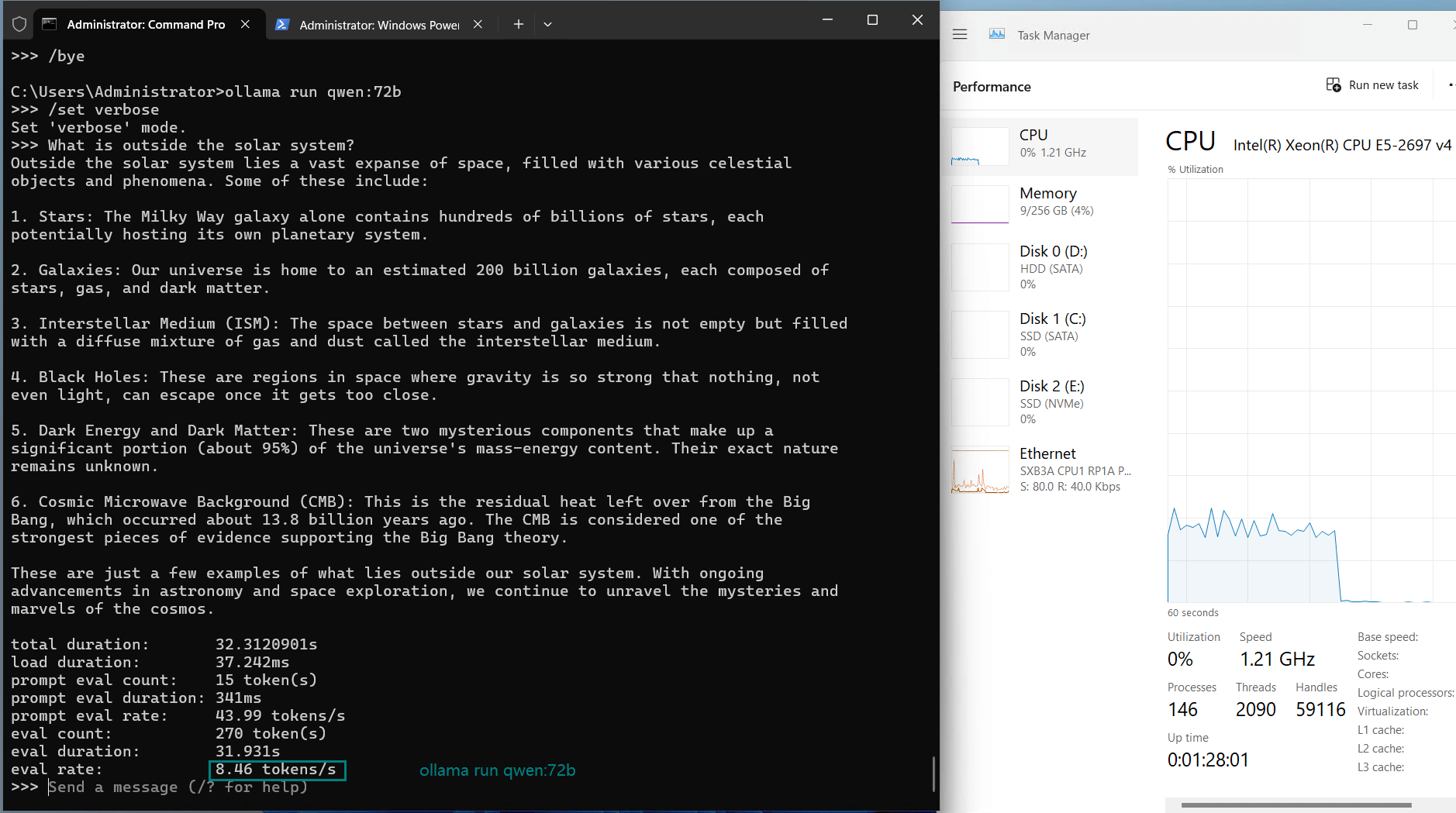

- Qwen (32B, 72B)

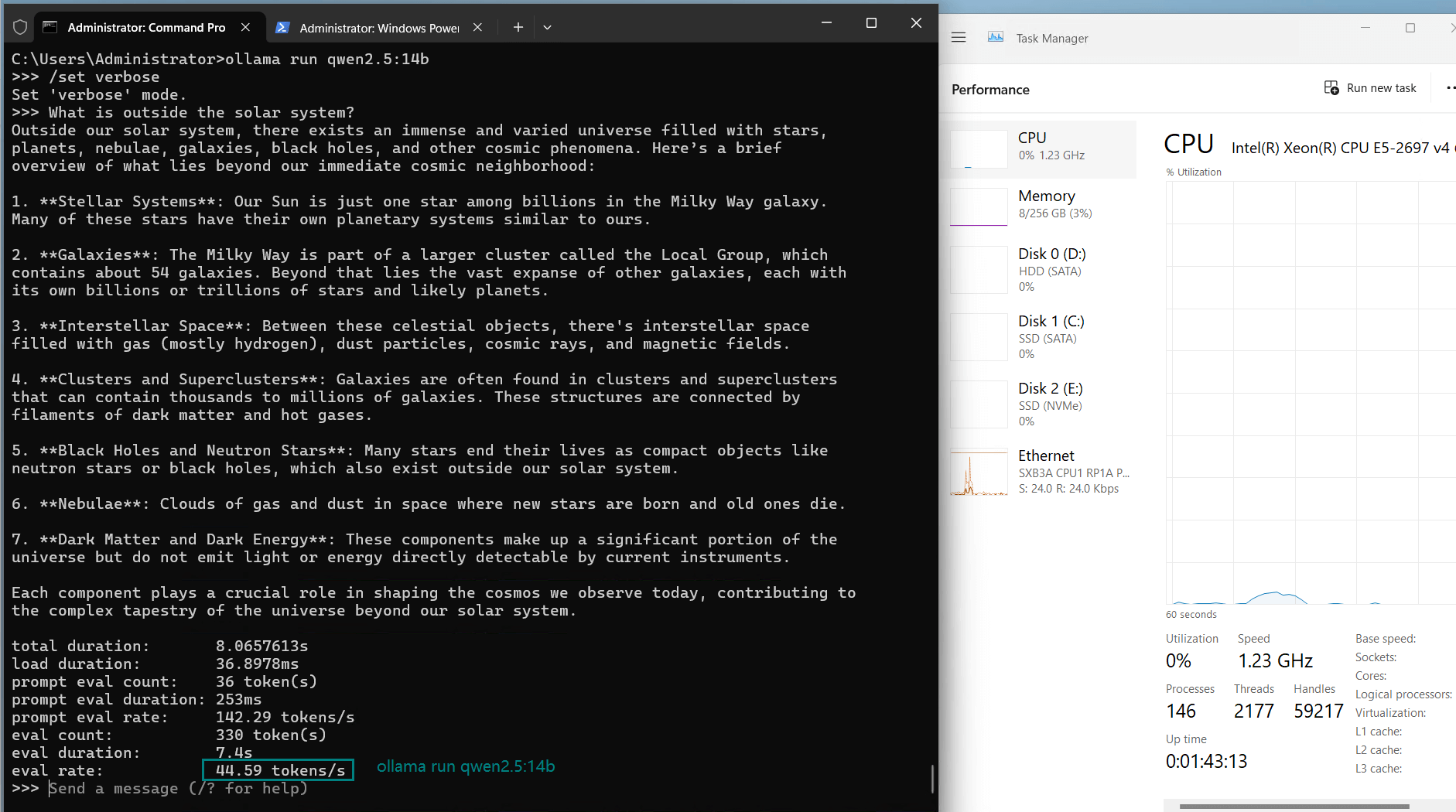

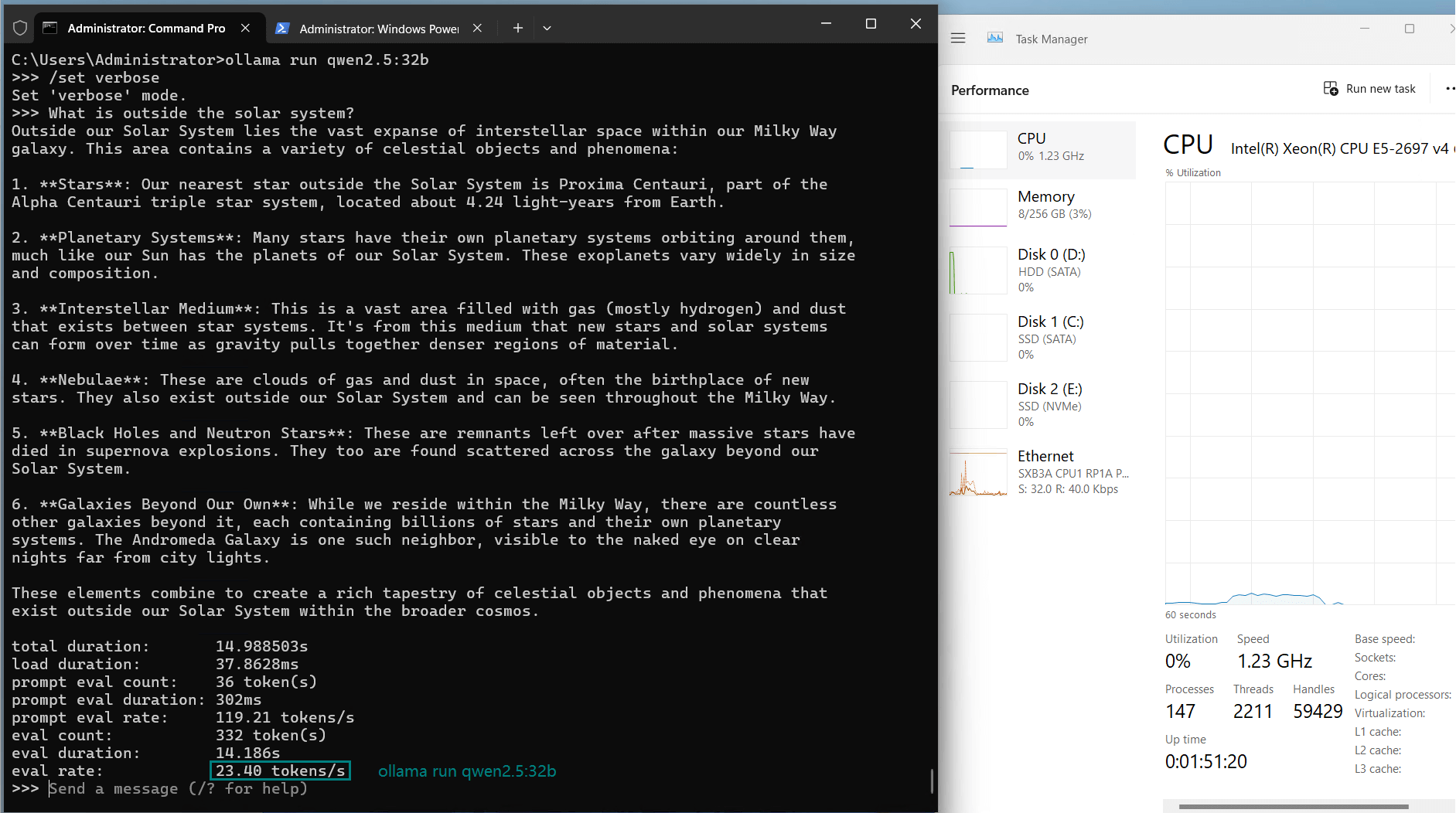

- Qwen2.5 (14B, 32B, 72B)

- Gemma2 (27B)

- Llava (34B)

- QWQ (32B)

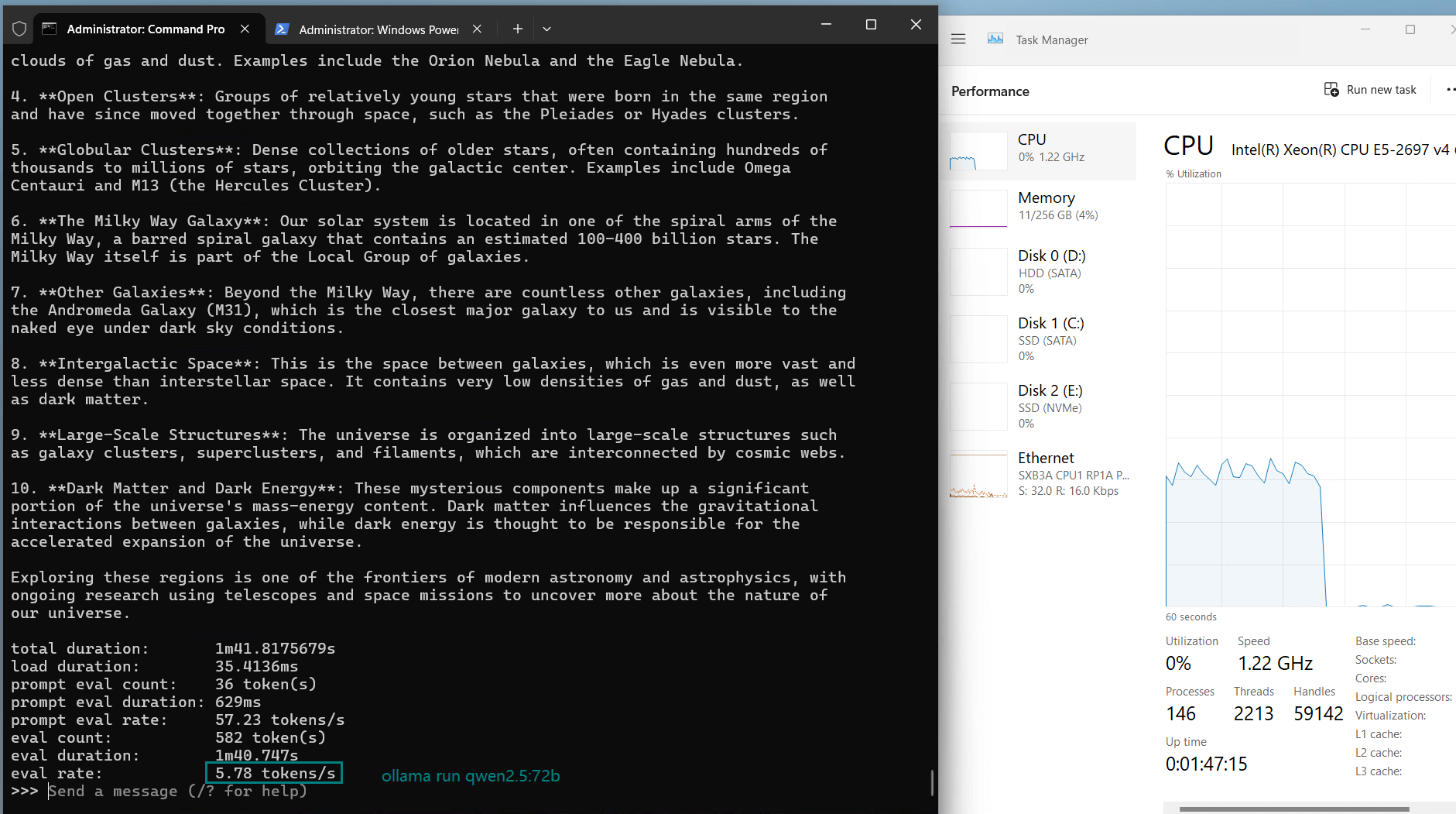

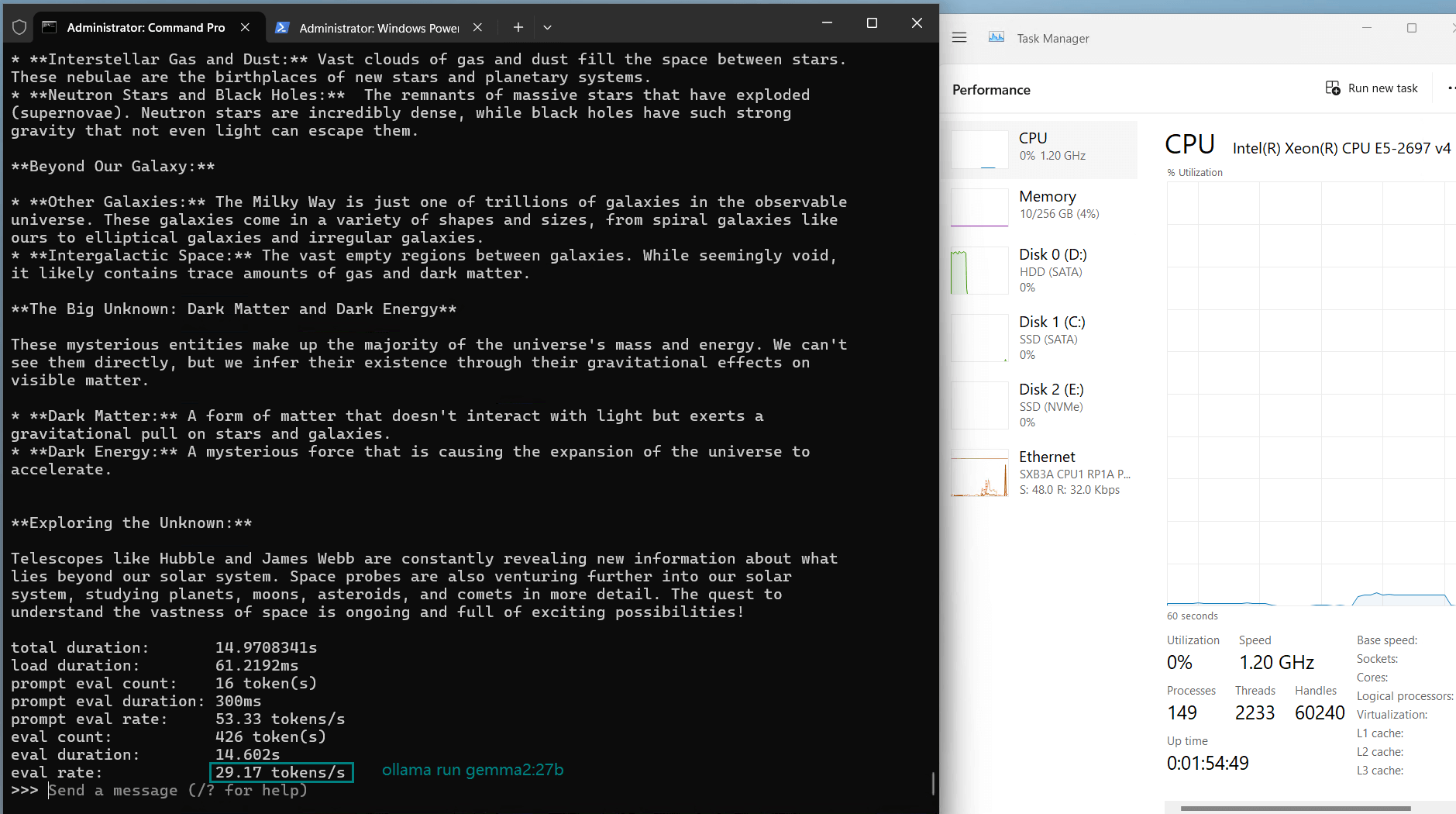

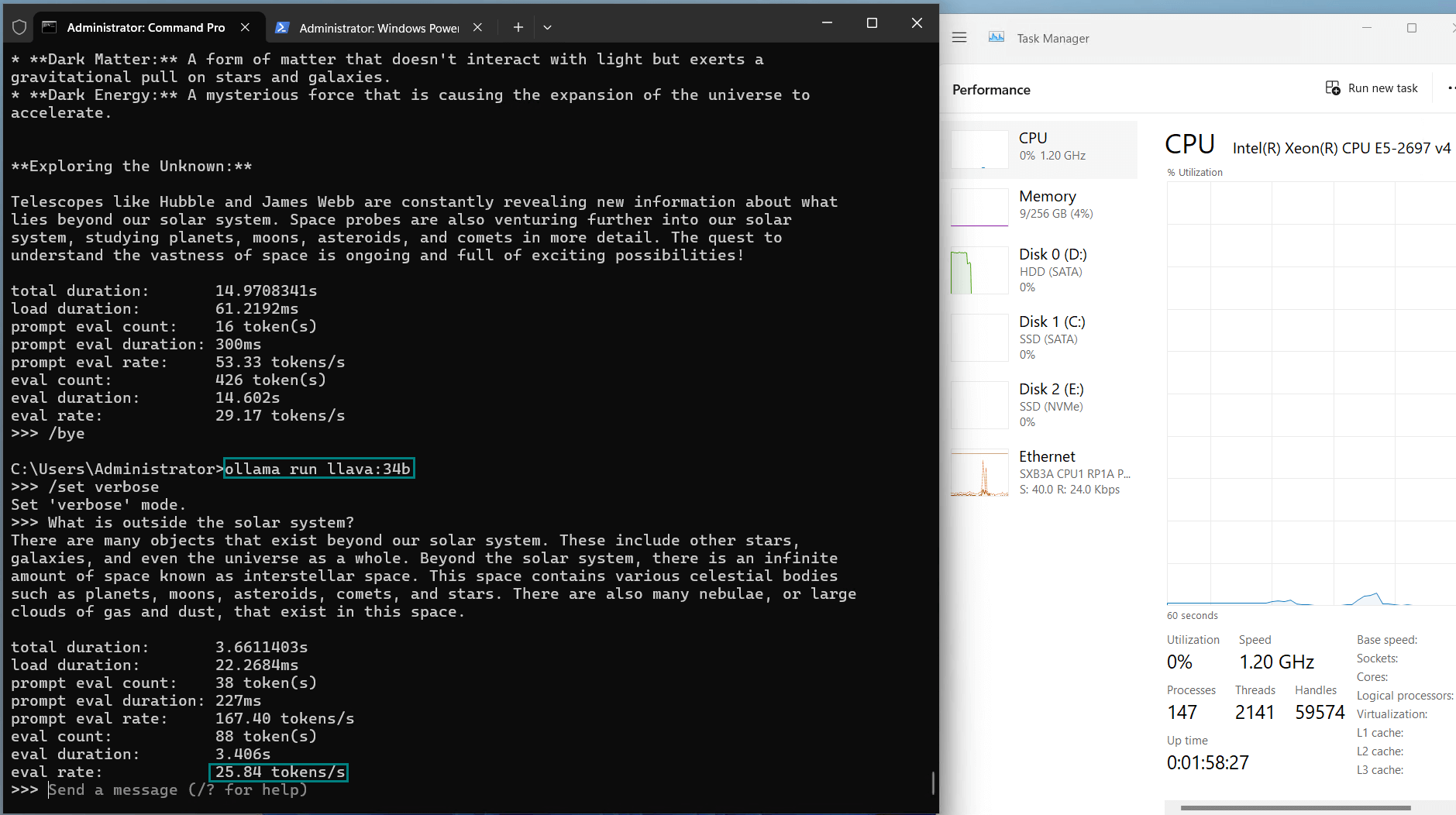

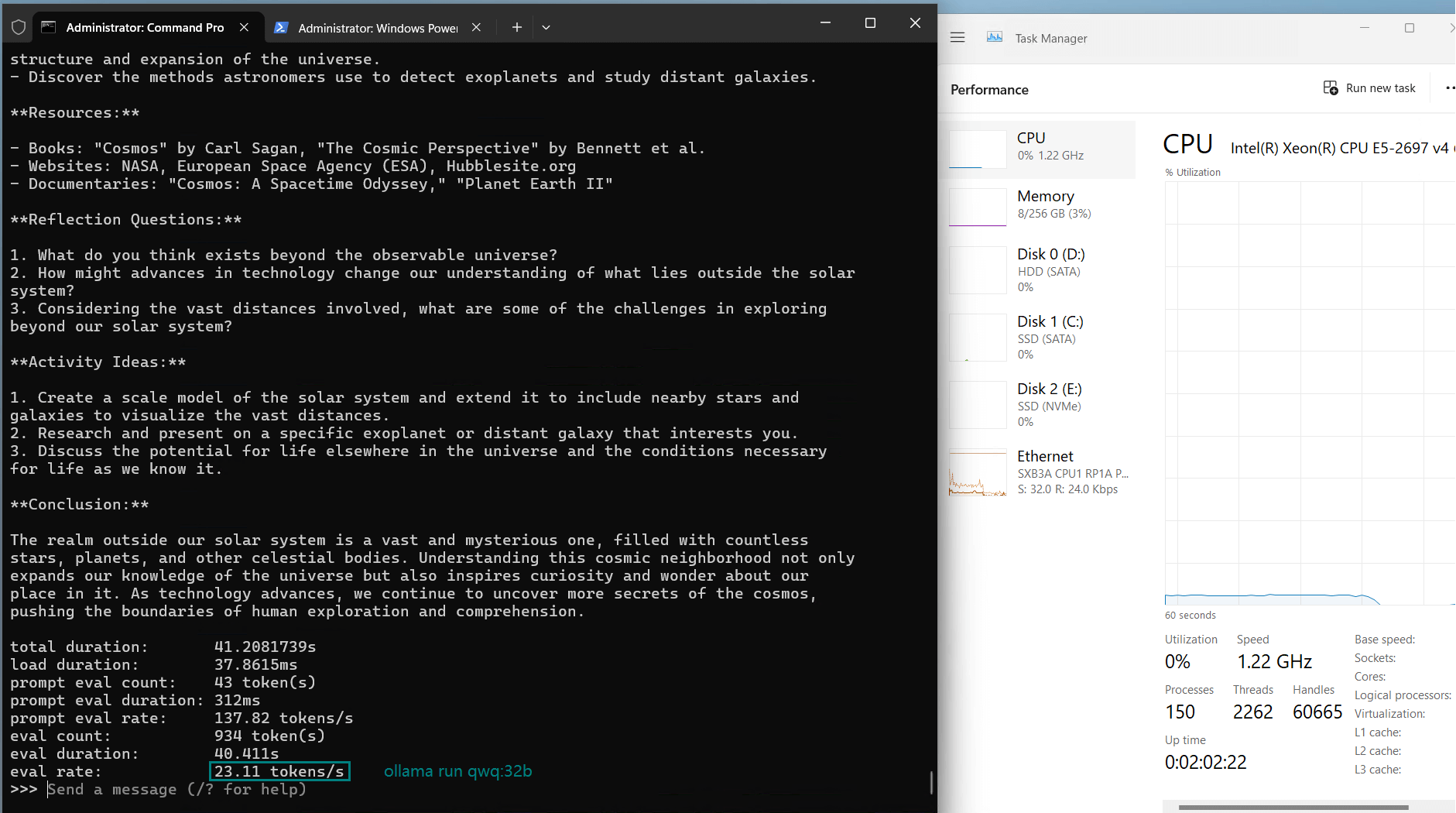

基准测试结果:Ollama GPU A40 性能指标

| 模型 | llama2 | llama3 | llama3.1 | llama3.3 | qwen | qwen | qwen2.5 | qwen2.5 | qwen2.5 | gemma2 | llava | qwq |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 参数 | 70b | 70b | 70b | 70b | 32b | 72b | 14b | 32b | 72b | 27b | 34b | 32b |

| 大小 | 39GB | 40GB | 43GB | 43GB | 18GB | 41GB | 9GB | 20GB | 47GB | 16GB | 19GB | 20GB |

| 量化 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 | 4 |

| 正在运行 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 | Ollama0.5.4 |

| 下载速度(mb/s) | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 | 11 |

| CPU 速率 | 2% | 2% | 3% | 2% | 3% | 17-22% | 2% | 2% | 30-40% | 3% | 3% | 2% |

| 内存速率 | 3% | 3% | 3% | 3% | 3% | 3% | 3% | 3% | 3% | 3% | 3% | 4% |

| GPU 执行时间 | 98% | 94% | 94% | 94% | 90% | 66% | 83% | 92% | 42-50% | 89% | 94% | 90% |

| 评估率(令牌/秒) | 13.52 | 13.15 | 12.09 | 12.10 | 24.88 | 8.46 | 44.59 | 23.04 | 5.78 | 29.17 | 25.84 | 23.11 |

关键见解

1. A40 处理能力上限

2. 中型模型(32B-34B)的性能表现

- GPU 利用率:稳定在 90%-94%

- 推理速度:23-26 tokens/s

3. 小型模型的高效运行

- GPU 利用率:42%-83%

- 推理速度:44.59 tokens/s

Nvidia A40 的优势

1. 高效的内存管理

2. 高推理性能

3. 多场景适应性

限制与建议

1. 对超大模型支持有限

2. 网络瓶颈

对比:Nvidia A40 与 A6000

Nvidia A40 和 Nvidia A6000 都配备了 48GB 显存,使其能够运行参数量高达 700 亿的模型,并具有相似的性能。在实际应用中,这两款 GPU 在处理像 LLaMA2:70B 这样的模型任务时几乎可以互换,其推理速度和 GPU 利用率的差异非常小。

然而,对于参数量超过 720 亿的模型,无论是 A40 还是 A6000 都无法保持足够的推理速度或稳定性。对于此类超大模型,强烈推荐使用显存更高的 GPU,例如 A100 80GB 或 H100。这些 GPU 提供显著更高的内存带宽和计算能力,能够确保下一代大型语言模型的流畅运行。

A100 80GB 在同时托管多个大型模型时尤其具有成本效益,而 H100 则代表了 AI 工作负载的性能巅峰,非常适合前沿研究和生产环境。

GPU物理服务器 - A40

- CPU: 36核E5-2697v4*2

- 内存: 256GB DDR4

- 系统盘: 240GB SSD

- 数据盘: 2TB NVMe + 8TB SATA

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia A40

- 显存: 48GB GDDR6

- CUDA核心: 10752

- 单精度浮点: 37.48 TFLOPS

GPU物理服务器 - A6000

- CPU: 36核E5-2697v4*2

- 内存: 256GB DDR4

- 系统盘: 240GB SSD

- 数据盘: 2TB NVMe + 8TB SATA

- 系统: Win10/Linux

- 其他: 独立IP,100M-1G带宽

- 独显: Nvidia RTX A6000

- 显存: 48GB GDDR6

- CUDA核心: 10752

- 单精度浮点: 38.71 TFLOPS

结论:Nvidia A40 在大型语言模型中的表现如何?

总体而言,Nvidia A40 是一款性价比极高的 GPU,尤其适用于中型和小型大型语言模型的推理任务。其 48GB 显存能够稳定支持参数量高达 700 亿的模型,推理速度可达 13 tokens/s,而对于参数量 32B-34B 的模型,其表现更佳。

如果您正在寻找用于托管 LLM 的 GPU 服务器,Nvidia A40 是一个非常有竞争力的选择。它以合理的成本提供出色的性能,适合模型开发和生产部署。

A40 基准测试, Nvidia A40, Ollama 基准测试, LLM A40, A40 测试, A40 GPU, Nvidia A40 GPU, A40 托管, A40 与 A6000 对比, LLM 托管, Nvidia A40 服务器, A100 与 A40 对比, H100 与 A40 对比, Ollama A40